本章の構成

このChapterでは,データに階層性がある場合の分析方法を紹介していきます。 マルチレベルな分析の中でも最も基本的な階層線形モデルをRで実行する場合には,lme4というパッケージがデファクトスタンダードになっていると思うのですが,この資料では,同等の機能を持ちながらより多くの状況(e.g., 過分散,ゼロ過剰,不均一分散)に対応可能なglmmTMBパッケージを使用します1 2。

9.1 マルチレベルデータとは?

マルチレベルデータ(階層データ)とは,異なる階層レベルを含む構造を持ったデータのことを指します。 社会科学の多くの研究分野では,個人が何らかの集団に所属しているという自然な階層構造が存在します。 教育研究では生徒が学校に,医療研究では患者が病院に,経済研究では従業員が企業に所属するといった具合です。

まずは,「データに階層性がある」ということの具体的な意味を詳細に説明した上で,なぜそのようなデータに対しては特別な分析法が必要なのかを直感的および数理的に示していきます。

9.1.1 マルチレベルデータの例(使用するデータ)

本Chapterでは,これまでとは異なるデータを使用します(さすがにこれまで使ってきたものでは無理でした……)。

↓本Chapterで使用するファイルのダウンロードはこちらから

school_id student_id read_score wants_univ belong1 belong2 belong3

1 001 0462 704.541 1 3 2 3

2 001 0850 569.687 1 4 3 4

3 001 0893 647.678 1 4 3 4

4 001 1063 672.170 1 4 4 4

5 001 1234 671.836 1 3 2 3

belong4 belong5 belong6 teach1 teach2 teach3 teach4 escs

1 3 3 3 4 2 2 4 1.2045

2 4 4 4 4 4 3 4 -0.0486

3 4 3 4 4 4 4 4 -0.2250

4 3 3 1 4 4 2 3 0.4586

5 4 2 3 2 2 2 2 -0.3454

sch_escs_mean s_t_ratio

1 0.4668657 15.5

2 0.4668657 15.5

3 0.4668657 15.5

4 0.4668657 15.5

5 0.4668657 15.5

[ reached 'max' / getOption("max.print") -- omitted 1 rows ]このデータは,経済協力開発機構(OECD)がおよそ3年に1度実施している生徒の学習到達度調査(PISA)の2018年実施分の日本のデータを加工したものです。 表 9.1 に,各変数の意味をまとめました。

chapter09.rdsの変数

| 変数名 | 説明 |

|---|---|

student_id |

回答者(生徒)のID |

school_id |

回答者(生徒)が所属する学校のID |

read_score |

PISA読解力の得点 |

wants_univ |

予想する最終学歴(進学希望の代理指標として)「あなたは,自分がどの教育段階まで終えると思いますか。:短期大学・高等専門学校あるいは大学・大学院」 |

belong1 |

所属感「学校ではよそ者だ(またはのけ者にされている)と感じる」 |

belong2 |

所属感「学校ではすぐに友達ができる」 |

belong3 |

所属感「学校の一員だと感じている」 |

belong4 |

所属感「学校は気後れがして居心地が悪い」 |

belong5 |

所属感「他の生徒たちは私をよく思ってくれている」 |

belong6 |

所属感「学校にいると,さみしい」 |

teach1 |

授業方法「先生は,私たちの学習の目標をはっきりと示す」 |

teach2 |

授業方法「先生は,私たちが学んだことを理解しているかどうか、確認するための質問を出す」 |

teach3 |

授業方法「先生は,授業の始めに、前回の授業のまとめをする」 |

teach4 |

授業方法「先生は,学習する内容を私たちに話す」 |

escs |

回答者(生徒)の社会経済的地位 |

sch_escs_mean |

学校ごとのescsの平均値 |

s_t_ratio |

ST比(教員1人あたりの生徒の数) |

なお,本Chapterでは基本的に,「読解力に影響を与える要因」の検討を目的とします。 したがって,被説明変数は一貫してread_scoreです。

PISAでは,(層化)二段階抽出によってサンプリングを行っています。 これは,全国の高校生から,

- (学校区分ごとに)対象となる高校を無作為に選ぶ

- 選ばれた高校の中から,受検する学生をランダムに(クラス単位で)選ぶ

という手順で抽出する方法です。 したがって,このデータの分析単位(各行の単位)は生徒一人ひとりですが,同時に各生徒は特定の学校に所属しており,複数の生徒が同じ学校に所属しているという構造のデータになっています3。

興味がある人もいるかも知れないので,本Chapterで使用するデータセットの作成に使用したRコードを掲載しておきます。 あくまでも補足なので,本編では封印していたdplyrの記法を使いますがご了承ください。

まずは,PISAデータをダウンロードします。 RにはEdSurveyというパッケージがあり,これを使うとPISAをはじめとした大規模調査データを簡単に取得できます。

# install.packages("EdSurvey")

library(EdSurvey) # PISAをはじめとした大規模調査データの取得用

library(dplyr) # データフレームの操作用

library(stringr) # 文字列の操作用

# PISA2018のデータのダウンロード

# かなり大きい&時間がかかるので要注意!

downloadPISA(years = 2018, root = "./")

# 日本のデータだけ使うので準備

pisa_jpn_edsurvey <- readPISA(path = "./PISA/2018", countries = "JPN")

# 使用する変数の選択

selected_vars <- c(

"cntstuid", "cntschid", "pv1read", "escs",

"st225q05ha", "st225q06ha", # 進学希望

paste0("st034q", sprintf("%02i", 1:6), "ta"), # 所属感の項目

paste0("st102q", sprintf("%02i", 1:4), "ta"), # 授業方法の項目

"stratio"

)

# データの抽出

pisa_df_raw <- getData(

data = pisa_jpn_edsurvey,

varnames = selected_vars,

addAttributes = FALSE

)ここまででデータの準備ができたので,あとは分析しやすいように色々と整形していきます。

pisa_final <- pisa_df_raw |>

rename( # 分かりやすい変数名に変更

school_id = cntschid, student_id = cntstuid,

read_score = pv1read, wants_univ1 = st225q05ha, wants_univ2 = st225q06ha,

belong1 = st034q01ta, belong2 = st034q02ta, belong3 = st034q03ta,

belong4 = st034q04ta, belong5 = st034q05ta, belong6 = st034q06ta,

teach1 = st102q01ta, teach2 = st102q02ta, teach3 = st102q03ta, teach4 = st102q04ta,

s_t_ratio = stratio

) |>

# 進学希望有無を二値変数に変換

mutate(wants_univ = as.numeric(wants_univ1 == "CHECKED" | wants_univ2 == "CHECKED")) |>

# 欠損値を持つ行を削除 (簡単化のため)

na.omit() |>

# 所属感の項目を数値に変換し,逆転項目の向きを反転

mutate(across(starts_with("belong"), as.numeric)) |>

mutate(across(c(belong2, belong3, belong5), function(x) 5 - x)) |>

# 先生の指導に関する項目を数値に変換し,すべて逆転

mutate(across(starts_with("teach"), as.numeric)) |>

mutate(across(starts_with("teach"), function(x) 5 - x)) |>

# レベル2の変数(学校平均ESCS)を作成

group_by(school_id) |>

mutate(sch_escs_mean = mean(escs, na.rm = TRUE)) |>

ungroup() |>

# IDの桁数を削る(必須ではない)

mutate(

school_id = sprintf("%03s", str_sub(school_id, -3, -1)),

student_id = sprintf("%04s", str_sub(student_id, -4, -1))

) |>

select( # 不要な変数を削除し,列の順番を整理

school_id, student_id, read_score, wants_univ,

belong1:belong6, teach1:teach4, escs, sch_escs_mean, s_t_ratio

) |>

# 並び替え

arrange(school_id, student_id) |>

# data.frameとして保存(tibbleでも良いが,資料中の一貫性から)

as.data.frame()

saveRDS(pisa_final, "chapter09.rds")9.1.2 階層性が生じるメカニズム

階層性が生じる理由は大きく分けて以下の3つです。

- 選択効果(Selection Effect)

- 似たような特徴を持つ個人が同じ集団に集まる傾向です。 例えば,公立の学校では,家庭の社会経済的地位が似た生徒は同じ地域(学区)に住むことが多いため,同じ学校に通う傾向が見られるでしょう。

- 処遇効果(Treatment Effect)

- 同じ集団に属する個人は,共通の処遇や環境を経験することで結果的に似たような特徴を持つようになることがあります。 同じ学校の生徒は,共通の教員,カリキュラム,設備の影響を受けるために,学力や進路希望なども(学校ごとに)似たものになるでしょう。 あるいは,同じ会社に勤務している人は,仕事に対する考え方などが似てくるかもしれません。

- 相互作用効果(Interaction Effect:ピア効果とも)

- 同じ集団に属する個人同士は,行動などを共にする機会が多いことで相互に影響し合うことがあります。 その結果として,集団内で特徴が似てくることもあるでしょう。 例えば学校では,同級生同士の学習態度や動機が相互に影響し合うはずです。

このように,データの階層性(集団内で似ている傾向)は,事前的にも事後的にも発生しうるものです。 どのように発生したものにせよ,階層性がある場合にはこれを考慮して分析する必要があります。

その中でも,特に階層性の因果関係をはっきりさせたい場合には,階層性のメカニズム(どの時点で発生したものであるか)の区別が非常に重要です。 例えば,学校において「相互作用効果によって学習意欲が向上するか」を検証することはかなり難しいとされています。 これは,階層データでは本質的に「クラスメイトが頑張っているから自分も頑張ろう,となる(ピア効果)」のか「もともと同程度に頑張る=同程度の学力の人たちが同じ学校に所属しやすい(選択効果)」のかが区別できないためです。 つまり,「類は友を呼ぶ」のか「友が類になる」のかが区別できないと,因果関係の方向性を特定することができないのです。

9.1.3 階層性を考慮する必要性

階層データの根本的な特徴は,観測単位間の依存性にあります。 分析の対象となる変数について,観測単位に依存性がある場合,普通の回帰分析や分散分析で分析すると,いくつかの問題が生じます。 まずはその問題を直感的に理解するため,簡単な「母平均の推定」を例に考えてみましょう。

シンプルな例

PISAの目的の中には,「世界各国の高校1年生の学習到達度」の評価があります。 日本の高校1年生の読解力の平均値(母平均)を知るために最も適切な方法がランダムサンプリングであることは明らかです。 しかし,高校生一人ひとりに個別にお願いをするのはかなり大変なので,PISAでは先に説明した二段階抽出を行っています。 では,「ある学校のある1つのクラス(40人)をランダムに選ぶ」場合,「完全ランダムに40人をサンプリングする」理想的な状況と比べて,母平均の推定はどうなるでしょうか。

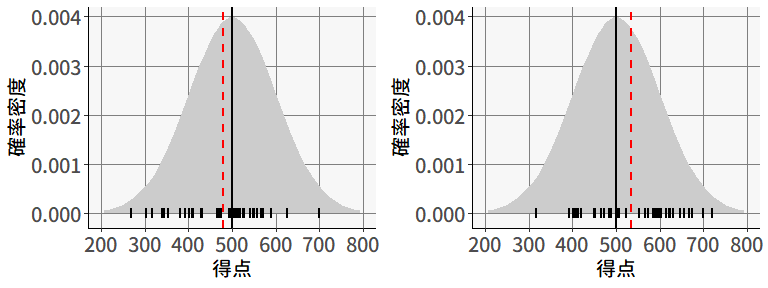

PISAの得点は,平均500,標準偏差100になるように調整された値なので,まずは理想的なランダムサンプリングを想定して,試しに正規分布\(N(500, 100^2)\)から40個の乱数を2回ほどサンプリングしてみましょう。 すると, 図 9.2 のような結果が得られました。

各図には,正規分布\(N(500, 100^2)\)の確率密度関数と,下のほうに実際にサンプリングされた40個の値が描かれています。 また,黒い直線は\(x=500\)を,赤い点線は標本平均を表しています。 このように,毎回のサンプリングは異なっていても,結果として得られる標本平均は,サンプルサイズに応じて母平均の周辺に集まる,という性質がありました(大数の法則)。

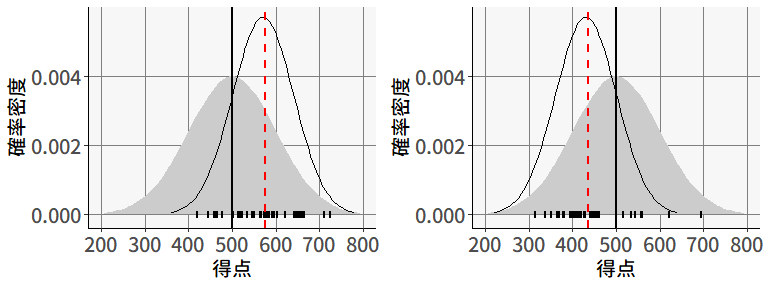

続いては,「ある学校のある1つのクラス(40人)をランダムに選ぶ」場合を考えてみます。 この場合,たまたま優秀な学校が選ばれる可能性もあれば,そうでもない学校が選ばれる可能性もあります。 図 9.3 の左は,たまたま優秀な学校が選ばれた場合を,右は優秀ではない学校が選ばれた場合を表しています。

この場合,あるクラスが抽出されると,そのクラスの中での学力レベルは全体の\(N(500, 100^2)\)よりも凝集していると考えられるため,その確率分布を線で表しています4。 その結果,図 9.2 と比べると,どのクラスが選ばれるかによって,標本平均は大きく変動することがわかります。

図 9.2 と 図 9.3 の対比は,データに階層性がある場合,理想的な状況と比べてサンプリングの効率が低下することを意味しています。 ここで,標本平均の標本分布は,サンプルサイズを用いて,正規分布\(N\left(\mu, \frac{\sigma^2}{n}\right)\)と表せることを思い出してください。 この式に基づくと,\(n=40\)の場合( 図 9.2 )の標本平均の標本分布は,\(N\left(500, \frac{100^2}{40}\right)\approx N(500, 15.81^2)\)となります。 そして,二段階抽出の場合( 図 9.3 )には,どうやら標本平均の標本分布の分散は,これよりも大きくなりそうなので,\(N\left(\mu, \frac{\sigma^2}{n}\right)\)に基づいて標本分布を構成してしまうと,色々と問題がありそうだと分かるのです5。

以上は,母平均の推定においてデータの階層性に注意して分析を行うべきであることの簡単な説明でした。 ほかの分析手法においても同様に,完全なランダムサンプリングを前提に構築された手法を,階層性のあるデータに適用すべきではないことが多々あるわけです。

生態学的誤謬

ここでもう一つ,データの階層性を無視することが明確に誤った結論を導く有名な例を紹介しておきます。

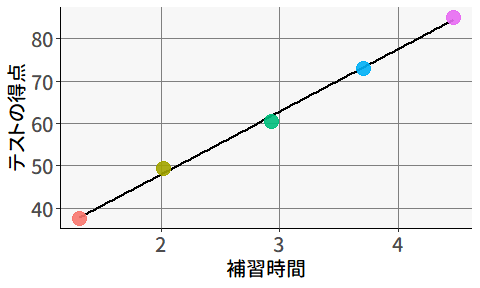

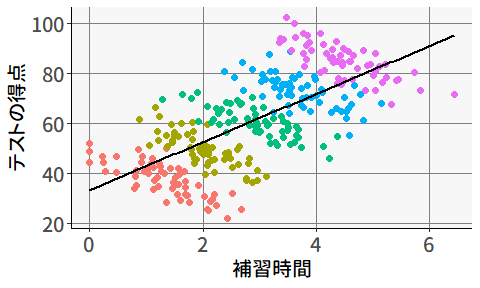

ある研究者が,「教育熱心な地域ほど学力が高い」という仮説を立てました。 これを検証するため,(「教育熱心度」の代理指標として)学校の授業以外の学習時間(塾・補習など)が長いほど学力が高いかを調べるために,5つの地域からそれぞれ60人ずつのデータを収集しました。 図 9.4 は,地域ごとに計算した平均値に基づいて回帰分析を行った結果です。

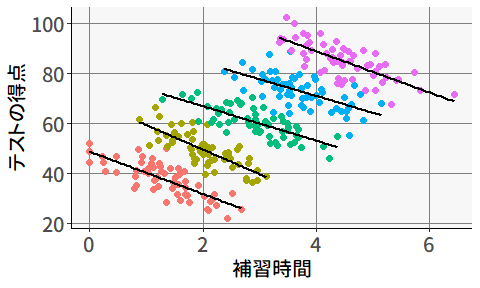

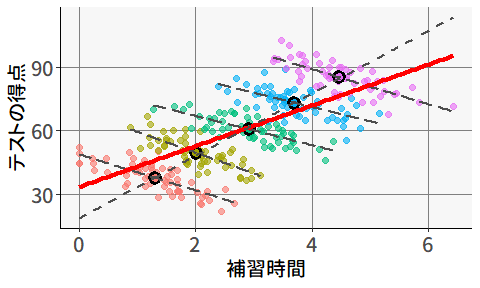

この結果を見ると,補習時間と学力の間にはかなり強い正の相関がありそうです。 ただし,この結果は「補習時間が長い個人ほど学力が高い」ということは意味しません。 実際に,個人レベルで見ても2つの変数に正の相関があるかは場合によります。 実際に,地域(散布図の点の色)ごとにそれぞれ回帰分析を行ってみると,個人レベルでは,補習時間が長いほどむしろテストの得点が低いことがわかります( 図 9.6 )。

このように,集団レベルで見られた関係性が,個人レベルにも自動的に当てはまる,ということは決してありません。 にも関わらず,個人と集団をごっちゃに考えてしまい誤った推論を行ってしまうことを,生態学的誤謬 (ecological fallacy: Robinson, 1950) と呼びます。 データの階層性を無視して分析を行うことは,生態学的誤謬の餌食になってしまう可能性があるわけです。

ちなみにこのデータに関しては,集団平均を使わずに個人レベルのデータでそのまま回帰分析を行った場合も,正の傾きが見られます( 図 9.6 )。

このように,データ全体を個人レベルで分析した場合と,集団ごとに分析した場合に全く異なる結論が導き出されることは,生態学的誤謬の中でもシンプソンのパラドックス (Simpson, 1951) などと呼ばれています。

生態学的誤謬およびシンプソンのパラドックスに関して厄介なのは,この場合どちらのメカニズムもある程度妥当な解釈が可能である,という点です。 図 9.5 に示されているように,補習時間が長いほどテストの得点が高くなる,というのは直感的に有り得そうですし, 図 9.5 のように集団内では負の関係が見られる,というのも,「もともとの学力が低い生徒ほど補習させられている」と考えると納得が行きます。

このため,階層データに対しては,データの階層性を正しく理解して適切な分析手法を適用するだけでなく,集団レベル・個人レベルの変数がどのように影響するかを考えることが重要となります。

9.1.4 階層構造の表現

ここで,これ以降の説明のために,階層構造の基本的な表記を説明しておきます。 必然的に添え字が複数になるので,混乱しないように気をつけてください。 本資料では,階層データのレベルに合わせて添字を以下のように表します6。

- レベル1(個人[\(p\)erson]レベル): \(p = 1, 2, \ldots, n_g\)(第\(g\)集団内の個人)

- レベル2(集団[\(g\)roup]レベル): \(g = 1, 2, \ldots, G\)(集団)

例えば\(x_{pg}\)は,「第\(g\)集団の中の\(p\)番目の人の\(x\)の値」を表しているわけです。

なお,レベル1が「個人」,レベル2が「集団」を表す,というのは,あくまでも本Chapterで使用するPISAのデータに関する話です。 これ以外にも,例えば同じ人から定期的に何度も測定を行うことで変化を観察する(縦断的な)測定の場合には,レベル1が「時点」,レベル2が「個人」となります。

また,理論的には階層はいくつでも考えることができます。 例えばPISAデータの場合には,国\(\rightarrow\)学校\(\rightarrow\)個人という3つの階層を考えることもできますし,アメリカであれば州ごとにも教育政策が異なるため,国\(\rightarrow\)州\(\rightarrow\)学校\(\rightarrow\)個人という4つの階層を考えることもできるでしょう。

もちろん階層を増やすほど,分析のモデルは複雑になり,必要なサンプルサイズも増加します。 ただ,理論的には考えることはできるので,本当に必要な時が来たら考えてみてください。

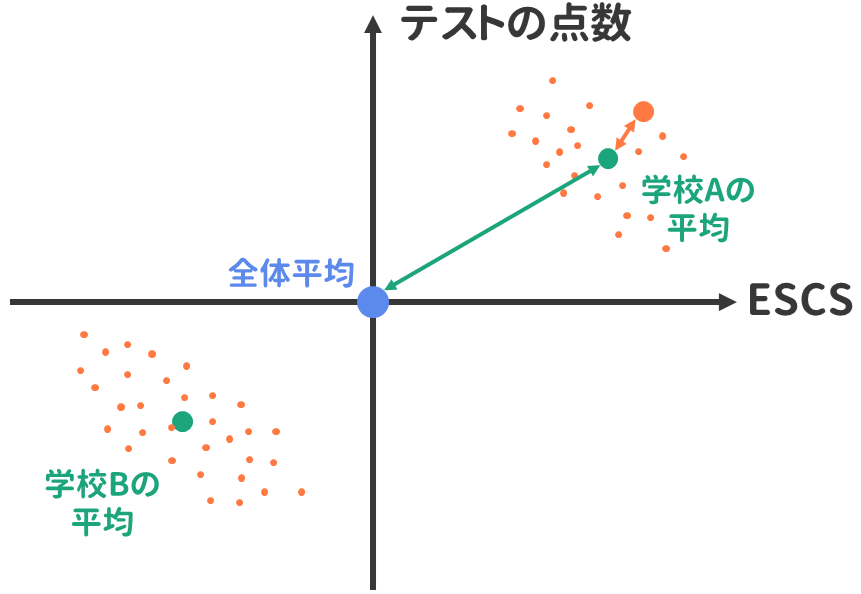

9.1.5 変動の分解

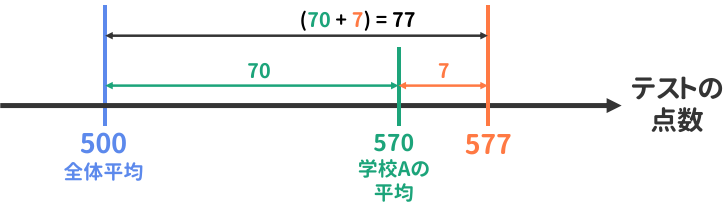

データの階層性を考慮するためには,まずある変数の値のばらつきが複数の要素に分解されるという考え方を理解する必要があります。 例えば,PISAの平均点が570点のとあるクラスの生徒が577点を獲得した場合,これは \[ x_{pg} = 500 + \overbrace{70}^{全体平均とクラス平均の差} + \overbrace{7}^{クラス平均との差} = 577 \tag{9.1}\] と表すことができます( 図 9.7 )。 このとき,「全体平均とクラス平均の差」は,言わば集団レベルの変動を意味しています。 一方「クラス平均との差」は,集団内での個人レベルの変動を意味します。

分解に基づく回帰分析の表現

このように変数を「全体平均と集団の平均の差」と「集団の平均と個人の値の差」に分解すると,単回帰分析は \[ \begin{alignedat}{3} y_{pg} &= \beta_0 + & &\beta_1x_{pg} & &+ u_{pg} \\ &= \beta_0 + & &\beta_1[(x_{pg}-\bar{x}_{\cdot g})+\bar{x}_{\cdot g}] & &+ u_{pg} \end{alignedat} \tag{9.2}\] と表すことができます。 ここで,\(\bar{x}_{\cdot g}\)は集団\(g\)の平均値 \[ \bar{x}_{\cdot g} = \frac{1}{n_g} \sum_{p=1}^{n_g}x_{pg} \tag{9.3}\] を表しています。 (9.2)式からは,回帰分析における傾き\(\beta_1\)が集団レベルと個人レベルの両方の変動に対して影響する係数であることが分かります。 これは,例えば\(\beta_1>0\)であった場合に,

- \((x_{pg}-\bar{x}_{\cdot g})\)の値が大きい,すなわち集団内で相対的に値が大きい個人ほど\(y_{pg}\)の値も大きい

- \(\bar{x}_{\cdot g}\)の値が大きい集団ほど\(y_{pg}\)の値も大きい

という2つの効果が混ざっていることを意味します。 したがって,階層性を考慮したモデルで推定しない限り,\(\beta_1\)の効果を正しく解釈することは非常に難しいのです。

図 9.8 は,生態学的誤謬の例として示したプロットです。 集団(学校)ごとに求めた回帰係数は負の値となっている一方で,集団の平均値(黒丸)に基づいて求めた回帰直線は正の値となっていました。 ここでのポイントは,個人のデータレベルで求めた回帰直線(赤い線)が,集団ごとに求めた回帰直線と,集団平均に基づいて求めた回帰直線の傾きの中間になっているということです。 これこそが,「2つの効果が混ざっている」ことを示しています。

9.2 マルチレベル分析の出発点:分散分析

セクション 9.1.5 で見たように,階層性のあるデータの分析では,ある変数の値の変動を「集団レベル」と「個人レベル」のようにレベル毎に分解して考えます。 そのような分析の代表例として,(マルチレベルモデルなどは聞いたことがない人でもきっとご存知の)分散分析というものがあります。

分散分析自体の説明はここでは省略しますが,Rでは,aov()という関数によって,以下のように一要因の分散分析は簡単に実行可能です7。

分散分析では,「すべての集団の平均値が等しい」という帰無仮説を設定し統計的仮説検定を行います。 この際に使用する検定統計量\(F\)(F value,今回は21.38)は,簡単に言えば「集団レベルの変動( 図 9.7 の緑の矢印の長さ)」と「個人レベルの変動(オレンジ色の矢印の長さ)」の比に基づいており,集団レベルの変動が十分に大きければ「集団ごとに平均値が異なる」と判断しています。 したがって,とりあえずまずは分散分析を行えば,集団ごとに平均に差がある=データの階層性を考慮した分析手法を採用すべきか,が分かりそうな気がします。

このように,マルチレベル(階層線形)モデルは,分散分析を拡張したような形になっているのですが,実際にはもう少し考えなければいけないことがあります。 マルチレベルモデルの適用に際しては,集団ごとの変動に関する重要な考え方の違いを理解しておく必要があるのです。

9.2.1 固定効果と変量効果

分散分析が行っているのは,実際に観測された各学校の間に平均的な差があるかの検証です。 これは,各学校の差を詳細に検討したいような状況を想定しています(例:同じ市内の中学校の間に差があるか)。 したがって,分散分析から分かることは「そのデータの中にある学校間では平均値に差がある」ということです。

一方で,PISAデータの分析では,抽出された学校が具体的にどの学校であるかは問題ではありません。 たまたま無作為抽出でその学校が選ばれたからデータに含まれているだけで,何らかの理由でその学校が別の学校に変わったとしても,基本的には何も問題ないでしょう。 このように,一つ一つの集団には具体的な関心がなく,一般論としての「学校ごとの違い」などに関心があるような場合,分散分析では結果が「そのデータの中」に限定されてしまうため,別のアプローチのほうが良いと考えられます。 そこで,集団の平均値自体を確率変数とみなして,観測値はその実現値だと考えるのです。

このように,データの階層構造を考えるときには,レベル2以上の要素について「一つ一つの具体的な値に関心があるか」を明確に区別して考える必要があります。 具体的には,説明変数の効果は固定効果(fixed effects)と変量効果(random effects)のいずれかに分類されます。

固定効果(Fixed Effects)

固定効果とは,母集団の中で値が固定されている(決まっている)と見なされる効果のことです。 「固定」された値があると見なすならば,その値自体に関心があるわけで,そのために特定の集団を名指しで指定してデータを収集しているのです。 例えば,「性別による学力の差」を分析する場合,性別の効果は固定効果として扱います。 これは,男性と女性という2つのカテゴリが明確に定まっており,その効果の大きさ(回帰係数)が母集団全体で一定であると考えるためです。

各学校の平均値差を固定効果と見なして行う分散分析は,実は回帰分析の形で以下のように表すことができます。 \[ y_{pg} = \beta_0 + \beta_{02} x_{g=2} + \beta_{03} x_{g=3} + \cdots + \beta_{0G} x_{g=G} + u_{pg} \tag{9.4}\] ここで\(x_{g=g}\)は,その生徒が学校\(g\)に所属している場合は1をとり,それ以外では0となるダミー変数です。 したがって,上の式は集団\(g\)ごとに \[ \begin{alignedat}{3} y_{p1} &= \beta_0 &&+u_{p1} &&\quad (g=1) \\ y_{p2} &= \beta_0 +\beta_{02}&&+u_{p2} &&\quad (g=2) \\ y_{p3} &= \beta_0 +\beta_{03}&&+u_{p3} &&\quad (g=3) \\ &\vdots\\ y_{pG} &= \beta_0 +\beta_{0G}&&+u_{pG} &&\quad (g=G) \\ \end{alignedat} \tag{9.5}\] と書き分けることができます。 つまり,各ダミー変数に関する回帰係数\(\beta_{0g}~(g=2,3,\cdots,G)\)は,基準となる集団(上の式は\(g=1\))との平均値差を表している,と言えます。

そしてこのとき,分散分析の検定は,\(\beta_{0g}~(g=2,3,\cdots,G)\)がすべて0であるかを評価することと,数学的には同じことなのです。 実際に,school_idについてダミー変数化した回帰分析を行ってみましょう。 回帰分析を行うlm()関数では,説明変数が名義尺度(character型など)の場合,自動的にダミー変数化して分析を実行してくれます。

Call:

lm(formula = read_score ~ school_id, data = dat)

Residuals:

Min 1Q Median 3Q Max

-323.86 -49.34 0.37 50.13 275.00

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 621.2408 12.6256 49.205 < 2e-16 ***

school_id002 -148.3601 17.9861 -8.249 < 2e-16 ***

school_id003 -159.6712 18.9384 -8.431 < 2e-16 ***

school_id004 -115.5121 18.1239 -6.373 2.00e-10 ***

school_id005 -212.7595 18.4223 -11.549 < 2e-16 ***

school_id006 -9.3313 18.1239 -0.515 0.606669

[ reached 'max' / getOption("max.print") -- omitted 177 rows ]

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 74.69 on 5583 degrees of freedom

Multiple R-squared: 0.4107, Adjusted R-squared: 0.3915

F-statistic: 21.38 on 182 and 5583 DF, p-value: < 2.2e-16出力の(Intercept)は(9.4)式の\(\beta_0\),すなわちschool_id==001の学校の平均値を表しています。 そして,続くschool_id***は,それぞれの学校のschool_id==001との差を表しているわけです。 最も重要なポイントは,一番下に出力されている検定統計量(F-statistic)の値が,先程の分散分析のときと同じ(21.38)であるという点です。 これが,ダミー変数を用いた回帰分析と分散分析が数学的には等価であることを示しています。

平均値の違いを固定効果とみなした分析の結果は,例えば分散分析であれば「そのデータに含まれる学校の間には,平均値に差がある/ない」というものです。 したがって,この結果をもって「一般的に,世の中の学校(母集団全体)において平均値に差がどの程度あるか」までは分かりません(差があることくらいは分かったとしても)。 また,係数\(\beta_{0g}\)は,あくまでもその集団\(g\)ごとに個別に計算される値なので,複数の集団間の\(\beta_{0g}\)を比べるような分析,例えば「どのような特徴を持った集団ほど\(\beta_{0g}\)が大きい=平均値が高いのか」といった分析には不都合です8。

変量効果(Random Effects)

変量効果とは,母集団の中で確率的に変動する効果のことです。 これは先程説明したように,個々の集団の具体的な値はただの確率変数の実現値に過ぎず,再び同じようにランダムサンプリングを行えば異なる集団・異なる値になるだろう,と考えることを意味します。 PISAデータの例では,学校の効果は変量効果として扱います。 これは,データに含まれる具体的な学校(例:A高校,B高校)がたまたま抽出されただけであり,他の学校が抽出されても同様の分析を行いたいためです。

平均値の差を変量効果として扱う場合,もちろん「(特定の)A高校とB高校では具体的に平均値がどの程度(何点くらい)違うのか」を調べることには興味がありません。 代わりに「全体的に,学校ごとに平均値はどの程度のばらつきを持っているのか」を調べることになります。 このため数学的には,学校ごとの平均値差を変量効果として扱う場合,もはやパラメータ(\(\beta_{0g}\))でもないため表記を\(u_{pg}\)に変えて9, \[ u_{0g} \sim N(0, \sigma^2_{0g}) \tag{9.6}\] のように正規分布に従う確率変数であると仮定します。 このとき,分散分析のモデル式は(9.5)式とほぼ同じで良いのですが,少し変えて \[ y_{pg} = \mu +u_{0g} + u_{pg} \tag{9.7}\] となります。 なお,固定効果の場合の分散分析では,\(\beta_0\)は「集団\(g=1\)の平均値」を表していましたが,変量効果の場合の分散分析では,\(g=1\)も含めたすべての集団に対して付与される\(\beta_{0g}\)が平均0と仮定されている(9.6式)ため,パラメータ\(\mu\)はそのまま全体平均を表しています。

判断基準

ある要因を固定効果として扱うか変量効果として扱うかは,慣れないうちはなかなか悩むと思います。 基本的な判断の基準は,以下のような感じです。

固定効果として扱う場合:

- カテゴリ数が少ない

- 具体的なカテゴリの効果に関心がある(性差・地域差の比較など)

- カテゴリが理論的に意味を持つ(その学校を選んだことに必然性がある)

変量効果として扱う場合:

- カテゴリ数が多い

- 個々のカテゴリよりも変動の大きさに関心がある

- カテゴリ自体がランダムサンプリングされている(その学校である必要はない)

また,実用的な観点からは,サンプルサイズについても考慮する必要があります。 変量効果として扱うには,各レベルに十分なサンプルが必要です。 というのも,変量効果として扱う場合には,その変量効果のばらつき(\(\sigma^2_{0g}\))が推定の対象となるためです。 一般的には,レベル2のカテゴリ(例:学校)が30以上あることが推奨されます。 とはいえ,統計的な基準だけでなく,研究の理論的背景も考慮して決めなくてはいけません。 例えば,もしもリソースの都合によって,5つの学校からしかデータを集めることができなかったとしても,「一般的に学校ごとに差があるか」を評価したいのであれば,やはり(多少無理はあるにせよ)変量効果として分析するほうが良いかもしれません。

9.3 階層線形モデル

ここからは,集団ごとの違いを変量効果とみなした分析の実践に入っていきます。 まずは,最も基本的な回帰分析のマルチレベルモデルについて見ていきます。

9.3.1 ランダム切片モデル

階層線形モデル(Hierarchical Linear Model [HLM])の最も基本的なモデルは,先ほど説明した分散分析において,集団ごとの平均値差を変量効果に置き換えただけのモデルとされています。これを,ランダム切片モデル(random intercept model)と呼びます。 すでに部分的にはところどころで説明しているのですが,ここでまとめて,改めて「マルチレベルモデルの出発点」をおさえておきます。

これから紹介するモデルは,分野の慣習や,モデルのどの側面に注目するかによって,マルチレベルモデルや階層線形モデル以外にも異なる名称で呼ばれることがあります。

すべてのモデルには,必ず固定効果と変量効果が最低1つずつは含まれます。そのため混合効果モデル(mixed effects model)とも呼ばれることがあります。 とはいえ,やはりこのモデルのキモは変量効果にあり,そもそも回帰分析では固定効果がないモデルは存在しないことから,変量効果モデル(random effects model)やランダム係数モデルと(random coefficient model)いう名称もあります。

特に分野が異なる人と会話するときには,実は同じモデルを指しているのに,異なる名称で呼ばれている可能性があるので,まずはモデル式を見るようにすると良いかもしれません。

モデルの基本構造

ランダム切片モデルの最も基本的な形は,説明変数を含まない切片のみのモデル(null model または unconditional model)です。このモデルは,セクション 9.1.5 で説明した変動の分解の考え方を直接的に表現したものです。

数学的表現

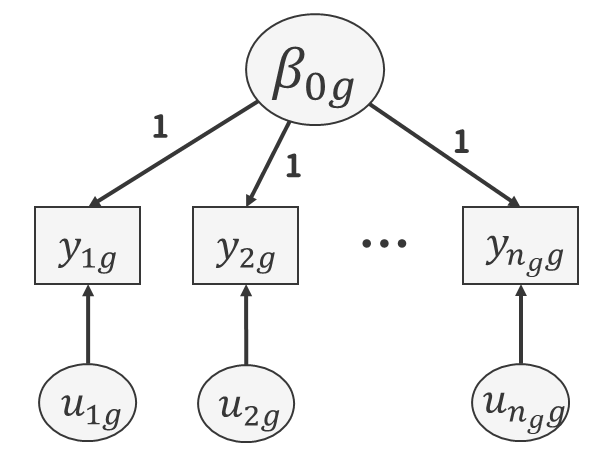

マルチレベルモデルでは,基本的に回帰式をレベルごとに作成することを考えます。 基本的なランダム切片モデルを表す場合には, \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} + u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu + u_{0g} \end{alignedat} \tag{9.8}\] という要領です。 回帰式っぽく見えないかもしれませんが,これも立派な「説明変数のない回帰分析」の形です。 なお,式中の各項はそれぞれ

- \(y_{pg}\):第\(g\)集団の\(p\)番目の個人の従属変数の値

- \(\mu\):全体の平均

- \(u_{0g}\):第\(g\)集団の切片の全体平均との差

- \(u_{pg}\):個人レベルの誤差項(集団平均との差)

をそれぞれ表しています。 このモデルにおいて,\(u_{0g}\)および\(u_{pg}\)は変量効果に相当する項である一方,全体平均\(\mu\)は固定効果に相当します。 このように,階層線形モデルには必ず固定効果と変量効果が含まれています。

もちろん(9.8)の2つの式を組み合わせて, \[ y_{pg} = \mu + u_{0g} + u_{pg} \tag{9.9}\] のように表しても良いのですが,後ほど回帰分析の説明変数が追加されるときに,どちらのレベルの説明変数なのかを区別しやすいように,レベルごとに表記するのがおすすめです。

変量効果の仮定

変量効果と誤差項については,以下の仮定を置きます。 \[ \begin{aligned} u_{0g} &\sim N(0, \sigma^2_{0g}) \\ u_{pg} &\sim N(0, \sigma^2_{pg}) \\ \sigma_{u_{0g}, u_{pg}} &= 0 \end{aligned} \tag{9.10}\] 上2つの仮定は単に,集団レベル・個人レベルの変動を,それぞれ異なる正規分布に従う確率変数(変量効果)と見なすことを意味しています。 また,一番下の仮定は,集団レベルと個人レベルの変動が無相関であることを意味します。

以上の仮定のもとでは,\(y_{pg}\)の分布は \[ y_{pg} \sim N(\beta_{0g}, \sigma^2_{pg}) \tag{9.11}\] という形で表すことも可能であり,これが尤度関数を形作ります。 つまり,集団\(g\)に属する個人\(p\)の値\(y_{pg}\)は,集団\(g\)の平均\(\beta_{0g}\)を中心に,個人レベルの誤差項\(u_{pg}\)に従う正規分布に従うと考えるわけです。 これにより,各集団\(g\)の尤度関数は単純に正規分布の掛け算として表現されます。

モデルの意味

このモデルは,被説明変数の値の変動を, \[ y_{pg} = \overbrace{\mu}^{全体平均} + \overbrace{u_{0g}}^{集団平均と全体平均の差} + \overbrace{u_{pg}}^{個人値と集団平均の差} \tag{9.12}\] つまり,「全体平均」「集団効果」「個人効果」の3つの成分に分解したものです。 そして,(9.10)式の仮定のもとでは,被説明変数の総分散は以下のように分解されます。 \[ \sigma_{y}^2 = \sigma^2_{0g} + \sigma^2_{pg} \tag{9.13}\]

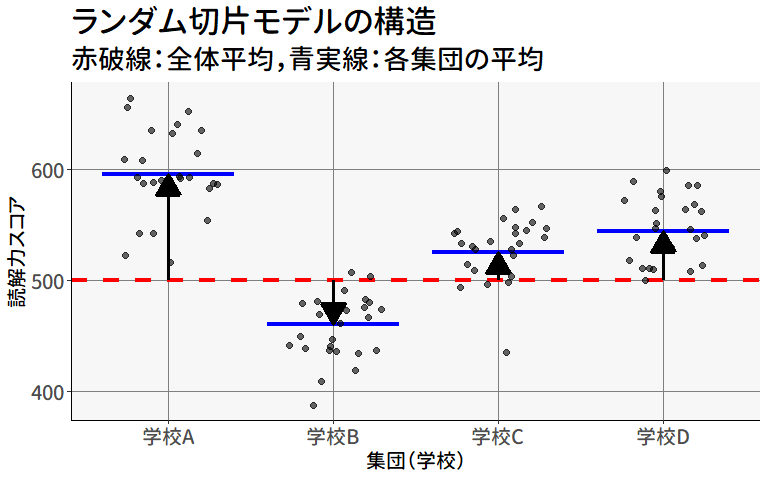

図 9.9 は,ランダム切片モデルのイメージ図です。 全体平均を表す赤い点線(\(\mu\))と,各グループの平均値(\(\beta_{0g}\))を表す青い実線の間の距離(矢印の長さ)が\(u_{0g}\)に相当し,この長さの母分散が\(\sigma^2_{0g}\)となります。

このモデルは,マルチレベル分析の出発点となる最も基本的なモデルです。 後ほど説明変数を追加していきますが,まずはこのモデルでデータの階層構造と変動の分解を理解しましょう。

Rでのランダム切片モデルの実装

Rでマルチレベルモデルを推定するには,パッケージと同名のglmmTMB()関数を使用します。

Family: gaussian ( identity )

Formula: read_score ~ (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66670.7 66690.7 -33332.3 66664.7 5763

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 3624 60.2

Residual 5579 74.7

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.58e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 503.699 4.562 110.4 <2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1glmmTMB()関数は,通常の回帰分析の関数lm()と似たような構文formulaを取ります。 ただし,固定効果と変量効果を明確に区別するために,少し特殊な記法を使用します。

通常の(school_idの効果を固定効果とした)lm()では,read_score ~ school_idと記述していました。 変量効果とする場合,この右辺のschool_idの部分を(1|school_id)に書き換えます。 このように,カッコの中の縦棒(|)の右側には,変量効果として扱う説明変数を書きます。 そして左側には,「レベル2の回帰分析の説明変数」を書きます(詳細は セクション 9.3.5 にて)。 とりあえず現時点では,そのような説明変数はまだ考えていないので,school_idによる変量効果の平均値(切片)を表す1だけを書いておきます。

lme4パッケージの場合の解説

上記の分析をlme4パッケージで実行する場合には,lmer()関数を使用します。 ただし引数は基本的にglmmTMB()関数と同じなので,パッケージを読み込んでいれば,関数名を変えるだけでOKです。

lme4)

Linear mixed model fit by maximum likelihood ['lmerMod']

Formula: read_score ~ (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66670.7 66690.7 -33332.3 66664.7 5763

Scaled residuals:

Min 1Q Median 3Q Max

-4.3531 -0.6575 0.0101 0.6729 3.6592

Random effects:

Groups Name Variance Std.Dev.

school_id (Intercept) 3624 60.2

Residual 5579 74.7

Number of obs: 5766, groups: school_id, 183

Fixed effects:

Estimate Std. Error t value

(Intercept) 503.699 4.562 110.4ただし,lmer()関数には,少し注意点があります。 まず,lmer()関数では少なくとも1つは変量効果が必ず含まれていないと実行できません。 したがって,間違えてschool_idを固定効果のように書いてしまった以下のコードではエラーとなります。 変量効果がないならば,素直にlm()を使っておけ,ということですね。

Error: No random effects terms specified in formulaなおglmmTMB()関数では,変量効果がない場合でも推定を行ってくれます(つまり通常のlm()関数も内包している)。

また,lmer()関数では,デフォルトで制限付き最尤法(REstricted Maximum Likelihood [REML])による推定が行われます。 細かい説明は省略するのですが,実は セクション 9.3.6 で説明するモデル比較においては,多くの場合でREML = FALSEとして通常の最尤法(ML)に変更しておかないと正しくない (川端,2019) ので,この引数の意味が分からなくても,こだわりが無ければ基本的にREML = FALSEをつけて実行するようにしてください。

なおglmmTMB()関数にも引数REMLは用意されているのですが,上述の理由からかデフォルトがfalseになっています。 したがって,glmmTMB()関数を使用する場合はREMLを明示的に使用したい場合だけ設定する必要があるということです。

改めて結果を見ると,Random effects:とConditional model:という形で,変量効果と固定効果が別々に記載されていることがわかります。

まず,Conditional model:には,固定効果として,ここではレベル2の回帰分析(9.8式)の結果が示されています。 といっても現時点では説明変数は何もないので,(Intercept)すなわち切片(全体平均)のみが示されています。 Estimateの503.699という値は,各集団の平均値(\(\beta_{0g}\))の期待値(\(\mu\))が503.699点,ということを意味します。 注意が必要な点として,これは個人レベルの全体平均の推定値とは異なる統計量です。 実際に,分析に使用しているデータについてread_scoreの平均値を計算すると,以下のようになります。

いま計算した個人レベルの標本平均は,集団のサンプルサイズの違いの影響を強く受けます。 極端な例を上げると,\(n_g=10000\)の学校1つと,\(n_g=10\)の学校99校のデータを混ぜた場合,個人レベルの標本平均は,ほぼ\(n_g=10000\)の学校の平均値によって決まるでしょう。 一方で,集団平均の期待値は,100校のデータをまんべんなく使用して算出されるべきです。 もちろんサンプルサイズの違いによって集団平均の推定精度が異なるため多少の重み付けは必要なのですが,このあたりをうまく調整した推定が行われるために,やや異なる値が得られるのです。

Random effects:には,変量効果の分散および標準偏差が示されています。 Groupsにはformulaのカッコ内の右側に書いた変数名(集団レベルの変数)が,Nameには左側に書いた変数名(レベル2の回帰分析の説明変数)が記されています。 したがって,school_id (Intercept)と記された行の値が,集団平均の分散(\(\sigma_{0g}^2\))および標準偏差を表しています。 同様に,Residualは残差を表しているので,これが個人レベルの分散(\(\sigma_{pg}^2\))および標準偏差を意味します。

以上の結果をランダム切片モデルの回帰式(9.8および9.10式)に代入すると, \[ \begin{alignedat}{3} \text{(レベル1)} \quad y_{pg} & = \beta_{0g} &&+ u_{pg}, &&\qquad u_{pg}\sim N(0, 74.7^2) \\ \text{(レベル2)} \quad \beta_{0g} & = 503.699 &&+ u_{0g}, &&\qquad u_{0g}\sim N(0, 60.2^2) \end{alignedat} \tag{9.14}\] という形になります。

なお,(9.13)式では,\(y_{pg}\)の総変動\(\sigma_y^2\)を2つの変量効果の分散の和に分解できると説明しました。 これも,全体平均\(\mu\)のときと同様に,観測された標本分散および不偏分散とは異なる値となります。 これは,データの階層構造を考慮しているか,そして計算方法の違いによって当然起こる違いです。

集団ごとの切片(\(\beta_{0g}\))は変量効果として扱われているため,モデルの中で直接推定されることはありません。 ただし,(制限付き)最尤法による推定の副産物として,事後的に各グループの切片(\(\beta_{0g}\))を計算することはできます。

coef()関数は,回帰係数を取得する関数ですが,glmmTMB()の結果に対しては,変量効果の平均値(切片)を集団ごとに計算してくれます。 この結果から,例えばschool_id == 001の学校の切片は616.2887と高く,この学校が相対的に他の学校よりも数学の学力が高いことなどがわかります。

9.3.2 階層性を考慮すべきか

ここまでに説明してきたランダム切片モデルがマルチレベルの出発点である理由は,このモデルによってそもそも階層性を考慮して分析する必要のあるデータなのかを検討できるためです。

社会科学におけるデータの多くには,何らかの形で階層性があると考えられます。 しかし,必ずしもその階層性を踏まえた分析を行わなくても良いケースもあります。 例えば,「数学の学力」を被説明変数とする場合にデータの階層性を意識する必要があるのは,「数学の学力」自体が学校ごとに平均的に異なると考えられるためです。 したがって,同じようにいくつかの学校から二段階抽出によってサンプリングされたデータであっても,例えば「運動の頻度」などの,学校(レベル2)よりは個人・家庭(レベル1)によって決まるような変数に関心がある場合には,わざわざマルチレベルモデルを使う必要は無いかもしれません10。 そこで,マルチレベルモデルの必要性をある程度統計的に判断するための具体的な基準を示します。

級内相関係数

セクション 9.1.5 で示した形で,変数の変動を「個人レベル」と「集団レベル」に分解すると,回帰係数に個人・集団レベルの効果が混ざること( 図 9.8 )や 標本平均の計算における二段階抽出の影響( 図 9.3 )は,総変動に占める集団レベルの変動の割合によって決まるということが見えてきます。

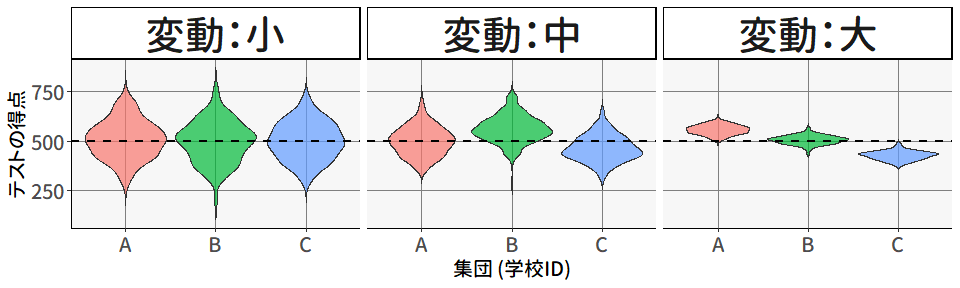

図 9.10 には,3つの学校からサンプリングされたテストの得点について,学校ごとに作成したバイオリンプロットが描かれています。 3つのプロットのいずれについても,3つの学校のデータをくっつけてテストの得点の分布を求めると,平均500,標準偏差100になるように設計されています。 図 9.7 にあるように,変動を分解して考えると,集団間の変動が大きいほど集団内の変動は小さくなります。

図 9.10 の左は,集団レベルの変動がほとんどないケースです。 この場合,各学校の平均値\(\bar{x}_{\cdot g}\)は,すべて全体平均\(\bar{x}\)と近い値になります。 そこで,\(\bar{x}_{\cdot g}=\bar{x}\)として(9.2)式を少し変形させると, \[ \begin{aligned} y_{pg}&= \mu &+& \beta_1[(x_{pg}-\bar{x}_{\cdot g})+\bar{x}_{\cdot g}] &+ u_{pg} \\ &=\mu &+& \beta_1[(x_{pg}-\bar{x})+\bar{x}] &+ u_{pg} \\ &=\mu + \beta_1\bar{x} &+& \beta_1(x_{pg}-\bar{x}) &+ u_{pg} \\ &= \mu^{*} &+& \beta_1(x_{pg}-\bar{x}) &+ u_{pg} \end{aligned} \tag{9.15}\] と書き換えることができます。 したがって,単純に説明変数を全体平均で中心化して切片を調整しただけの普通の回帰分析の形になることから,わざわざマルチレベルの分析を行う必要が無いことがわかります。

同様に,標本平均の計算(母平均の推定)を考えた場合も,集団ごとの違いが見られない場合は,仮に単一の学校からサンプリングを行ったとしても,あるいは学校にとらわれずに全体からランダムサンプリングしたとしても,同じような結果が得られると考えられます。 したがって,わざわざ階層性を考慮せずとも,普通に個人レベルで分析を行えば良いでしょう。

一方 図 9.10 の右は,集団レベルの変動が大きい場合です。 このときには,明らかに,\(\bar{x}_{\cdot g}=\bar{x}\)ではないことから,(9.15)式のように変換することはできず,結果として\(\beta_1\)には個人レベルと集団レベルの効果が混ざることになります。 したがって,マルチレベルの分析が必要となります。 これは,簡単に言えば\((x_{pg}-\bar{x})\)に対する回帰係数と\(\bar{x}\)に対する回帰係数を別々に設定して \[ y_{pg}= \beta_0 + \beta_{1}(x_{pg}-\bar{x}_{\cdot g})+\beta_{2}\bar{x}_{\cdot g} + \varepsilon_{pg} \] としてあげると良さそうです(詳細は後ほど)。 マルチレベルな分析の本質は,このように集団レベルの変数\(\bar{x}\)と個人レベルの変数\((x_{pg}-\bar{x})\)を同時に用いて,個別に効果を評価することにあると言えます。

以上に基づき,マルチレベルな分析手法を採用すべきかどうかを判断するための定量的な指標を,集団レベルの変動の割合に基づいて定義していきましょう。

(9.13)式に示されていたように,ランダム切片モデルのもとでは,ある変数\(y_{pg}\)の全体の分散は\(\sigma^2_{0g}+\sigma^2_{pg}\)と単純な和の形に分解することができました。 したがって,全体の変動に占める集団レベルの変動の割合は,単純に \[ \text{ICC} =\frac{\sigma^2_{0g}}{\sigma^2_{0g}+\sigma^2_{pg}} \tag{9.16}\] と定義できます。 この値のことを級内相関係数(inter-class correlation coefficient [ICC])と呼びます。 ICCがどの程度の大きさであればマルチレベルな分析が必要とされるかには諸説あるようですが,一説には

- ICC < 0.05: マルチレベルモデルの必要性は低い

- 0.05 ≤ ICC < 0.10: マルチレベルモデルを検討する価値がある

- ICC ≥ 0.10: マルチレベルモデルが強く推奨される

などと考えられているようです。

階層性を考慮した分析を行うべき理由は, 図 9.3 に示されていたように,二段階抽出を行うと,見かけのサンプルサイズよりも有効なサンプルサイズが小さいために,標準誤差が過小評価されてしまうことにありました。 これは,二段階抽出が行われると,サンプリングの効率が悪化してしまうことを意味しています。

このサンプリングの効率悪化の程度を示す指標として用いられることがあるのが,デザイン効果 (design effect)と呼ばれる指標です。 デザイン効果は \[ \text{Deff} = \frac{\text{二段階抽出における標準誤差}}{\text{無作為抽出における標準誤差}} \tag{9.17}\] と定義される値で,そのまま二段階抽出によってどれだけ推定の精度が悪化したかを表しています。 そして,このデザイン効果は,(9.16)式で定義されたICCを用いると, \[ \text{Deff} = 1 + (\bar{n_g}-1)\text{ICC} \tag{9.18}\] と表せることが知られています。 すなわち,ICCが大きいほどサンプリングの効率が悪化するのです。

そして一説によれば,Deffの値が2を超えてくると,マルチレベルな分析をしたほうが良いかも,と考えられたりするそうです。

RでICCの計算

ICCを計算するための材料は,すでにglmmTMB()関数によって出力されていました。 表示された値(\(\sigma_{0g}=60.2^2,~ \sigma_{pg}=74.7^2\))を用いて手計算しても良いのですが,よりシステマティックに,そして小数点以下の細かい値まで計算したい場合のために,関数を用いた計算方法も紹介しておきます。

performanceというパッケージには,回帰分析に関する様々な性能チェック(決定係数\(R^2\)やRMSEなどをはじめ,かなりいろいろな種類)の関数が用意されています。 その中にicc()という関数があり,これを使えば簡単に計算可能です。

performanceパッケージでICCの計算

今回のデータでは,ICCはおよそ0.394とかなり大きな値となりました。 したがって,マルチレベルな分析を行う必要性が高いと言えるでしょう。

以下の内容を書いたあとでperformanceパッケージの存在に気づいたのですが,performanceパッケージが使えなくなったときのためにこちら説明も残しておきます。

VarCorr()関数を使うと,推定された結果の中から分散成分のみを取り出すことができます。 あとは,頑張って各成分の数値を取り出せば,ICCが計算可能です。

きちんとperformance::icc()関数と(丸め誤差を除けば)同じ値が得られました。

ICCパッケージによるICCの計算について

ICCを計算するためのパッケージとして,実はICCというものも用意されています。

ICCという統計量自体は,マルチレベルモデル以外の文脈でも用いられるものです。 例えば,複数人が同じ人のパフォーマンスを採点するような場合,ICCが高いということは「採点者間で評価が一致している」とみなすことができます。 そのような用途でICCを計算することを想定しているので,ICCパッケージは,もともとマルチレベルモデルのために作られたものではないはずです。

実際にICCパッケージでは,(集団レベルの変動を固定効果とみなした)分散分析の考え方に基づいて,観測されたある変数の分散を「群間変動」と「群内変動」に分解してICCを求めます。 具体的には,「群間変動の総和(\(SS_B\))」と「群内変動(\(SS_W\))」をそれぞれの自由度で割った値をそれぞれ\(MS_{B},~MS_{W}\)と表したとき, \[

ICC=\frac{MS_B-MS_W}{MS_B + (n_g-1)MS_W}

\tag{9.19}\] という形で計算しています (McGraw & Wong, 1996, 細かい話は無視します)。 ICCest()関数は,ICCの点推定値および95%信頼区間を算出してくれる関数です。

Warning in ICCest(x = school_id, y = read_score, data = dat): 'x' has been

coerced to a factor結果を見ると,glmmTMB()の出力とはやや異なる値が出力されています。 これは,そもそものモデルの考え方が異なるためであり,マルチレベルモデルを実行すべきかを判断する,という意味では,glmmTMB()の出力に基づいて計算するほうが良いと考えられます。

ただし,もちろんICCest()にも使い所は色々とあります。 一つは,ランダム切片モデルにおけるICCのラフな見積もりとして,簡単に信頼区間まで計算してくれる,という点です。 そのため,説明変数のICCを計算する場合にはとりあえずICCest()を使うと良いかもしれません。

ここまでは被説明変数のICCを計算してきました。 というのも,そもそもマルチレベルな分析を行うのは,被説明変数の変動(分散)に関する集団レベル・個人レベルの要因を同時に考慮するためです。 一方でマルチレベルな分析では,個人レベルの変数と集団レベルの変数を同時に使用します。 したがって,例えば回帰分析を行う場合には,被説明変数だけでなく各説明変数についても,集団レベルの変数として扱うべきかを検討すると良いかもしれません。 このような目的の場合には,説明変数に関してもICCを計算してみると良いでしょう。

Warning in ICCest(x = school_id, y = escs, data = dat): 'x' has been

coerced to a factorescs(社会経済的地位)のICCがおよそ0.23であることから,これは学校ごとに平均が異なる変数と言えます。 したがって,説明変数として使用する場合には,集団レベルのESCS(集団の平均値)と個人レベルのESCSをそれぞれ異なる説明変数として使用することができそうです。

belong1)

Warning in ICCest(x = school_id, y = belong1, data = dat): 'x' has been

coerced to a factor所属感のICCはおよそ0.026と非常に低く,学校ごとに平均的に差があるとは言えなさそう(どの学校でも分布は概ね同じ)です。 したがって,この変数を説明変数として使用する場合には,集団レベルの変数として使う意味は薄く,個人レベルの変数として使用するのが良いでしょう。

9.3.3 変量効果として分析するメリット

ランダム切片モデルは,単に分散分析を変量効果に変更しただけのモデルです。 本来各集団の平均値には関心は無いのですが,計算すること自体は可能なので,先ほど紹介したcoef()関数を使って算出した集団平均(\(\beta_{0g}\))と,固定効果の分散分析の結果に基づく各学校の平均値(\(\beta_0 + \beta_{0g}\))を比較してみましょう。

# 固定効果の係数を取得

result_anova <- aov(read_score ~ school_id, data = dat)

intercept <- result_anova$coefficients[1]

# group1の平均はInterceptなので0を頭につける

group_diff <- c(0, result_anova$coefficients[-1])

coef_fixed <- intercept + group_diff

# 変量効果の係数を取得

coef_random <- coef(model0)$cond$school_id$`(Intercept)`

plot(coef_fixed, coef_random,

xlab = "固定効果の学校平均",

ylab = "変量効果の学校平均",

main = "固定効果と変量効果の比較"

)

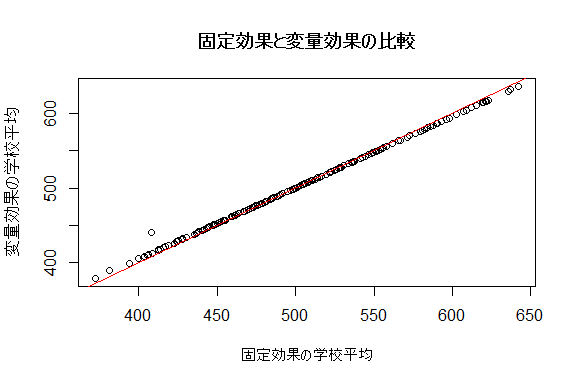

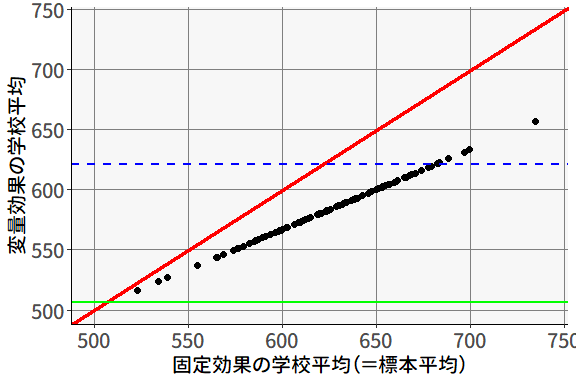

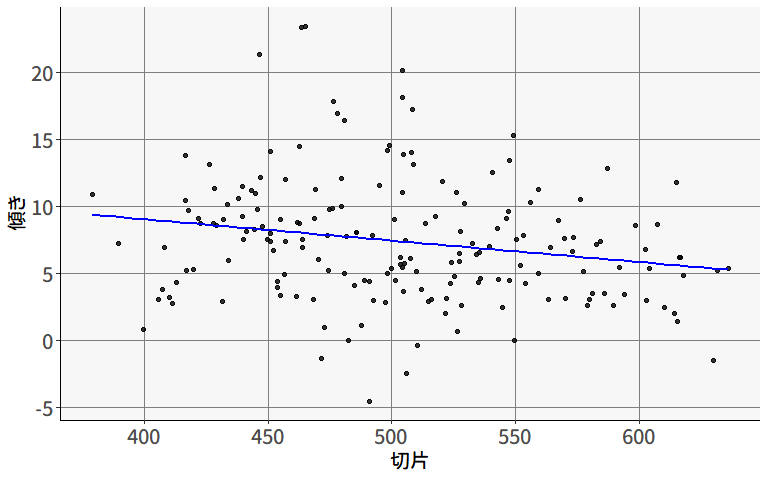

abline(a = 0, b = 1, col = "red") # y=xの直線を追加図 9.11 には,固定効果の分散分析の結果から得られた各学校の平均値と,ランダム切片モデルの結果から得られた各学校の平均値を比較した散布図が描かれています。 基本的にはほぼ同じ値になっているのですが,\(y=x\)の直線と比べると,わずかに傾きが小さくなっていることがわかります。 これは,変量効果の推定で行われている縮退推定(shrinkage estimation)を表したものです。

変量効果に関しては,その分布が何かしらの正規分布に従う(9.10式)と仮定していました。 したがって,変量効果の尤度の部分には,とりあえず全体平均\(\mu\)に近いほうが尤度が大きくなるという性質があります。 そして,ある集団の平均値\(\beta_{0g}=\mu+u_{0g}\)を推定する際,ざっくり言えば「変量効果の背後にある正規分布」と「その集団内のデータの尤度」の掛け算 \[ L(\mathbf{x}_{g}) = \overbrace{\prod_{p=1}^{n_g} f(x_{pg}|\beta_{0g},\sigma^2_{pg})}^{集団内のデータの尤度} \cdot \overbrace{\vphantom{\prod_{p=1}^{n_g}}f(\beta_{0g}|\mu,\sigma^2_{0g})}^{変量効果の尤度} \tag{9.20}\] を最大化するように求めています11。 したがって,変量効果として推定する際には,集団ごとの平均値を単にサンプリングした値として扱うのではなく,全体の平均に近づけるように調整された値が得られます。 そして,これは(9.20)式からわかるように,その集団のサンプルサイズ\(n_g\)が小さいほど,より強く全体平均に近づけられることになります。

この「縮退推定」が,結果的に集団平均の推定を真の値に近づけるのか遠ざけるのかは場合によります。 ただし,縮退推定は特にサンプルサイズが小さい集団がある場合には役に立つ可能性が高くなります。 例えば,ある学校(school_id == "001")では予算か何かの都合により\(n_g=3\)人しかサンプリングできなかったとします。

この場合,その学校の平均値は,たった3人のサンプルから計算されるため,その学校の真の平均値から大きく外れる可能性があります12。

もちろん固定効果の分散分析の場合には,この観測された平均値(734.5123)をそのまま学校の平均値として扱うことになります。

Call:

lm(formula = read_score ~ school_id, data = dat_use)

Residuals:

Min 1Q Median 3Q Max

-323.86 -49.15 0.35 49.89 275.00

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 734.51 43.13 17.028 < 2e-16 ***

school_id002 -261.63 45.00 -5.814 6.42e-09 ***

school_id003 -272.94 45.39 -6.014 1.93e-09 ***

[ reached 'max' / getOption("max.print") -- omitted 180 rows ]

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 74.71 on 5551 degrees of freedom

Multiple R-squared: 0.4085, Adjusted R-squared: 0.3891

F-statistic: 21.07 on 182 and 5551 DF, p-value: < 2.2e-16しかしこのとき,ランダム切片モデルを用いて集団平均を推定すると,どうなるでしょうか。

このように,ランダム切片モデルを用いると,集団平均の推定値は(変量効果として)全体平均に近づいた値になるのです。 イメージとしては,サンプルサイズが小さい集団の平均値が他の集団から著しく離れている場合に,「他の集団の平均値から考えると,そんなに異常な値ということはないだろう」という感じで調整をしていると言えます。

したがって,変量効果を用いることで,集団ごとの平均値の推定がより安定する可能性があるのです。 試しに,

school_id == "001"の学校からランダムに3人をサンプリングする- 他の学校のデータはすべて使用する

- ダミー変数を用いた回帰分析とランダム切片モデルでそれぞれパラメータを推定する

- この操作を100回繰り返して,散布図を描く

というシミュレーションをしてみました。

図 9.12 を見ると,すべての点が赤い直線(\(y=x\))よりも下にあります。 school_id == "001"の学校はもともと優秀な学校なので,どの3人を選んでも全体平均以下になることはないのですが,それでもランダム切片モデルを用いると,その学校の平均値は全体平均(緑の実線あたり)に近づくように調整されていることが分かります。 その結果,ランダム切片モデルでは,\(n_g=3\)の割に,集団平均の推定値のばらつきが小さくなっています。 これが,変量効果として分析する直接的なメリットの一つなのです。

なお,図 9.12 の青い点線は,school_id == "001"の学校の全体平均(母集団平均)を表しています。 つまり本来サンプルサイズが十分に大きければこの値に収束するはずなのですが,縮退推定では,この「本来の平均値」に近づくわけではなく,他の集団も含めた全体の平均値(緑の実線)に近づいていきます。 したがって,school_id == "001"の学校のように,もともと全体平均から離れた集団において,サンプリングが逆方向に偏ってしまった場合には,むしろその集団の本来の平均値から更に離れてしまうこともあり得るという点は注意が必要です。

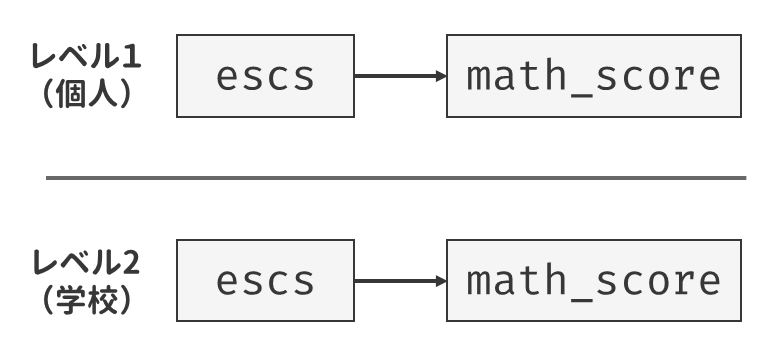

9.3.4 説明変数を含むランダム切片モデル

ランダム切片モデルによってICCがそれなりに大きい値になることが分かったら,次は回帰分析のように説明変数を含むモデルに拡張していきましょう。 ここでは,まず「社会経済的地位(ESCS)が高い生徒ほど読解力が高いのか」を検証する回帰モデルを考えてみます。 まずシンプルに説明変数を追加することを考えると, \[ y_{pg} = \mu + \beta_{\mathrm{ESCS}}\mathrm{ESCS}_{pg} + u_{0g} + u_{pg} \tag{9.21}\] という形になります。 ESCSは個人ごとに異なる値をとる(個人レベルの変数である)ため,上の式をレベルごとに表すならば \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS}}\mathrm{ESCS}_{pg} + u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu + u_{0g} \end{alignedat} \tag{9.22}\] と表記できます。

このモデルは,glmmTMB()関数を使うと以下のように実装可能です。 単純に説明変数を追加するだけであれば,lm()関数のときと同じようにformulaの右辺に変数名を書くだけです。

Family: gaussian ( identity )

Formula: read_score ~ escs + (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66636.0 66662.6 -33314.0 66628.0 5762

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 3313 57.56

Residual 5558 74.56

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.56e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 504.791 4.375 115.38 < 2e-16 ***

escs 9.478 1.564 6.06 1.36e-09 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1出力のConditional model:のところを見ると,escsの推定値が9.478となっています。 したがって,「escsが高い生徒ほど,read_scoreの値も高い」と言えそうです。

lme4パッケージは検定をしてくれない

実は変量効果がある場合には,検定に必要な自由度の正確な定義が難しく,どうやらlme4パッケージの作者の思想として,不正確な可能性があるくらいなら表示しない,というスタンスを取っているようです。 そうは言ってもやはり固定効果の検定の結果が欲しい場面はあるでしょう。 lmer()の結果に対して検定結果(\(p\)値)を出してほしい場合には,lmerTestというパッケージをロードしてからlmer()関数を実行するだけです。

lme4)

Linear mixed model fit by maximum likelihood . t-tests use

Satterthwaite's method [lmerModLmerTest]

Formula: read_score ~ escs + (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66636.0 66662.6 -33314.0 66628.0 5762

Scaled residuals:

Min 1Q Median 3Q Max

-4.3224 -0.6498 0.0124 0.6705 3.6257

Random effects:

Groups Name Variance Std.Dev.

school_id (Intercept) 3313 57.56

Residual 5558 74.56

Number of obs: 5766, groups: school_id, 183

Fixed effects:

Estimate Std. Error df t value Pr(>|t|)

(Intercept) 504.791 4.375 179.861 115.388 < 2e-16 ***

escs 9.478 1.549 5724.542 6.117 1.02e-09 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Correlation of Fixed Effects:

(Intr)

escs 0.040 lmerTestパッケージは,lme4::lmer()関数の出力に対して,近似的に計算された自由度を用いて\(p\)値を表示してくれるようになります。 「じゃあ最初からlmerTestパッケージを使えばいいじゃないか」と思われるかもしれません。 正直それでも良いと思います。 そしてglmmTMB()パッケージはデフォルトで検定結果を出してくれます。 ただし,2つの関数で算出される標準誤差(Std. Error)の値が異なるので,どうやら自由度の定義が異なっているようです。

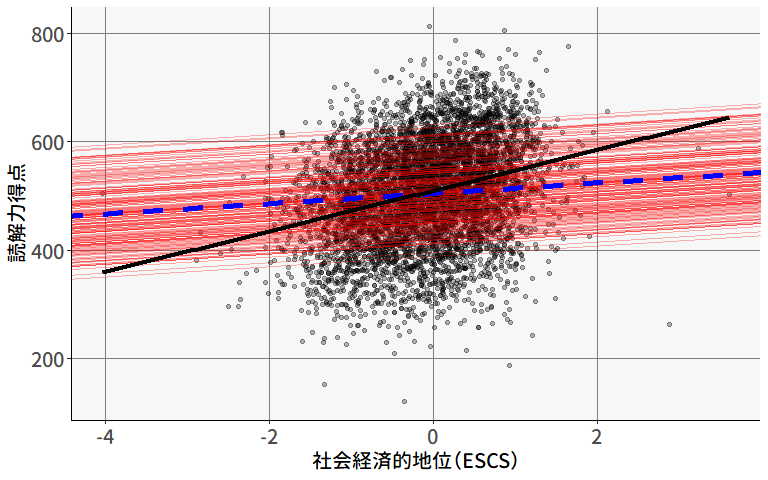

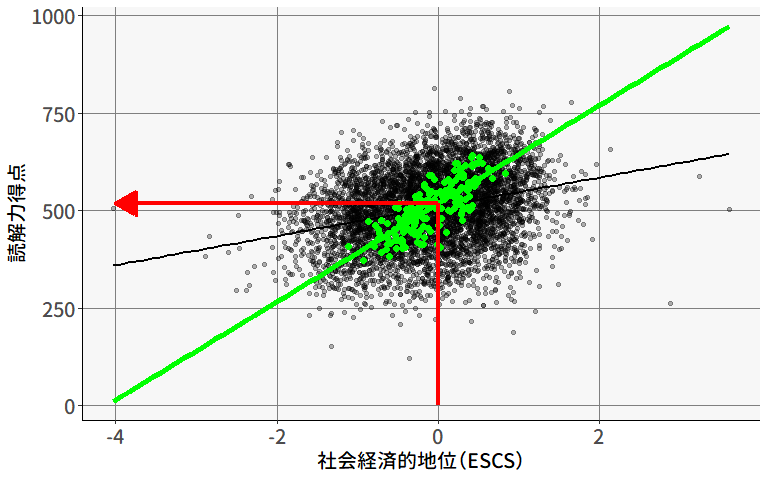

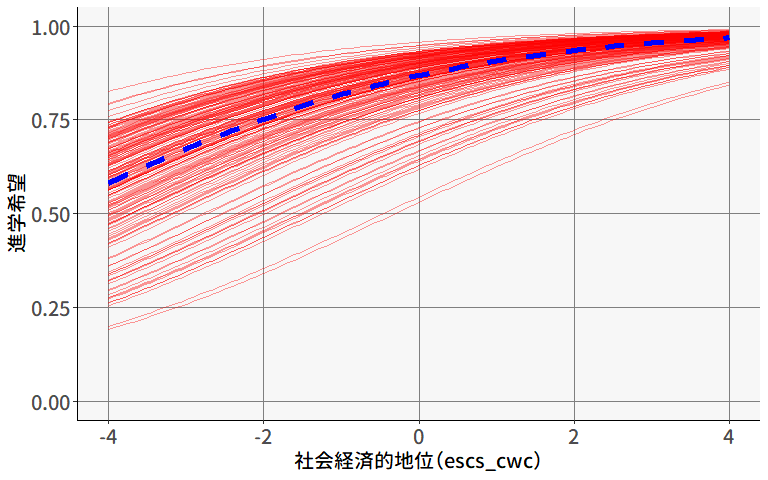

ということで,得られた推定値を(9.22)式に代入すると, \[ \begin{alignedat}{3} \text{(レベル1)} \quad & y_{pg} &&= \beta_{0g} +9.478\mathrm{ESCS}_{pg} + u_{pg}, &\quad& u_{pg} \sim N(0, 74.56^2) \\ \text{(レベル2)} \quad & \beta_{0g} &&= 504.791 + u_{0g}, &\quad& u_{0g} \sim N(0, 57.56^2) \end{alignedat} \tag{9.23}\] となります。 図 9.13 は,このモデルを可視化したものです。 青い点線は切片の全体平均(\(\mu\))に基づいて引いた回帰直線を,また赤い実線は各集団(学校)の\(\beta_{0g}\)の推定値に基づいて引いた回帰直線を表しています。 (9.22)式に示されているように,ランダム切片モデルでは傾き\(\beta_{\mathrm{ESCS}}\)はすべての集団で同じ値となっています。

また,黒い実線は切片の変量効果を含めない通常の回帰分析によって得られる回帰直線です。 ランダム切片モデルにおける回帰直線の傾きと比べると,わずかに傾きが大きいことが分かります。 これは,ランダム切片モデルでは集団レベルの効果が多少は変量効果(\(u_{0g}\))の方に分離されていることを示しています。

改めてこのモデルの回帰係数\(\beta_{\mathrm{ESCS}}\)が意味するところを考えてみると, セクション 9.1.5 で見たように,これは集団レベルの効果と個人レベルの効果が混ざったものになっています(9.2式)。 すなわち,

- \((\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})\)の値が大きい,すなわち集団内で相対的に値が大きい個人ほど\(y_{pg}\)の値も大きい

- \(\overline{\mathrm{ESCS}}_{\cdot g}\)の値が大きい集団ほど\(y_{pg}\)の値も大きい

という2つの効果が混ざった値になっているのです。 このままでは,「ESCSが読解力に与える効果」の解釈は非常にややこしくなってしまいます。 このような場合には,説明変数を個人レベルと集団レベルに分解するのが良いでしょう。

集団レベルの説明変数を含むランダム切片モデル

まずは,集団レベルの説明変数を含むモデルを考えてみます。 これは,先ほど見たように,ESCSの集団平均である\(\overline{\mathrm{ESCS}}_{\cdot g}\)を代わりに使用するだけです。 \[ y_{pg} = \mu +\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g}+ u_{0g} + u_{pg} \tag{9.24}\] この場合,\(\overline{\mathrm{ESCS}}_{\cdot g}\)は集団内では同じ値をとる(集団レベルの変数である)ため,上の式をレベルごとに表すならば \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} + u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu +\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g} \end{alignedat} \tag{9.25}\] と表記されます。

今回のデータには,たまたまescsの集団平均がsch_escs_mean列に入っていたので,これを使いましょう。

Family: gaussian ( identity )

Formula: read_score ~ sch_escs_mean + (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66518.6 66545.3 -33255.3 66510.6 5762

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 1461 38.22

Residual 5579 74.69

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.58e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 518.060 3.131 165.44 <2e-16 ***

sch_escs_mean 126.570 8.153 15.52 <2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1得られた係数を(9.25)式に代入すると, \[ \begin{alignedat}{3} \text{(レベル1)} \quad & y_{pg} && = \beta_{0g} + u_{pg}, &\quad& u_{pg}\sim N(0, 74.69^2) \\ \text{(レベル2)} \quad & \beta_{0g} && = 518.060 +126.570\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g}, &\quad& u_{0g} \sim N(0, 38.22^2) \end{alignedat} \tag{9.26}\] となります。

そんなわけで,マルチレベルモデルを使用する場合には集団レベルの平均値の計算を行うことが多々あります。 わかりやすい方法としては,dplyrパッケージのgroup_by()関数を利用する方法です。

あるいは,Rにデフォルトで入っているave()関数もシンプルに使いやすい関数です。 この関数は,指定した変数の値でグループを作成し,そのグループごとに平均値を計算してくれます。

[1] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[6] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[11] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[16] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[21] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[26] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[31] 0.466865714 0.466865714 0.466865714 0.466865714 0.466865714

[36] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[41] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[46] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[51] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[56] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[61] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.386726471

[66] -0.386726471 -0.386726471 -0.386726471 -0.386726471 -0.003253571

[71] -0.003253571 -0.003253571 -0.003253571 -0.003253571 -0.003253571

[76] -0.003253571 -0.003253571 -0.003253571 -0.003253571 -0.003253571

[81] -0.003253571 -0.003253571 -0.003253571 -0.003253571 -0.003253571

[86] -0.003253571 -0.003253571 -0.003253571 -0.003253571 -0.003253571

[91] -0.003253571 -0.003253571 -0.003253571 -0.003253571 -0.003253571

[96] -0.003253571 -0.003253571 -0.490621212 -0.490621212 -0.490621212

[ reached 'max' / getOption("max.print") -- omitted 5666 entries ]あるいは別の方法として,これもRにデフォルトで入っているaggregate()関数を使うのも一つの手です。

aggregate()

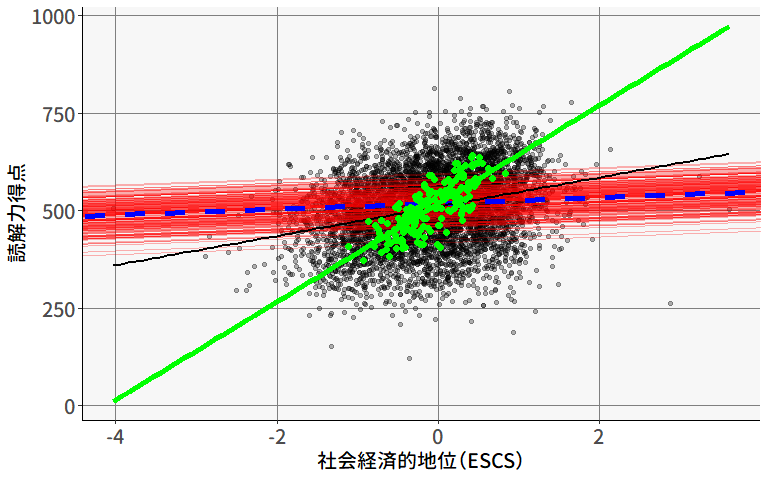

ここで,集団レベルの説明変数を含むランダム切片モデルの特徴を視覚的に確認してみましょう。 図 9.14 には,集団ごとの平均値を緑の点で示し,これに基づいて求めた回帰直線を緑の実線で示しています。 この回帰直線の切片および傾きは,先ほど求めたConditional model:に示された値と一致しています。

この緑の回帰直線は,各集団の切片(\(\beta_{0g}\))の予測値を表しており,例えばESCSの集団平均が0の学校の切片は,おおよそ518.060くらいになるだろう,ということを表します。

また,もとのescsを説明変数に入れた通常の回帰分析における回帰直線が黒い実線で示されています。 これと比べると,明らかに回帰係数が大きくなっていることが分かります13。

いま実行したモデルによって得られる回帰係数\(\beta_{\overline{\mathrm{ESCS}}}\)は,「生徒の平均的なESCSが高い学校ほど,読解力の平均値が高いか」を表しています。 すなわち,この分析は学校間の切片の違いが何によって説明できるのかを明らかにできるわけです。 しかし,このままでは個人レベルの効果,つまり「ESCSが高い生徒ほど…」と言えるかは全くわかりません。

個人レベルの説明変数も加えたランダム切片モデル

(9.2)式で見たように,個人と集団の両レベルの効果を含んだ説明変数\(x_{pg}\)を分解する場合には, \[ x_{pg} = (x_{pg} - \bar{x}_{\cdot g}) + \bar{x}_{\cdot g}, \tag{9.27}\] すなわち集団レベルの変数として平均値\(\bar{x}_{\cdot g}\),そして個人レベルの変数として集団平均を引いた値\(x_{pg}-\bar{x}_{\cdot g}\)に分解する必要があります。 このように,レベル1の変数をモデルに含める際には,集団平均中心化(centering within cluster [CWC])という操作が非常に重要となります。

そして,集団平均中心化した説明変数を加えることで,モデル式は \[ y_{pg} = \mu +\beta_{\mathrm{ESCS}}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g}+ u_{0g} + u_{pg} \tag{9.28}\] となり,レベルごとに表すならば \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS}}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu +\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g} \end{alignedat} \tag{9.29}\] と表記されます。 セクション 9.3.4 の最初のモデル(9.21式)との違いとして,本来単一の説明変数を,中心化を挟むことで2つのレベルの説明変数に分解し,それぞれに異なる回帰係数を推定するというのが重要なポイントです。

集団平均中心化した説明変数を作成するのは,集団平均が先に用意されているならば簡単です。

こうして作成された「集団平均中心化後の説明変数」の値escs_cwcは,「その集団(学校)の中で相対的にESCSがどの程度高い/低いか」を表す値となっています。

それでは,集団平均中心化した変数と集団平均を同時にモデルに含めて分析してみましょう。

Family: gaussian ( identity )

Formula: read_score ~ escs_cwc + sch_escs_mean + (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66498.0 66531.3 -33244.0 66488.0 5761

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 1461 38.23

Residual 5557 74.54

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.56e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 518.060 3.132 165.43 < 2e-16 ***

escs_cwc 7.446 1.563 4.77 1.88e-06 ***

sch_escs_mean 126.569 8.153 15.53 < 2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1集団レベルの効果の推定値(Conditional model:)は先程とほぼ同じ126.569になっています。 この点は変わらないまま,集団平均中心化した説明変数を加えたことで,ESCSのもたらす個人レベル・集団レベルの両方の効果が評価できるようになりました。

得られた係数を(9.29)式に代入すると, \[ \begin{alignedat}{3} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +7.446(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg}, &\quad& u_{pg} \sim N(0, 74.54^2) \\ \text{(レベル2)} \quad & \beta_{0g} & & = 518.060 +126.569\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g}, &\quad& u_{0g} \sim N(0, 38.23^2) \end{alignedat} \tag{9.30}\] となります。

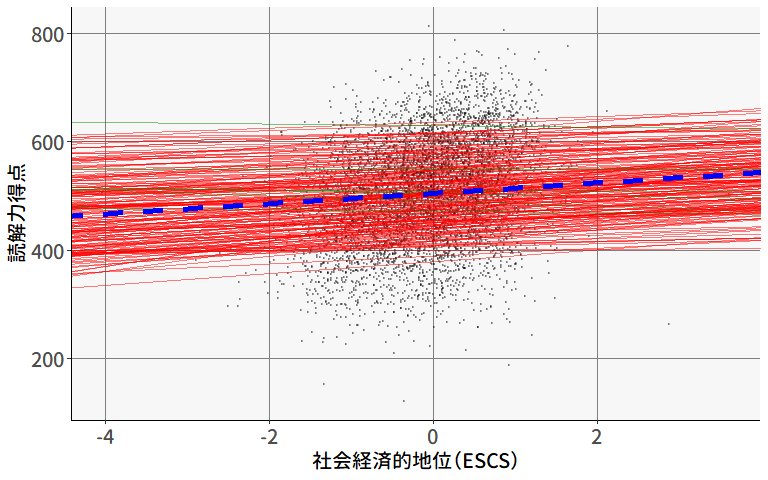

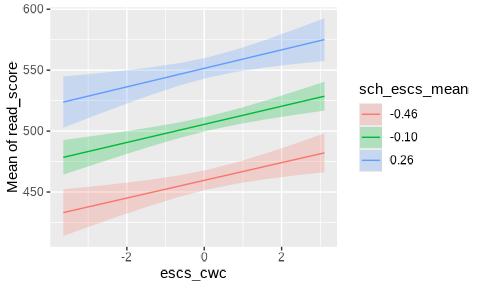

ここまでの分析の集大成となるモデルについて,結果を可視化してみましょう。

図 9.15 には,

- 青い点線: 切片の全体平均(\(\mu\))に基づいて引いた回帰直線

- 赤い線: 各集団(学校)の\(\beta_{0g}\)の推定値に基づいて引いた回帰直線

- 緑の線: 各学校の集団平均(ESCS)と読解力得点の平均値(緑の点)に基づいて引いた回帰直線

- 黒い線: 集団平均中心化した説明変数を含めない通常の回帰分析によって得られる回帰直線

がそれぞれ描かれています。 したがって,青い点線の傾きが「(集団内の)個人レベルの効果の大きさ」を,緑の線の傾きが「集団レベルの効果の大きさ」を,それぞれ表しています。

実質的な意味

2つのレベルに分解した説明変数を加えたランダム切片モデルによって,ESCSが読解力に及ぼす効果の大きさが分かりました。 推定値はそれぞれ,集団レベルの回帰係数が126.568,個人レベルの回帰係数が7.446でした。 この結果をまとめると,以下のようなことが言えます。

- 集団内効果:同じ学校内でも社会経済的地位が高い生徒ほど読解力得点が高い

- 集団間効果:社会経済的地位が高い生徒が多い学校ほど,その学校の生徒全体の読解力得点が高い

- 効果の大きさの比較:多くの場合,集団間効果の方が集団内効果よりも大きくなる傾向がある

特に3点目は,説明変数(escs)を個人レベルと集団レベルに分解したとしてもそのスケールは変わらないことから,これらの係数を直接比較可能と見なして得られる知見です。 とはいえ,本当に個人レベルの効果と集団レベルの効果の大きさを直接比較することに意味があるかはまた別の話です。

いずれにしても,これは教育社会学における重要な知見であり,学校の文脈効果(同じ能力の生徒でも,どの学校に通うかによって成果が変わる)を示したものと言えます。

変動の説明

マルチレベルモデルに限らず,回帰分析では分散説明率が重要な指標となります。 そこで,分散説明率に相当するものとして,これまでに実行してきたモデルについて,ランダム切片やレベル1,2の説明変数を入れたことで,それぞれのレベルの変動のうちどの程度の割合が説明されたか(分散説明率: proportion of variance explained [PVE])を確認してみましょう。

まずは,各モデルの分散成分を取得する関数を定義します。

models <- list(model0, model1, model2, model3)

model_names <- c("model0", "model1", "model2", "model3")

model_var <- c(

"(Intercept)", # model0

"escs", # model1

"mean", # model2

"cwc + mean" # model3

)

# 分散成分の取得

get_variance_components <- function(model) {

vc <- VarCorr(model)$cond # 分散だけ取り出す

school_var <- as.numeric(vc$school_id[1]) # 集団レベルの分散

residual_var <- attr(vc, "sc")^2 # 個人レベル(残差)の分散

return(c(school_var = school_var, residual_var = residual_var))

}そして,これを各モデルに適用して,分散成分を比較してみましょう。

# sapply()関数を使って,先ほど作成したmodelsリストの各要素に適用する

variance_table <- data.frame(

Model = model_names,

var = model_var,

t(sapply(models, get_variance_components))

)

# 変動の減少率を計算

# 集団レベルの総変動

baseline_school_var <- variance_table$school_var[1]

# 個人レベルの総変動

baseline_residual_var <- variance_table$residual_var[1]

# 集団レベルについてどれだけ変動が減少したか

variance_table$PVE_school <-

(baseline_school_var - variance_table$school_var) / baseline_school_var

# 個人レベルについてどれだけ変動が減少したか

variance_table$PVE_residual <-

(baseline_residual_var - variance_table$residual_var) / baseline_residual_var

print(variance_table)個人レベルの回帰係数(\(\beta_{\mathrm{ESCS}}\))があまり大きな値ではなかったことからも示唆されるように,今回のデータにおいてESCSは,個人レベルの変動にはほとんど寄与していない(どのモデルについてもPVE_residualがほぼゼロである)ことが分かります。 一方で,集団レベルのPVEは大きな値(model2, 3ではPVE_schoolが0.6程度)となっており,集団レベルの変動の説明変数として重要な役割を果たしていることが分かります。 このように,分散説明率PVEは,通常の回帰分析と同じように,ある説明変数を(場合によってはどちらのレベルに)投入すべきかを判断するのに役に立つ指標となります。

さらなる集団レベル変数の追加

もちろんモデルは更に拡張可能です。 例えば,レベル2の説明変数を追加することで,集団レベルの変数が平均値に及ぼす影響をさらに考慮することができます。 ここでは,既にデータに含まれているST比(生徒教員比)も集団レベルの変数として追加してみましょう。 これは,少人数学級のほうが生徒の学力が高いのか,という仮説を検証するようなイメージです。

この場合,レベル2の説明変数が追加されるので,モデル式は \[ y_{pg} = \mu +\beta_{\mathrm{ESCS}}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + \beta_{\mathrm{ST}}\mathrm{ST}_{\cdot g}+ u_{0g} + u_{pg} \tag{9.31}\] となり,レベルごとに表すならば \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS}}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu +\beta_{\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + \beta_{\mathrm{ST}}\mathrm{ST}_{\cdot g}+ u_{0g} \end{alignedat} \tag{9.32}\] と表記されます。

Family: gaussian ( identity )

Formula:

read_score ~ escs_cwc + sch_escs_mean + s_t_ratio + (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66494.9 66534.9 -33241.5 66482.9 5760

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 1416 37.63

Residual 5557 74.54

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.56e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 500.0671 8.5274 58.64 < 2e-16 ***

escs_cwc 7.4461 1.5625 4.77 1.88e-06 ***

sch_escs_mean 122.4814 8.2412 14.86 < 2e-16 ***

s_t_ratio 1.4621 0.6458 2.26 0.0236 *

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1得られた係数を(9.33)式に代入すると, \[ \begin{alignedat}{3} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +7.4461(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg}, &\quad& u_{pg} \sim N(0, 74.54^2) \\ \text{(レベル2)} \quad & \beta_{0g} & & = 500.0671 +122.4814\overline{\mathrm{ESCS}}_{\cdot g} + 1.4621\mathrm{ST}_{\cdot g}+ u_{0g}, &\quad& u_{0g} \sim N(0, 37.63^2) \end{alignedat} \tag{9.33}\] となります。

結果を見ると,s_t_ratioの係数は正となっていることから,どうやらむしろST比の高い学校のほうが生徒の読解力がやや高い傾向があるようです。 ただこの結果が少人数教育を否定するものであるかは分かりません。 一応集団レベルにはすでにsch_escs_meanが含まれているため,この効果は統制された偏回帰係数として算出されて入るのですが,ESCSに含まれない別の要因が影響している可能性は否定できないためです。

9.3.5 ランダム切片・傾きモデル

これまでに紹介してきたランダム切片モデルはいずれも,レベル1説明変数(escsあるいはescs_cwc)の回帰係数は集団ごとに同じ値となっていました。 しかし,場合によっては集団ごとに回帰係数が異なることもあります。 例えば,レベル1説明変数として「勉強時間」を考えた場合,「正しい勉強のしかた」を教えてくれる学校では勉強時間の効果が大きい一方で,そうでない学校では勉強時間が学力にあまり結びつかない(回帰係数が小さい)可能性もあるでしょう。 またESCSについても,私立学校ではそもそものESCSのばらつきが小さいために回帰係数が小さい一方で,公立学校ではESCSのばらつきが大きく,回帰係数も大きい可能性が考えられます。

このような場合には,傾きが集団ごとに異なることを許容した拡張であるランダム傾きモデル(random slopes model)を使用します。 なお,ICCの計算で見たように,マルチレベルモデルの基本は集団間の切片の差に起因します。 そのためランダム傾きモデルも,ほとんどの場合にはランダム切片も同時に適用する,ランダム切片モデルの拡張と位置づけられます。

傾きを固定効果とみなすモデル

本題に入る前に,まずは傾きを固定効果とみなすモデルを考えてみましょう。 これは,個人レベルの説明変数をそのままモデルに入れる通常の回帰分析と同じです。 ただし,分散分析のダミー変数と同じように,傾きを集団の数だけ設定する必要があります。 したがって,モデル式としては \[

y_{pg} = \beta_0 + \beta_{\mathrm{ESCS}}\mathrm{ESCS}_{pg}+\overbrace{(\beta_{0g}+ \beta_{\mathrm{ESCS},g}\mathrm{ESCS}_{pg})x_{g=g} + \cdots}^{G-1\text{個だけ足す}} + u_{pg}

\tag{9.34}\] となります。 これだとわかりにくいので,再び集団\(g\)ごとに分解すると, \[

\begin{aligned}

y_{p1} &= \beta_{0} \hspace{-.5em}&+ &\beta_{\mathrm{ESCS}}\mathrm{ESCS}_{p1} \hspace{-.5em}&+ &u_{p1} \hspace{-.5em}& \quad (g=1) \\

y_{p2} &= \beta_{0} + \beta_{02} \hspace{-.5em}&+ &(\beta_{\mathrm{ESCS}}+\beta_{\mathrm{ESCS},2})\mathrm{ESCS}_{p2} \hspace{-.5em}&+ &u_{p2} \hspace{-.5em}& \quad (g=2) \\

y_{p3} &= \beta_{0} + \beta_{03} \hspace{-.5em}&+ &(\beta_{\mathrm{ESCS}}+\beta_{\mathrm{ESCS},3})\mathrm{ESCS}_{p3} \hspace{-.5em}&+ &u_{p3} \hspace{-.5em}& \quad (g=3) \\

& \vdots \\

y_{pG} &= \beta_{0} + \beta_{0G} \hspace{-.5em}&+ &(\beta_{\mathrm{ESCS}}+\beta_{\mathrm{ESCS},G})\mathrm{ESCS}_{pG} \hspace{-.5em}&+ &u_{pG} \hspace{-.5em}& \quad (g=G)

\end{aligned}

\tag{9.35}\] という要領で,(9.5)式と同じように,集団ごとに切片と傾きそれぞれについて「\(g=1\)との違い」の係数を設定することに相当します。 このモデルは,lm()関数を使えば以下のように実行可能です。

(前略)

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 6.170e+02 1.657e+01 37.234 < 2e-16 ***

school_id002 -1.458e+02 2.225e+01 -6.554 6.13e-11 ***

school_id003 -1.552e+02 2.172e+01 -7.149 9.91e-13 ***

school_id004 -1.075e+02 2.266e+01 -4.744 2.15e-06 ***

(中略)

school_id185 -1.484e+02 2.295e+01 -6.468 1.08e-10 ***

escs 9.096e+00 2.317e+01 0.393 0.694693

school_id002:escs -1.346e+01 3.043e+01 -0.442 0.658330

school_id003:escs 4.823e+01 2.779e+01 1.736 0.082693 .

school_id004:escs -1.421e+00 2.890e+01 -0.049 0.960792

(後略)この結果から,例えばschool_idが001,002の学校の回帰直線はそれぞれおよそ \[

\begin{alignedat}{4}

\text{(学校1)} &\quad y_{p1} &&= 617.0 &&+ 9.096\mathrm{ESCS}_{p1} &&+ u_{p1} \\

\text{(学校2)} &\quad y_{p2} &&= (617.0 - 145.8) &&+ (9.096 - 13.46)\mathrm{ESCS}_{p2} &&+ u_{p2} \\

& &&= 471.2 &&- 4.364\mathrm{ESCS}_{p2} &&+ u_{p2}

\end{alignedat}

\tag{9.36}\] という要領で,具体的に各集団ごとの回帰直線を個別に求めることができます。

しかし,このモデルは集団ごとに傾きを設定するため,集団の数だけ回帰係数が必要となり,集団の数が多い場合には非常に多くのパラメータを推定することになります。 また,集団の数が多い場合には,その解釈は非常に大変になってしまうでしょう。 ということで,紹介はしましたが,集団の数が多い場合にはこのモデルはあまり実用的ではありません。

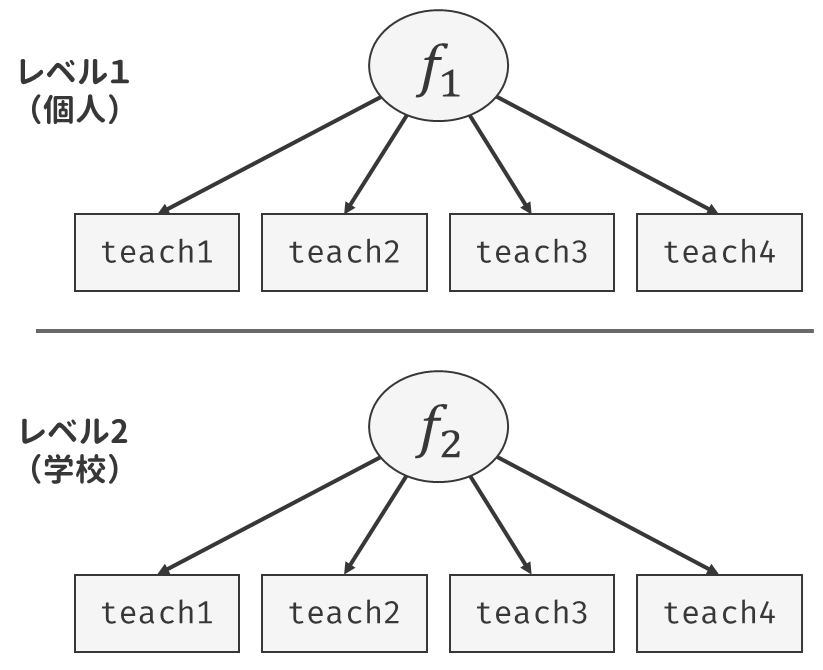

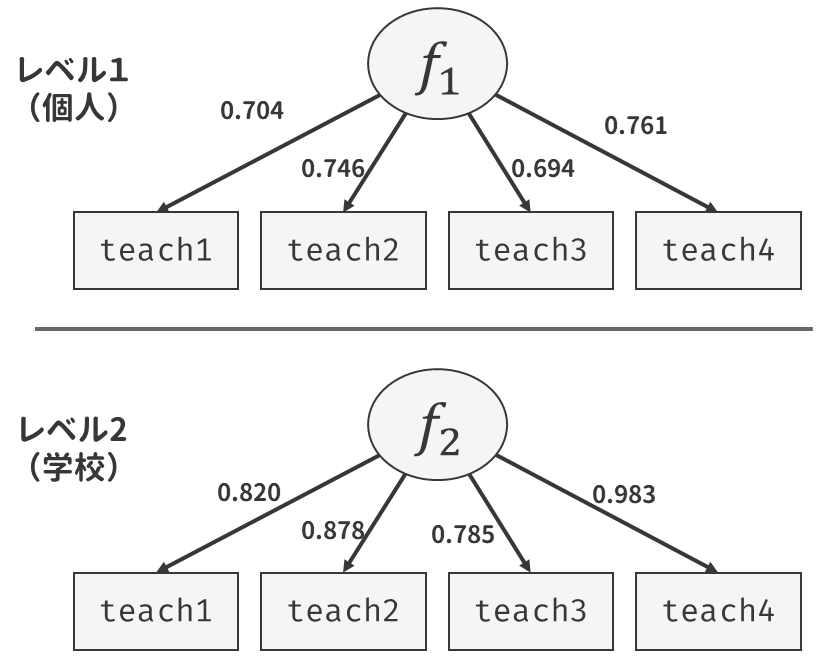

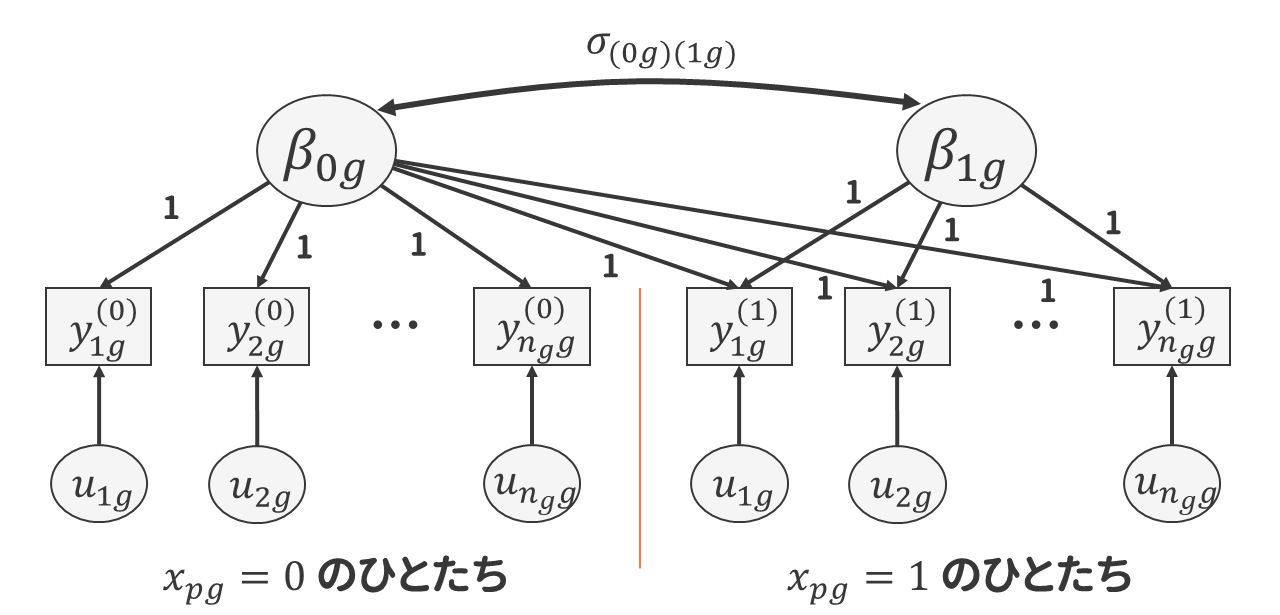

基本的なランダム傾きモデル

ということで,個人レベルの説明変数の傾きを変量効果とみなすランダム傾きモデルを考えてみましょう。 考え方は今までと同じで,集団ごとに異なる傾き\(\beta_{\mathrm{ESCS},g}\)を何かしらの正規分布に従う確率変数と考えるだけです。 \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu_0 + u_{0g}\\ \text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = \mu_{\mathrm{ESCS}} + u_{\mathrm{ESCS},g} \end{alignedat} \tag{9.37}\] 変量効果が複数になる場合には,それぞれの変量効果に対して,レベル2の回帰式が設定されることになります。 これは,後ほど「切片の説明変数」と「傾きの説明変数」がそれぞれ投入されるときに,しっかりと区別するうえで重要な書き方です。

このとき,それぞれの変量効果に対して,以下の仮定を置きます。 \[

\begin{alignedat}{2}

\text{(レベル1)} &u_{pg} &&\sim N(0, \sigma^2_{pg}) \\

\text{(レベル2)} &\left[\begin{array}{c}

u_{0g} \\ u_{\mathrm{ESCS},g}

\end{array}\right] &&\sim MVN\left(

\left[\begin{array}{c}

0 \\ 0

\end{array}\right],

\left[\begin{array}{cc}

\sigma_{0g}^2 & \sigma_{(0g)(\mathrm{ESCS},g)} \\

\sigma_{(0g)(\mathrm{ESCS},g)} & \sigma_{\mathrm{ESCS},g}^2

\end{array}\right]\right)

\end{alignedat}

\tag{9.38}\] これまでと同様に,基本的に各変量効果は正規分布に従い,また異なるレベル間の変量効果は相関しないと仮定します。 ただし,同じレベルの変量効果(今回で言えば\(u_{0g}\)と\(u_{\mathrm{ESCS},g}\))には多変量正規分布\(MVN(\boldsymbol{\mu}, \boldsymbol{\Sigma})\)を仮定します。 簡単に言えば,これは同じレベルの変量効果の間には相関関係を認める,ということです。 その具体的な意味は後ほど確認するとして,まずはglmmTMB()関数でこのモデルを実行してみましょう。

傾きに変量効果を持たせるためには,まず普通にその説明変数をformulaの右辺に入れます。 これによって,「傾きの全体平均(\(\mu_{\mathrm{ESCS}}\))」を推定できるようになります。

Family: gaussian ( identity )

Formula: read_score ~ escs_cwc + (escs_cwc | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66648.6 66688.6 -33318.3 66636.6 5760

Random effects:

Conditional model:

Groups Name Variance Std.Dev. Corr

school_id (Intercept) 3626.8 60.22

escs_cwc 106.9 10.34 -0.09

Residual 5512.9 74.25

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.51e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 503.695 4.563 110.40 < 2e-16 ***

escs_cwc 7.396 1.751 4.22 2.4e-05 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1傾きの変量効果の情報は,出力のRandom effects:の部分に記載されています。 Groupsがschool_idでNameがescs_cwcとなっている行が,傾きの変量効果に関する情報です。 また,一番右にはCorrという列が追加されています。 これは,変量効果の相関係数 \[

\rho_{(0g)(\mathrm{ESCS},g)} = \frac{\sigma_{(0g)(\mathrm{ESCS},g)}}{\sqrt{\sigma_{0g}^2} \sqrt{\sigma_{\mathrm{ESCS},g}^2}}

\tag{9.39}\] を表しています。 したがって,得られた係数を(9.37)式に代入すると, \[

\begin{alignedat}{2}

\text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\

\text{(レベル2)} \quad & \beta_{0g} & & = 503.695 + u_{0g}\\

\text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = 7.396 + u_{\mathrm{ESCS},g}

\end{alignedat}

\tag{9.40}\] また変量効果は \[

\begin{alignedat}{2}

\text{(レベル1)} &u_{pg} &&\sim N(0, 74.25^2) \\

\text{(レベル2)} &\left[\begin{array}{c}

u_{0g} \\ u_{\mathrm{ESCS},g}

\end{array}\right] &&\sim MVN\left(

\left[\begin{array}{c}

0 \\ 0

\end{array}\right],

\left[\begin{array}{cc}

60.22^2 & -56.05 \\

-56.05 & 10.34^2

\end{array}\right]\right)

\end{alignedat}

\tag{9.41}\] となります14。

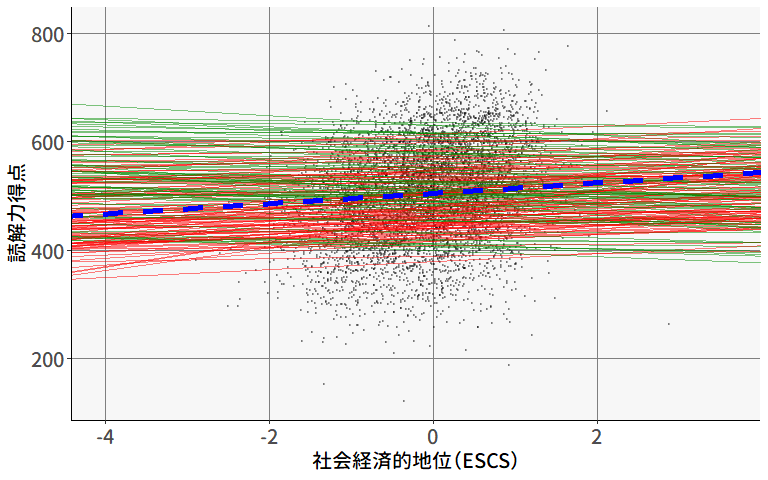

固定効果escs_cwcの値が正であることから,個人レベルの効果は,平均的には正の値を持つことが分かります。 ただし,その変量効果の標準偏差が10.34と大きな値であることから,集団ごとに傾きが大きく異なり,場合によっては負の値になりうることも見えてきます。 実際に,データに含まれている集団(学校)ごとの係数を見てみましょう。

(Intercept) escs_cwc

001 616.3353 6.187427

002 474.2600 5.242309

003 463.3115 23.355328

004 505.6372 7.446572

005 413.0458 4.324954

006 607.0751 8.663129

007 584.1511 7.371261

008 416.7438 10.494779

009 503.3077 6.174089

010 379.0714 10.940293

[ reached 'max' / getOption("max.print") -- omitted 173 rows ]最初の10校には傾きが負になっている学校はありませんでしたが,係数が大きいところでは20を超えている一方で1桁の学校も多く,確かに学校ごとに傾きが大きく異なっていることが分かります。

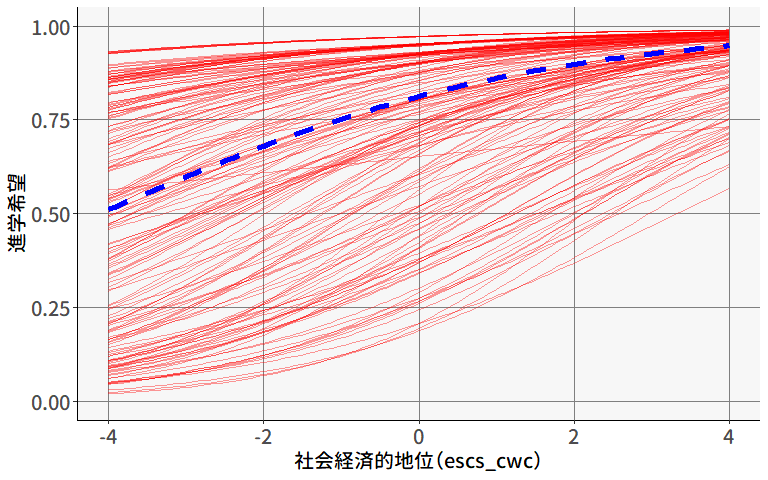

図 9.16 は,集団ごとの傾きの変量効果を視覚化したものです。 read_scoreの値のスケールが大きいのでやや分かりにくいですが,集団ごとに求めた回帰直線は,確かに傾きが微妙に異なっているようです。 試しに,傾きが正の場合は赤,負の場合は緑で色分けしてみると,一部の集団では傾きが負の値になっていることが分かります。

formulaに固定効果を入れ忘れてしまうと

そろそろ分かってきたかもしれませんが,glmmTMB()関数(やlmer()関数)のformulaでは,カッコに入れない説明変数は固定効果(すべての集団で共通の係数)を表し,カッコの中にある説明変数が変量効果を表します。 そのため,傾きの変量効果を推定する場合には,ほとんど全ての場合において,カッコの中と外にそれぞれ同じ説明変数を指定する必要があるのです。

これを忘れてしまうと,モデルとしては以下のようになります。 \[

\begin{alignedat}{2}

\text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\

\text{(レベル2)} \quad & \beta_{0g} & & = \mu + u_{0g}\\

\text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = u_{\mathrm{ESCS},g}

\end{alignedat}

\tag{9.42}\] つまり,各集団の傾き\(\beta_{\mathrm{ESCS},g}\)は,全体平均が0になるように推定されてしまうのです。 もちろん,事前に「傾きの全体平均は0である」という確固たる信念や自負や証拠があるならば,このように設定しても問題ありません。 むしろ推定するパラメータを1つ減らすことができるので良いかもしれません。 しかし,ほとんどの場合ではそのようなことが事前に分かっていることはないでしょう。 ということで,基本的には常にformulaの右辺に説明変数を2回書くことを忘れないようにしましょう。

以下は,実際に固定効果に指定するのを忘れて実行してしまった場合の結果です。

Family: gaussian ( identity )

Formula: read_score ~ (escs_cwc | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66663.7 66697.0 -33326.8 66653.7 5761

Random effects:

Conditional model:

Groups Name Variance Std.Dev. Corr

school_id (Intercept) 3627.8 60.23

escs_cwc 157.6 12.56 -0.12

Residual 5514.4 74.26

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.51e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 504.812 4.774 105.7 <2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1 escs_cwc (Intercept)

001 -0.1697830 616.3282

002 -0.6870569 474.2846

003 23.4385752 463.1085

004 2.6156933 505.6190

005 -1.3208036 413.0862

006 2.9982828 607.0461

007 2.0129289 584.1247

008 6.2975992 416.7272

009 0.5201487 503.3150

010 7.3494200 379.0455

[ reached 'max' / getOption("max.print") -- omitted 173 rows ]実際に回帰直線を引いてみると, 図 9.16 よりも緑の線(負の傾きになる集団)の割合が大きいことが分かります。

ちなみに,切片(1)に関しては,説明変数が1つでもある場合には,特に除外の指定をしない限り自動的に固定効果にも変量効果にも含まれるため,わざわざ書かなくても問題ありません。

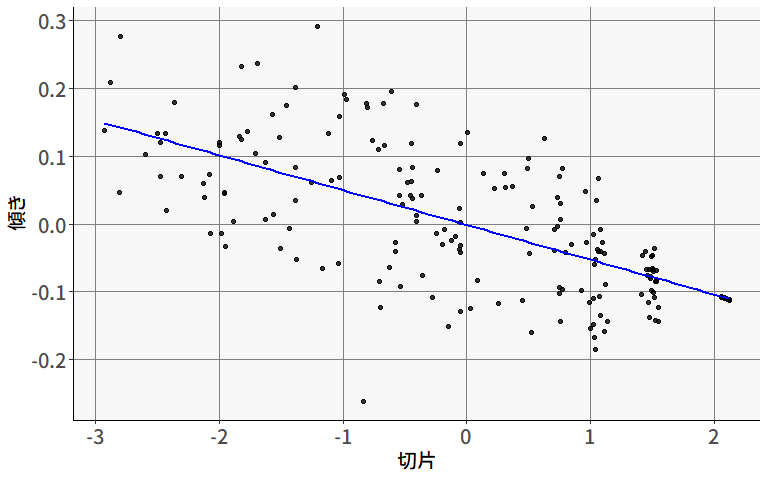

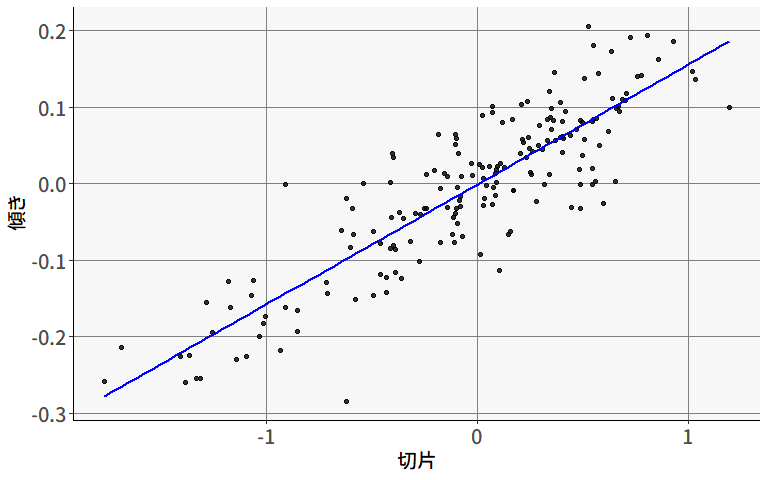

続いて,集団レベルの変量効果間の相関係数が負の値になっていることの意味を確認してみましょう。 一言で言えば,これは切片が大きい集団ほど,escs_cwcがread_scoreに与える正の効果が小さくなっていくことを意味します。 図 9.18 は,切片と傾きの変量効果の散布図です。

このような負の相関が生じるメカニズムまではさすがにこの結果からは分かりませんが,想像すると以下のような現象などが考えられそうです。

- 切片が大きい=学力が高い学校は,もともと入試の時点である程度選抜されているために,生徒のESCSのばらつきが小さく,ESCSの効果が小さくなる。

- 切片が小さい=学力が高くない集団は,入試での選抜が相対的に強くないために,個人レベルのESCSの効果がまだ残っている。

これ以上の議論は領域の専門家に任せるとして,とりあえずはこのような解釈が可能になりそうな分析ができました。

説明変数を含むランダム切片モデル

ランダム切片モデルでは,escs_cwcの傾きが集団(学校)ごとに異なることを確認しました。 そうすると,次は「傾きの差異の原因は何か」を明らかにしたくなるものです。 図 9.18 では,事後的に推定された傾きと切片の散布図に対して回帰直線を引いて,負の関係を示しました。 続いては,この関係をモデル式の中に組み込んでいきましょう。 ということで,切片と傾きの両方に対して,\(\mathrm{ESCS}_{pg}\)の集団平均である\(\overline{\mathrm{ESCS}}_{\cdot g}\)を説明変数として投入します。 \[

\begin{alignedat}{2}

\text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\

\text{(レベル2)} \quad & \beta_{0g} & & = \mu + \beta_{0,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g}\\

\text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = \beta_{\mathrm{ESCS}} +\beta_{1,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{\mathrm{ESCS},g}

\end{alignedat}

\tag{9.43}\]

このモデルには,合計3つの固定効果が含まれています:

- \(\beta_{0,\overline{\mathrm{ESCS}}}\):切片の集団平均に対する効果

- \(\beta_{\mathrm{ESCS}}\):傾きの全体平均

- \(\beta_{1,\overline{\mathrm{ESCS}}}\):傾きの集団平均に対する効果

そして,それぞれの固定効果に対応する説明変数を考えるために,3つの式を1つにまとめてみると, \[ \begin{alignedat}{1} y_{pg} &=\beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ &= (\mu + \beta_{0,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g}) + (\beta_{\mathrm{ESCS}} + \beta_{1,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + u_{\mathrm{ESCS},g})(\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g}) + u_{pg} \\ &= \mu + \beta_{0,\overline{\mathrm{ESCS}}}\underbrace{\overline{\mathrm{ESCS}}_{\cdot g}}_{集団レベル} + \beta_{\mathrm{ESCS}}\underbrace{(\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g})}_{個人レベル} + \beta_{1,\overline{\mathrm{ESCS}}}\underbrace{\overline{\mathrm{ESCS}}_{\cdot g}(\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g})}_{交互作用} \\ &+ \underbrace{u_{0g} + u_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g}) + u_{pg}}_{変量効果} \\ \end{alignedat} \tag{9.44}\] という形になっています。 すなわち,個人レベルの説明変数\((\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g})\)と集団レベルの説明変数\(\overline{\mathrm{ESCS}}_{\cdot g}\),そしてこれらの交互作用項に対して,固定効果の回帰係数が1つずつ推定されることになります。

それでは,このモデルもglmmTMB()関数で実行してみましょう。 変量効果の部分はすでに(escs_cwc|school_id)で指定しているので,説明変数をformulaの右辺に追加するだけで実行できます。 交互作用項を追加する場合には,+の代わりに*を使って繋げましょう。 *を使うと,説明変数の主効果と交互作用項の両方が自動的に追加されます。

Family: gaussian ( identity )

Formula:

read_score ~ escs_cwc * sch_escs_mean + (escs_cwc | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

66498.0 66551.3 -33241.0 66482.0 5758

Random effects:

Conditional model:

Groups Name Variance Std.Dev. Corr

school_id (Intercept) 1463 38.24

escs_cwc 107 10.34 -0.17

Residual 5513 74.25

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.51e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 518.0581 3.1314 165.44 < 2e-16 ***

escs_cwc 7.4769 1.8728 3.99 6.54e-05 ***

sch_escs_mean 126.5833 8.1517 15.53 < 2e-16 ***

escs_cwc:sch_escs_mean 0.4573 4.8602 0.09 0.925

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1得られた推定値を(9.43)式に代入すると, \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = 518.0581 + 126.5833\overline{\mathrm{ESCS}}_{\cdot g} + u_{0g}\\ \text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = 7.4769 +0.4573\overline{\mathrm{ESCS}}_{\cdot g} + u_{\mathrm{ESCS},g} \end{alignedat} \tag{9.45}\] となります(変量効果の部分は省略)。 一番下の式から,このモデルにおいては,ESCSの集団平均(\(\overline{\mathrm{ESCS}}_{\cdot g}\))が大きい集団ほど,個人レベルのESCSの正の効果が大きくなることが示されました。 ただし,係数が小さく,また\(p\)値も大きいことから,基本的には「ESCSの集団平均による違いはほとんどない」と言っても良さそうです。

単純傾斜分析

今回の分析では見られなかったのですが,(クロスレベル)交互作用がある場合には,ある説明変数(\(\mathrm{ESCS}_{pg} - \overline{\mathrm{ESCS}}_{\cdot g}\))回帰係数の傾きが,別の説明変数(\(\overline{\mathrm{ESCS}}_{\cdot g}\))の値によって変わることになります。 これを視覚的に表すために用いられることがあるのが,単純傾斜分析(simple slope analysis)です。 Rで実行する方法はいくつかあると思いますが,ここではmodelbasedパッケージを使って,単純傾斜分析を行う方法を紹介します15。

単純傾斜分析では,傾きを検討したい説明変数(ここではescs_mean)に対する交互作用項(ここではsch_escs_mean)が平均\(\pm1\)標準偏差などの特定の値を取るときに,回帰係数の値について検定を行います。

Estimated Marginal Effects

sch_escs_mean | Slope | SE | 95% CI | z | p

-------------------------------------------------------------

-1.11 | 6.97 | 5.04 | [-2.92, 16.86] | 1.38 | 0.167

-0.89 | 7.07 | 4.05 | [-0.86, 15.00] | 1.75 | 0.081

-0.68 | 7.17 | 3.21 | [ 0.88, 13.45] | 2.23 | 0.025

-0.46 | 7.27 | 2.38 | [ 2.61, 11.92] | 3.06 | 0.002

-0.25 | 7.36 | 1.83 | [ 3.79, 10.94] | 4.03 | < .001

-0.03 | 7.46 | 1.80 | [ 3.93, 10.99] | 4.14 | < .001

0.18 | 7.56 | 2.39 | [ 2.87, 12.25] | 3.16 | 0.002

0.40 | 7.66 | 3.13 | [ 1.52, 13.80] | 2.45 | 0.014

0.61 | 7.76 | 3.96 | [-0.01, 15.53] | 1.96 | 0.050

0.83 | 7.86 | 5.07 | [-2.08, 17.79] | 1.55 | 0.121

Marginal effects estimated for escs_cwc

Type of slope was dY/dXestimate_slopes()関数では,trendに与えた変数(escs_cwc)を説明変数とした回帰直線の傾きが,byに与えた変数(sch_escs_mean)の値によってどう変化するかを表示してくれます。 デフォルトでは,byに与えた変数について,データ内に存在する範囲を10等分した値の場合の傾きをそれぞれ表示しています。 また,以下のように引数byの書き方を変えると,特定の値における結果を表示することも可能です。

Estimated Marginal Effects

sch_escs_mean | Slope | SE | 95% CI | z | p

------------------------------------------------------------

-0.50 | 7.25 | 2.46 | [2.43, 12.07] | 2.95 | 0.003

0.00 | 7.48 | 1.87 | [3.80, 11.15] | 3.99 | < .001

0.50 | 7.71 | 3.54 | [0.77, 14.64] | 2.18 | 0.029

Marginal effects estimated for escs_cwc

Type of slope was dY/dXEstimated Marginal Effects

sch_escs_mean | Slope | SE | 95% CI | z | p

------------------------------------------------------------

-0.46 | 7.27 | 2.37 | [2.61, 11.92] | 3.06 | 0.002

-0.10 | 7.43 | 1.76 | [3.98, 10.88] | 4.22 | < .001

0.26 | 7.60 | 2.75 | [2.22, 12.98] | 2.77 | 0.006

Marginal effects estimated for escs_cwc

Type of slope was dY/dX今回の分析においては,そもそも交互作用が有意でないため,\(\pm1\)標準偏差の間では傾きはほぼ同じになっており,検定もすべて有意となっています。

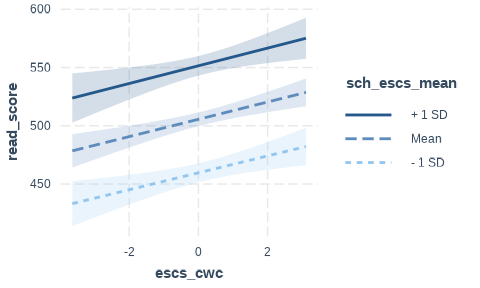

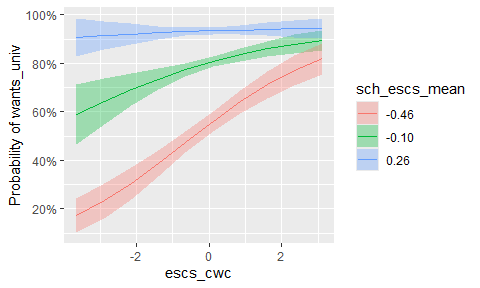

単純傾斜検定においてよく用いられるのが,特定の条件における回帰直線を実際に引いてみる,というものです。 このためには,まず説明変数の値で条件づけた期待値を計算する必要があります。

引数byの中で,最初に指定した変数を\(X\)軸に置き,2つめに指定した変数の値ごとにそれぞれ回帰直線をプロットします。 今回の場合は,傾きのクロスレベル交互作用がほぼ見られなかったため,傾きはほぼ同じで切片だけが異なる直線となりました。

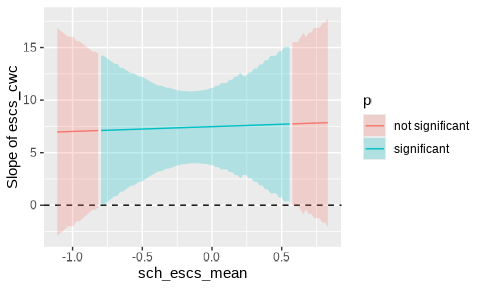

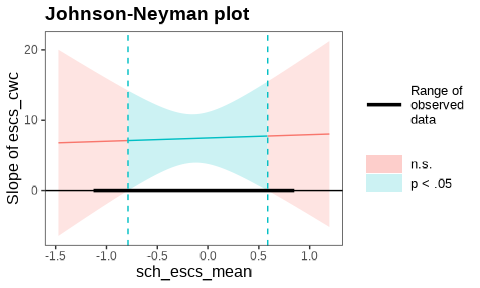

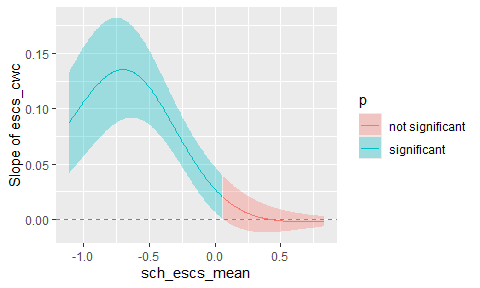

単純傾斜分析の考え方を拡張すると,「sch_escs_meanがある値以下の学校では傾きが有意になり,ある値を超えると有意ではなくなる」などと考えることができます。 これを表すために用いられるのが,Johnson-Neyman区間 (Bauer & Curran, 2005; Johnson & Fay, 1950) と呼ばれるものです。

出力の各行は,byに与えた交互作用の説明変数がStartからEndの間の値であるときに有意(\(p<0.05\))であるかをそれぞれあらわしています。 したがって1行目から順に見ていくと,sch_escs_meanが\([-1.11, -0.82]\)の範囲ではescs_cwcの傾きが有意ではなく,\([-0.80, 0.56]\)の範囲では有意,そして\(0.58\)以上では再び有意ではなくなる,ということです16。 なおこの結果は,estimate_slopes()関数で計算された結果をそのまま使っているだけなので,区間の精度を上げたい場合には,それだけ引数lengthを増やせばOKです。

Johnson-Neyman区間の精度を上げるために,試しにlengthを増やしてみましょう。

Johnson-Neymann Intervals

Start | End | Direction | Confidence

-------------------------------------------

-1.11 | -0.81 | positive | Not Significant

-0.80 | 0.54 | positive | Significant

0.55 | 0.55 | positive | Not Significant

0.56 | 0.56 | positive | Significant

0.57 | 0.58 | positive | Not Significant

0.59 | 0.59 | positive | Significant

0.60 | 0.83 | positive | Not Significant

Marginal effects estimated for escs_cwc

Type of slope was dY/dXすると,\(0.55\)から\(0.60\)の間でNot SignificantとSignificantを行き来しました。 これは,sch_escs_meanの値が大きくなるにつれて,傾きと標準誤差が同時に大きくなるためと考えられます。 つまり,sch_escs_meanの値が\(0.55\)から\(0.60\)の間では\(p\)値がほぼ0.05に近いために起こっています(そんなに頻繁に起こることではないと思います)。

この場合の解釈は悩ましいところですが,基本的にはこのように曖昧なところは,有意ではないものとして解釈しておいたほうが良い気がします。 これは,迷った場合には保守的な態度を取ったほうが安全であり,またJohnson-Neyman区間を単一の区間として表せるためです。

estimate_slopes()関数の出力をplot()にかけると,Johnson-Neyman区間を図示することが可能です。 これは,sch_escs_meanの値が具体的にどの区間にあるときにescs_cwcの傾きが有意になるかを視覚的にわかりやすく示すツールです。

このように,単純傾斜分析やJohnson-Neymanプロットを用いることで,クロスレベルの交互作用がある場合に,どのような状況で傾きが有意になるかを確認することができます。 研究仮説の精緻な検証や,結果の解釈に役立つかもしれません。

lme4とinteractionの組み合わせの場合

ここまでの分析は,lme4::lmer()の出力に対しても同じように実行可能です。 また,interactionパッケージでも以下のように実行可能です。 modelbasedパッケージはまだバージョンが1になっていないので,今後使えなくなる可能性を考慮して,interactionパッケージでの実行方法をいかに示します。 ただし,以下に示す方法の一部はglmmTMB()関数の出力に対しては適用できない点にご注意ください。

単純傾斜分析として,sch_escs_meanの値が特定の状況でのescs_cwcの回帰係数(傾き)を表示するためには,interaction_plot()関数を使用します。

interactions)

interact_plot()関数では,predに与えた変数(escs_cwc)を説明変数とした回帰直線の傾きが,modxに与えた変数(sch_escs_mean)の値によってどう変化するかを表示してくれます。 デフォルトでは,modxの値が平均値\(\pm1\)標準偏差の場合の傾きを表示します。 また,interval = TRUEを指定すると,回帰直線の95%信頼区間も表示されます。

さらに,特定の状況における傾きについて,具体的に検定を行うことも可能です。

JOHNSON-NEYMAN INTERVAL

When sch_escs_mean is INSIDE the interval [-0.79, 0.59], the slope of

escs_cwc is p < .05.

Note: The range of observed values of sch_escs_mean is [-1.11, 0.83]

SIMPLE SLOPES ANALYSIS

Slope of escs_cwc when sch_escs_mean = -0.46161665 (- 1 SD):

Est. S.E. t val. p

------ ------ -------- ------

7.26 2.36 3.08 0.00

Slope of escs_cwc when sch_escs_mean = -0.09878821 (Mean):

Est. S.E. t val. p

------ ------ -------- ------

7.43 1.77 4.21 0.00

Slope of escs_cwc when sch_escs_mean = 0.26404024 (+ 1 SD):

Est. S.E. t val. p

------ ------ -------- ------

7.60 2.64 2.88 0.00sim_slopes()関数は,interact_plot()関数と同じ引数をとり,特定の状況において「傾きが0である」という帰無仮説に対する検定の結果を表示します。 したがって,上の結果からは,sch_escs_meanが平均値あるいは\(\pm1\)標準偏差くらいの範囲にある学校においては,いずれも個人レベルのESCSの効果が有意であることがわかります。

Johnson-Neyman区間のプロットを出すためには,johnson_neyman()関数を使用します。

プロットにおいて,青い線が表示されている範囲が,「sch_escs_meanがその値のときにはescs_cwcの傾きが有意になる」範囲です。 具体的な値は,同時に出力された中に示されており,今回のケースでは[-0.79, 0.59]の範囲であれば有意であると分かります。

さらなる集団レベル変数の追加

もちろんランダム傾きモデルでも,集団レベルのみの説明変数を追加することは可能です。 ランダム切片モデルのときと同様に,ST比を切片および傾きの説明変数に追加した以下のモデルを考えてみましょう。

\[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu + \beta_{0,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + \beta_{0,\mathrm{ST}}\mathrm{ST}_{\cdot g} + u_{0g}\\ \text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = \beta_{\mathrm{ESCS}} +\beta_{1,\overline{\mathrm{ESCS}}}\overline{\mathrm{ESCS}}_{\cdot g} + \beta_{1,\mathrm{ST}}\mathrm{ST}_{\cdot g} + u_{\mathrm{ESCS},g} \end{alignedat} \tag{9.46}\]

このモデルにおいて,集団レベルの説明変数であるST比は,統制変数のような位置づけです。 例えば,ESCSが平均的に高い学校(有名私立など?)では,よりきめ細かい教育を目指してST比が小さくなる傾向があるとしたら,ESCSが読解力に与える影響は,部分的にはST比によるものである可能性があります。 統制変数を追加するということは,このST比の効果を統制することで,集団レベルのESCSそのもののより純粋な効果を推定するために必要かもしれないのです。 このあたりは,マルチレベルモデルであるかに関わらず,回帰分析においては同じように考えておくと良いでしょう。

それでは,このモデルもglmmTMB()関数で実行してみましょう。 先ほどと同様に,クロスレベル交互作用項の位置に気をつけると,\(\overline{\mathrm{ESCS}}_{\cdot g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})\)に加えて,\(\mathrm{ST}_{\cdot g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})\)もあることから,以下のようになります。

Warning in finalizeTMB(TMBStruc, obj, fit, h, data.tmb.old): Model

convergence problem; non-positive-definite Hessian matrix. See

vignette('troubleshooting') Family: gaussian ( identity )

Formula:

read_score ~ escs_cwc * (sch_escs_mean + s_t_ratio) + (escs_cwc |

school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

NA NA NA NA 5756

Random effects:

Conditional model:

Groups Name Variance Std.Dev. Corr

school_id (Intercept) 1.416e+03 3.763e+01

escs_cwc 1.329e-09 3.645e-05 -1.00

Residual 5.555e+03 7.453e+01

Number of obs: 5766, groups: school_id, 183

Dispersion estimate for gaussian family (sigma^2): 5.55e+03

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 500.0676 8.5274 58.64 < 2e-16 ***

escs_cwc 12.8474 4.4287 2.90 0.00372 **

sch_escs_mean 122.4814 8.2412 14.86 < 2e-16 ***

s_t_ratio 1.4621 0.6458 2.26 0.02358 *

escs_cwc:sch_escs_mean 1.5242 4.4683 0.34 0.73302

escs_cwc:s_t_ratio -0.4387 0.3352 -1.31 0.19063

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1交互作用の追加は,掛け算の分配法則のように考えていけばOKです。 すなわち,固定効果をescs_cwc * (sch_escs_mean+s_t_ratio)と書けば,これはescs_cwc * sch_escs_mean + escs_cwc * s_t_ratioと同じ意味になります。 一方で,もしもescs_cwc * sch_escs_mean * s_t_ratioと書いてしまうと,sch_escs_meanとs_t_ratioの間およびこれとescs_cwcの3つの組み合わせにもすべて交互作用があるものとして解釈されてしまいます。

出力を見ると,Warningが出ており,escs_cwcの傾きの変量効果の分散\(\sigma_{\mathrm{ESCS},g}^2\)の値がほぼゼロになっています。 ということで,今回のデータではうまく変量効果を推定することができませんでした17。

不適解であることに目を瞑って,得られた係数を(9.46)式に代入すると, \[ \begin{alignedat}{2} \text{(レベル1)} \quad & y_{pg} & & = \beta_{0g} +\beta_{\mathrm{ESCS},g}(\mathrm{ESCS}_{pg}-\overline{\mathrm{ESCS}}_{\cdot g})+ u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = 500.0676 + 122.4814\overline{\mathrm{ESCS}}_{\cdot g} + 1.4621\mathrm{ST}_{\cdot g} + u_{0g}\\ \text{(レベル2)} \quad & \beta_{\mathrm{ESCS},g} & & = 12.8474 +1.5242\overline{\mathrm{ESCS}}_{\cdot g} -0.4387\mathrm{ST}_{\cdot g} + u_{\mathrm{ESCS},g} \end{alignedat} \tag{9.47}\] となります。

9.3.6 モデル比較

ここまで色々なモデルを実行してきましたが,結局のところどこまでの変量効果を考えるべきか,というのは実用上重要なポイントです。 ランダム切片モデルによって求めたICCでは,まずデータの階層性を考慮する必要があるかを確認しましたが,それ以上のモデルを考える必要があるかどうかは,モデル比較によって判断することができます。

まずは,ここまでに実行してきたモデルのformulaを一覧にしておきましょう。 表 9.2 を見ると,一部のモデルはネストの関係にあることが分かります。 例えば,model0は,model2においてsch_escs_meanの回帰係数を0に固定した(集団レベルの説明変数を削除した)モデル,とみなすことができます。

| model | formulaの右辺 |

|---|---|

| model0 | (1|school_id) |

| model1 | escs + (1|school_id) |

| model2 | sch_escs_mean + (1|school_id) |

| model3 | escs_cwc + sch_escs_mean + (1|school_id) |

| model4 | escs_cwc + sch_escs_mean + s_t_ratio + (1 | school_id) |

| model5 | escs_cwc + (1 + escs_cwc | school_id) |

| model6 | escs_cwc * sch_escs_mean + (1 + escs_cwc | school_id) |

| model7 | escs_cwc * (sch_escs_mean + s_t_ratio) + (1 + escs_cwc | school_id) |

このように,モデルがネストの関係にある場合には,尤度比検定(Likerlihood ratio test [LRT])を用いて,モデルの比較を行うことができます。 尤度比検定自体は チャプター 7 でも少しだけ登場しましたが,これは簡単に言えば増やしたパラメータに見合うだけの尤度の改善が見られるかを評価する方法です18。

ということで,明確にネストの関係にあるmodel0,model2,model3,model6の4つのモデルを比較してみましょう19。 これは非常に簡単に,anova()関数を用いて実行できます20。

Data: dat

Models:

model0: read_score ~ (1 | school_id), zi=~0, disp=~1

model2: read_score ~ sch_escs_mean + (1 | school_id), zi=~0, disp=~1

model3: read_score ~ escs_cwc + sch_escs_mean + (1 | school_id), zi=~0, disp=~1

model6: read_score ~ escs_cwc * sch_escs_mean + (escs_cwc | school_id), zi=~0, disp=~1

Df AIC BIC logLik deviance Chisq Chi Df Pr(>Chisq)

model0 3 66671 66691 -33332 66665

model2 4 66519 66545 -33255 66511 154.0264 1 < 2.2e-16 ***

model3 5 66498 66531 -33244 66488 22.6635 1 1.93e-06 ***

model6 8 66498 66551 -33241 66482 5.9989 3 0.1117

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1このように,anova()関数にネストの関係にあるモデルを順番に指定するだけで,モデル比較ができます。 基本的に,パラメータが増えるほど,(対数)尤度を表すlogLikの値は大きくなります。 そして,anova()関数では,この改善した尤度の大きさと追加したパラメータの数(Dfに等しい)を比較して,その改善が有意かどうかを検定してくれます。 今回のデータでは,model0よりもmodel2が,またmodel2よりもmodel3が,それぞれ有意に尤度を改善している一方で,model6はmodel3と比べて有意な改善が見られなかった,と言えます。 したがって,「傾きの変量効果を追加したこと」あるいは「クロスレベル交互作用を追加したこと」の少なくともいずれか(たぶん後者)は,このデータにおいてはあまり意味がなかったのだと言えそうです。 ただし,この結果はもちろんサンプルサイズが大きいほど有意になりやすいので,注意が必要です。

また,anova()関数では情報量規準(AIC, BIC)も出してくれます。 必要に応じてこれらも参考にすると良いでしょう。 その他にも,説明変数を追加したことによる分散説明率を示すPVEや,「推定された変量効果と相関を持つレベル2説明変数を入れ忘れていないか」を確認するなど,説明変数の選択は多角的に行うことが重要とされています (尾崎 他,2018)。

9.4 一般化線形モデル

ここまで紹介してきた階層線形モデルの考え方は,一般化線形モデル(GLM)に対しても同様に適用可能です21。 そこで,ここからはGLMにおける変量効果の考え方を紹介するため,被説明変数を「進学希望(wants_univ)」としたロジスティック回帰分析をマルチレベルで実行していきます。

9.4.1 ランダム切片GLM

まずは,ランダム切片モデルです。 変量効果を考える前に,まず学校ごとの切片を固定効果とみなした場合のモデル式は以下のようになります。 \[

g(y_{pg}) = \log\frac{y_{pg}}{1-y_{pg}} = \beta_0 + \beta_{02} x_{g=2} + \beta_{03} x_{g=3} + \cdots + \beta_{0G} x_{g=G} + u_{pg}

\tag{9.48}\] このモデルをglm()関数で実行する場合には,以下のように書けば良かったですね。

Call:

glm(formula = wants_univ ~ school_id, family = binomial, data = dat)

Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 1.757e+01 6.687e+02 0.026 0.979

school_id002 -1.817e+01 6.687e+02 -0.027 0.978

school_id003 -1.698e+01 6.687e+02 -0.025 0.980

school_id004 -1.775e+01 6.687e+02 -0.027 0.979

school_id005 -1.776e+01 6.687e+02 -0.027 0.979

school_id006 -1.068e-07 9.599e+02 0.000 1.000

school_id007 -1.479e+01 6.687e+02 -0.022 0.982

[ reached 'max' / getOption("max.print") -- omitted 176 rows ]

(Dispersion parameter for binomial family taken to be 1)

Null deviance: 6572.3 on 5765 degrees of freedom

Residual deviance: 4782.7 on 5583 degrees of freedom

AIC: 5148.7

Number of Fisher Scoring iterations: 16得られた係数から,各学校におけるwants_univの期待値\(\hat{y}_{pg}\)を求める場合には,\(g(y_{pg})\)を\(y_{pg}\)に戻すように変換したら良いので, \[

\begin{alignedat}{2}

\hat{y}_{pg} &= \frac{\exp\left(g(y_{pg})\right)}{1+\exp\left(g(y_{pg})\right)} \\

&= \frac{\exp\left(\beta_0 + \beta_{02} x_{g=2} + \beta_{03} x_{g=3} + \cdots + \beta_{0G} x_{g=G}\right)}{1+\exp\left(\beta_0 + \beta_{02} x_{g=2} + \beta_{03} x_{g=3} + \cdots + \beta_{0G} x_{g=G}\right)}

\end{alignedat}

\tag{9.49}\] となります。 ここに,先ほど推定された値を代入すると,各学校における平均値はそれぞれ \[

\begin{alignedat}{2}

\hat{y}_{p1} &= \frac{\exp(17.57)}{1+\exp(17.57)}&&\approx 1 \\

\hat{y}_{p2} &= \frac{\exp(17.57-18.17)}{1+\exp(17.57-18.17)} &&\approx 0.354 \\

\hat{y}_{p3} &= \frac{\exp(17.57-16.98)}{1+\exp(17.57-16.98)} &&\approx 0.643 \\

\vdots

\end{alignedat}

\tag{9.50}\] などと求めることができます。

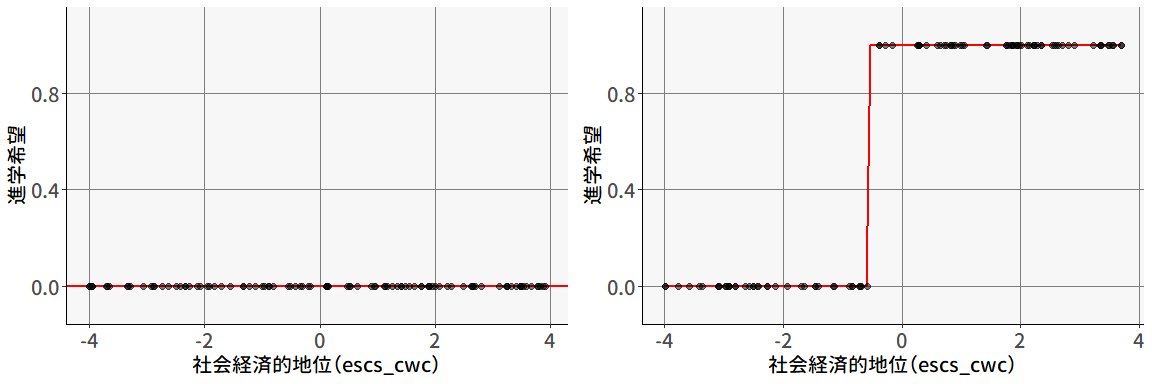

もちろん,このままでは先程と同様に「このデータに含まれる学校の間では進学希望率が異なる」以上のことは言えないので,さっそく変量効果を考えていきましょう。

GLMについて変量効果を考える場合,線形予測子の部分に対して正規分布に従うものがあると考えます。 GLMでは,(9.48)式にあるように,被説明変数のタイプにかかわらず,「被説明変数を何らかの形に変換したもの(\(g(y)\))」が「説明変数と回帰係数の線形和(\(\boldsymbol{X}\boldsymbol{\beta} = \beta_0 + \beta_1x_1 + \beta_2x_2 +\cdots\))」で表されると考えます。 したがって,切片を変量効果としたランダム切片GLMは,以下のように書くことができます。

\[ g(y_{pg}) = \log\frac{y_{pg}}{1-y_{pg}} = \mu + u_{0g} \tag{9.51}\] あるいはレベルごとに分割すると, \[ \begin{alignedat}{2} \text{(レベル1)} \quad & g(y_{pg}) & & = \beta_{0g} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu + u_{0g} \end{alignedat} \tag{9.52}\] という形になります。 通常の線形モデルとの違いとして,ロジスティック回帰(やポアソン回帰)では,レベル1の変量効果(\(u_{pg}\))が存在しません。 ロジスティック回帰の場合,\(y_{pg}\)の確率分布(尤度関数)は \[ y_{pg} \sim \mathrm{Bernoulli}(p_{pg}) \quad \text{with } p_{pg} = \frac{\exp\left(g(y_{pg}\right))}{1+\exp\left(g(y_{pg})\right)} \tag{9.53}\] と,ベルヌーイ分布として表されます。 そして,ベルヌーイ分布の分散は,この\(p_{pg}\)の関数\(p_{pg}(1-p_{pg})\)であることから,レベル1の要素として独立に分散を考えることが出来ないのです22。 これに対して正規分布(通常の階層線形モデル)の場合には,期待値と分散は無関係であることから,「期待値に影響する」レベル2変量効果と,「分散に影響する」レベル1変量効果という形で,異なるレベルの変量効果がそれぞれ規定できるのです。

以上より,変量効果に関する仮定は,以下のように設定されます。 \[ \text{(レベル2)} \quad u_{0g} \sim N(0, \sigma^2_{0g}) \tag{9.54}\] レベル1(個人レベル)の変量効果こそないものの,GLMにおいても変量効果を考える場合には,線形予測子の部分に対して正規分布に従うものがあると考えれば良いのです。 ただし,この場合変量効果の分散\(\sigma^2_{0g}\)は,\(y\)の分散を表したものではない点には注意してください。 この解釈はやや複雑なので,後ほど数値例とともに紹介していくことにします。

ということで,Rで上記のモデルを実行してみましょう。 といっても,使用する関数はglmmTMB()のままでOKです。 この関数はGLMにも対応しています。 ただしglm()関数と同じように,被説明変数が従う確率分布と,必要に応じてリンク関数を指定する必要があります。

Family: binomial ( logit )

Formula: wants_univ ~ (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

5374.7 5388.0 -2685.3 5370.7 5764

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 2.164 1.471

Number of obs: 5766, groups: school_id, 183

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 1.449 0.118 12.28 <2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1lme4パッケージの場合

lm()関数に対してglm()関数が用意されていたように,lme4パッケージではlmer()関数に対してもglmer()という関数が用意されています。

Generalized linear mixed model fit by maximum likelihood (Laplace

Approximation) [glmerMod]

Family: binomial ( logit )

Formula: wants_univ ~ (1 | school_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

5374.7 5388.0 -2685.3 5370.7 5764

Scaled residuals:

Min 1Q Median 3Q Max

-4.4188 -0.5060 0.2857 0.4988 2.0516

Random effects:

Groups Name Variance Std.Dev.

school_id (Intercept) 2.161 1.47

Number of obs: 5766, groups: school_id, 183

Fixed effects:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 1.448 0.117 12.37 <2e-16 ***

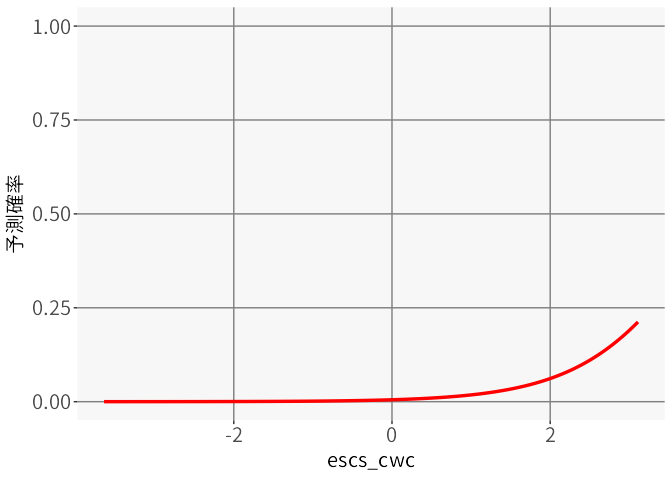

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1得られた推定値を(9.52)式に代入すると, \[ \begin{alignedat}{2} \text{(レベル1)} \quad & g(y_{pg}) & & = \beta_{0g} \\ \text{(レベル2)} \quad & \beta_{0g} & & = 1.449 + u_{0g},\quad u_{0g} \sim N(0, 1.471^2) \end{alignedat} \tag{9.55}\] となります。 \(\mu=1.449\)ということは,ある意味で最も「平均的な」学校における進学希望率は, \[ \hat{y}_{pg} = \frac{\exp(1.449)}{1+\exp(1.449)} \approx 0.810 \tag{9.56}\] となることを意味します。

ロジスティック回帰やポアソン回帰では,期待値に応じて分散が自動的に決定してしまいます。 しかし,この「分散が期待値の関数で表される」という仮定は,実際のデータではかなり強い制約となることがあります。 先ほど実行したモデルでは,進学希望率が学校ごとに異なることを考慮していた一方で,実際にはそれ以外の要因(個人のやる気など)によってもさらなるばらつきが発生する可能性があります。 もちろん,そのような要因は後ほど行うようにモデルの中に説明変数として加えてしまえば良いのですが,もちろんすべての要因を説明変数として加えることはできません。

そこで,「レベル2の変量効果および説明変数では説明できない個人のばらつき」に起因する過分散(ovedispersion)に対応するために,以下のような方法を取ることがあります。

確率分布を変える

同じデータに適用可能な確率分布の中で,パラメータが多いものを用いることで,分散を期待値の関数から切り離す,というのがもっともよく用いられる方法です。 ベルヌーイ分布(二項分布)に対しては,ベータ二項分布という分布がよく用いられます。 これは残念ながらlme4パッケージでは対応できないのですが,以下のようにglmmTMBパッケージ(やbrmsパッケージ)を用いることで,ベータ二項分布を用いたマルチレベルモデルを実行することができます。

同様に,ポアソン分布に対しては負の二項分布(negative binomial distribution)を用いることができます。

ちなみに負の二項回帰は,lme4パッケージにあるglmer.nb()という関数でも実行可能です。

レベル1の変量効果をあえて追加する

言うまでもなく,レベル1の固定効果を加えてしまうと,それだけでサンプルサイズと同数のパラメータが追加されてしまうので,これは不可能です。 一方で変量効果の場合,モデル上は個人ごとのばらつきの具体的な値ではなく,その分散だけを推定するため,観測レベル変量効果 (Observation-level random effects [OLRE]: Harrison, 2014) を指定することも可能なようです。

この場合,レベル1変量効果が追加されることからモデル式は(9.8)式とほぼ同じ形の \[ \begin{alignedat}{2} \text{(レベル1)} \quad & g(y_{pg}) & & = \beta_{0g} + u_{pg} \\ \text{(レベル2)} \quad & \beta_{0g} & & = \mu + u_{0g} \end{alignedat} \tag{9.57}\] となります。 このとき,\(u_{pg}\)の分散\(\sigma_{pg}^2\)を追加で推定するために,過分散に対応できるようになるようです。

OLREは,glmmTMB()での実装も非常に簡単です。 変量効果に関する記述を(1|school_id) + (1|student_id)とすることで,個人レベルの変量効果も考慮することができます。

Family: binomial ( logit )

Formula: wants_univ ~ (1 | school_id) + (1 | student_id)

Data: dat

AIC BIC logLik -2*log(L) df.resid

5376.7 5396.7 -2685.3 5370.7 5763

Random effects:

Conditional model:

Groups Name Variance Std.Dev.

school_id (Intercept) 2.164e+00 1.4710382

student_id (Intercept) 2.261e-08 0.0001504

Number of obs: 5766, groups: school_id, 183; student_id, 5766

Conditional model:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 1.449 0.118 12.28 <2e-16 ***

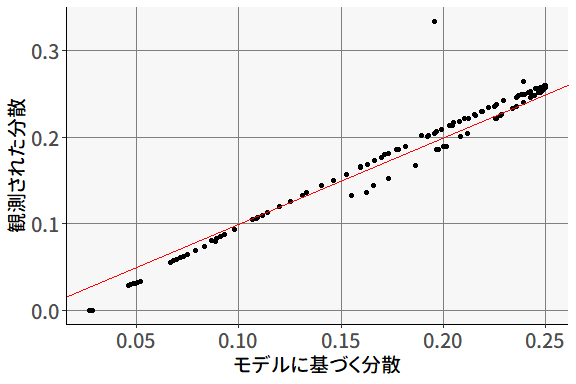

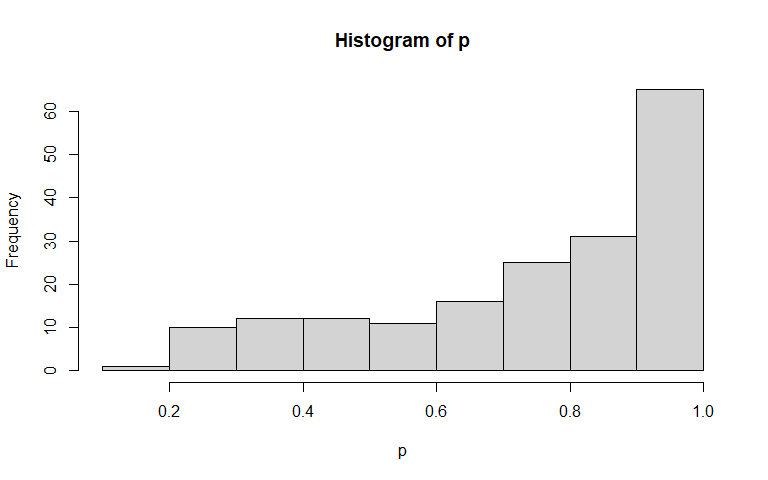

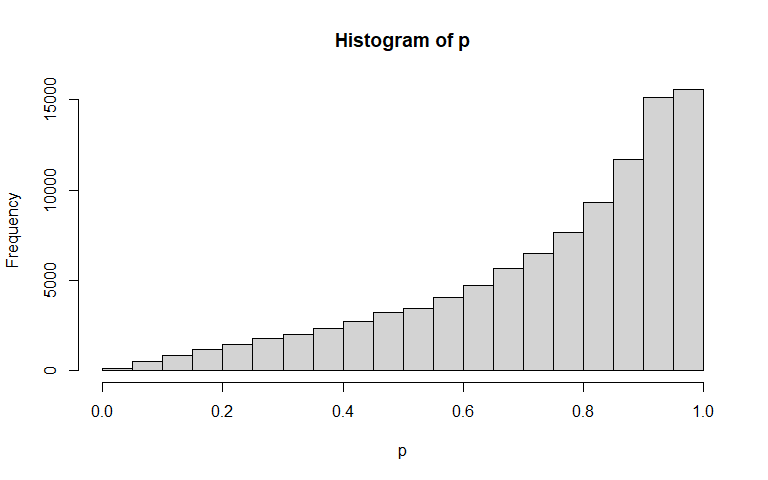

---