本章の構成

今回からは構造方程式モデリング (Structural Equation Modeling; SEM)の話です。 はじめにSEMの基本的な考え方を紹介し,Rで実際に実行してみます。

RでのSEMはlavaanというパッケージを用いるのが最もメジャーです。 事前にインストール&読み込みをしておきましょう。 合わせて,このチャプターで使用するいくつかのパッケージもインストールしておきます。

↓本Chapterで使用するファイルのダウンロードはこちらから

7.1 因子分析の見方を変える

7.1.1 1因子モデル

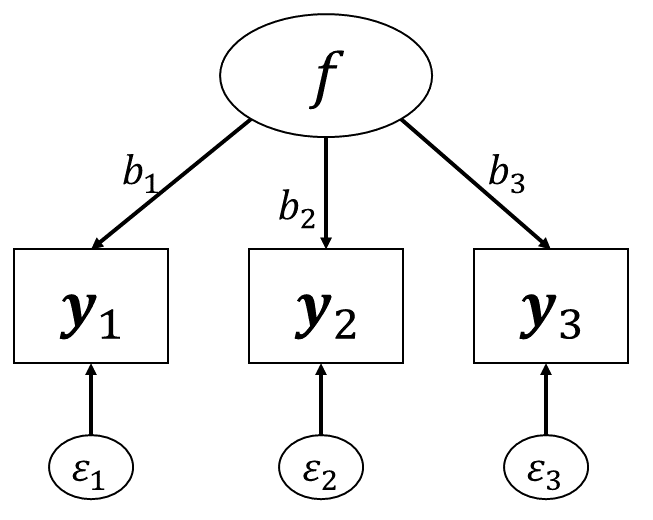

まずは 図 7.1 のような1因子3項目の因子分析モデルを考えてみます。 このモデルでは,各観測変数はそれぞれ \[

\left\{

\begin{aligned}

\symbf{y}_1 &= \symbf{f}b_{1} + \symbf{\varepsilon}_1 \\

\symbf{y}_2 &= \symbf{f}b_{2} + \symbf{\varepsilon}_2 \\

\symbf{y}_3 &= \symbf{f}b_{3} + \symbf{\varepsilon}_3

\end{aligned}

\right.

\tag{7.1}\] と表されました。したがって,3つの観測変数のモデル上の共分散行列\(\symbf{\Sigma}\)は \[

\symbf{\Sigma} = \begin{bmatrix}

b_1^2+\sigma_{\symbf{\varepsilon}_1}^2 & b_1b_2 & b_1b_3\\

b_2b_1 & b_2^2+\sigma_{\symbf{\varepsilon}_2}^2 & b_2b_3\\

b_3b_1 & b_3b_2 & b_3^2+\sigma_{\symbf{\varepsilon}_3}^2

\end{bmatrix}

\tag{7.2}\] となります。 また,3つの観測変数のデータでの共分散行列も \[

\symbf{S} = \begin{bmatrix}

\sigma_{y_1}^2 & \sigma_{y_1,y_2} & \sigma_{y_1,y_3} \\

\sigma_{y_2,y_1} & \sigma_{y_2}^2 & \sigma_{y_2,y_3} \\

\sigma_{y_3,y_1} & \sigma_{y_3,y_2} & \sigma_{y_3}^2

\end{bmatrix}

\tag{7.3}\] と表すことができ,これは実際にデータから計算が可能です。 例えばQ1_1からQ1_3の3項目のみを考えればcov(dat[,paste0("Q1_",1:3)])によって1具体的に \[

\symbf{S} = \begin{bmatrix}

1.976 & 0.581 & 0.504 \\

0.581 & 1.375 & 0.762 \\

0.504 & 0.762 & 1.706

\end{bmatrix}

\] という値が得られます。 構造方程式モデリングでは,\(\symbf{\Sigma}\)の値が\(\symbf{S}\)にできるだけ近づくように母数(パラメータ)を推定します。 実際に(7.2)式の\(\symbf{\Sigma}\)と(7.3)式の\(\symbf{S}\)の同じ項をイコールで結ぶと, \[

\left\{

\begin{aligned}

\sigma_{y_1}^2 &= b_1^2+\sigma_{\symbf{\varepsilon}_1}^2 \\

\sigma_{y_2}^2 &= b_2^2+\sigma_{\symbf{\varepsilon}_2}^2 \\

\sigma_{y_3}^2 &= b_3^2+\sigma_{\symbf{\varepsilon}_3}^2 \\

\sigma_{y_1,y_2} &= b_1b_2\\

\sigma_{y_1,y_3} &= b_1b_3\\

\sigma_{y_2,y_3} &= b_2b_3\\

\end{aligned}

\right.

\tag{7.4}\] という連立方程式を得ることが出来ます。このモデルで推定するべきパラメータは\((b_1,b_2,b_3,\sigma_{\symbf{\varepsilon}_1}^2,\sigma_{\symbf{\varepsilon}_2}^2,\sigma_{\symbf{\varepsilon}_3}^2)\)の6つです。 そして式も6つあるため,このケースでは明確な解を求めることが出来ます。 例えばQ1_1からQ1_3の3項目であれば \[

\left\{

\begin{aligned}

1.976 &= b_1^2+\sigma_{\symbf{\varepsilon}_1}^2 \\

1.375 &= b_2^2+\sigma_{\symbf{\varepsilon}_2}^2 \\

1.706 &= b_3^2+\sigma_{\symbf{\varepsilon}_3}^2 \\

0.581 &= b_1b_2\\

0.504 &= b_1b_3\\

0.762 &= b_2b_3\\

\end{aligned}

\right.

\] となり,これを解くと \[

\left\{

\begin{aligned}

b_1 &= 0.620 \\

b_2 &= 0.937 \\

b_3 &= 0.813 \\

\sigma_{\symbf{\varepsilon}_1}^2 &= 1.591 \\

\sigma_{\symbf{\varepsilon}_2}^2 &= 0.497 \\

\sigma_{\symbf{\varepsilon}_3}^2 &= 1.045

\end{aligned}

\right.

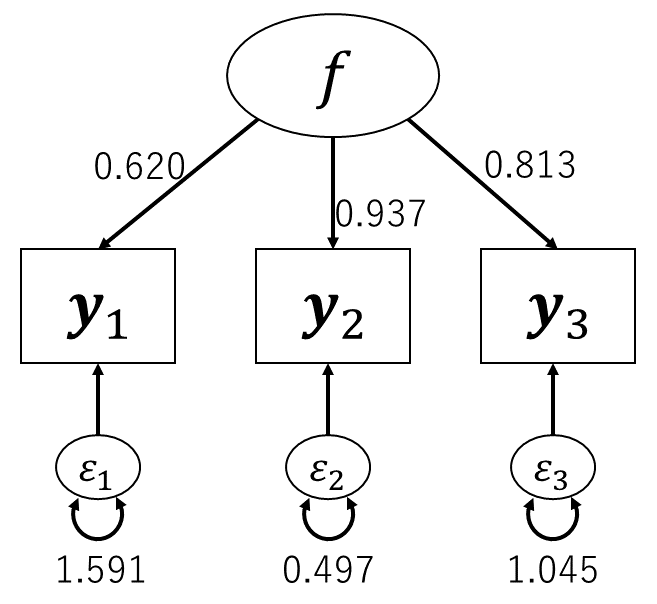

\tag{7.5}\] という解が得られます。 図 7.1 に書き加えたならば 図 7.2 のようになります。

もちろん(7.5)式の値を(7.2)式に代入すれば, \[ \begin{aligned} \symbf{\Sigma} &= \begin{bmatrix} b_1^2+\sigma_{\symbf{\varepsilon}_1}^2 & b_1b_2 & b_1b_3\\ b_2b_1 & b_2^2+\sigma_{\symbf{\varepsilon}_2}^2 & b_2b_3\\ b_3b_1 & b_3b_2 & b_3^2+\sigma_{\symbf{\varepsilon}_3}^2 \end{bmatrix} \\ &= \begin{bmatrix} 0.620^2+1.591 & 0.620\times0.937 & 0.620\times0.813\\ 0.937\times0.620 & 0.937^2+0.497 & 0.937\times0.813\\ 0.813\times0.620 & 0.813\times0.937 & 0.813^2+1.045 \end{bmatrix}\\ &\approx\begin{bmatrix} 1.976 & 0.581 & 0.504 \\ 0.581 & 1.375 & 0.762 \\ 0.504 & 0.762 & 1.706 \end{bmatrix} \\ &= \symbf{S} \end{aligned} \tag{7.6}\] というように,\(\symbf{\Sigma}\)は\(\symbf{S}\)と(丸め誤差を除けば)完全に一致することが確認できます。

グラフィカルモデルでは,観測変数を四角形で,潜在変数を楕円で表していました。 図 7.2 とパラメータの関係を見てみると,2つの観測変数の共分散は,2つの四角形を結ぶ矢印にかかる係数の積になっていることがわかります。 つまり,グラフィカルモデル上で経路が存在する観測変数間には非ゼロの共分散があることを仮定していたわけです。 また,1つの観測変数の分散は,その四角形に向かっている矢印の係数の二乗和になっています。 なお,独自因子には自分自身に対する両方向の矢印が引かれています。 グラフィカルモデルでは両方向の矢印で共分散を表すので,これは自分自身との共分散=分散を表していることになります。

先程の結果は観測変数を標準化していない状態での解でした。 そのため,独自因子の分散が1を超えたり,因子負荷の二乗との合計が1にならなかったりしています。 例えば項目\(\symbf{y}_1\)について見てみると,因子負荷の二乗と独自因子の分散の和は\(0.620^2+1.591\approx1.976\)となります。これは,\(\symbf{y}_1\)の分散\(\sigma_{y_1}^2\)の値1.976に対応しているわけです。 ここで前回までの因子分析と同じように全ての観測変数を標準化した状態,つまり\(\symbf{S}\)に共分散行列ではなく相関行列を与えて推定をした場合に得られる解のことを標準化解や標準化推定値などと呼びます。 そしてSEMでは多くの場合,結果には標準化解を載せています。 絶対のルールでは無いのですが,特に潜在変数がある場合には単位の影響を受けない標準化解を用いたほうがしっくり来る,ということなのでしょう。 ということでこの先も,潜在変数が含まれるモデルを扱う場合には\(\symbf{S}\)には相関行列を想定した,標準化解を考えることにします。

実際に先程の例で標準化解を計算してみると,データにおける相関行列\(\symbf{S}\)はcor(dat[,paste0("Q1_",1:3)])によって具体的に2 \[

\symbf{S} = \begin{bmatrix}

1 & 0.353 & 0.274 \\

0.353 & 1 & 0.497 \\

0.274 & 0.497 & 1

\end{bmatrix}

\] という値が得られるため,連立方程式は \[

\left\{

\begin{aligned}

1 &= b_1^2+\sigma_{\symbf{\varepsilon}_1}^2 \\

1 &= b_2^2+\sigma_{\symbf{\varepsilon}_2}^2 \\

1 &= b_3^2+\sigma_{\symbf{\varepsilon}_3}^2 \\

0.353 &= b_1b_2\\

0.274 &= b_1b_3\\

0.497 &= b_2b_3\\

\end{aligned}

\right.

\] となり,これを解くと \[

\left\{

\begin{aligned}

b_1 &= 0.441 \\

b_2 &= 0.800 \\

b_3 &= 0.622 \\

\sigma_{\symbf{\varepsilon}_1}^2 &= 0.805 \\

\sigma_{\symbf{\varepsilon}_2}^2 &= 0.361 \\

\sigma_{\symbf{\varepsilon}_3}^2 &= 0.613

\end{aligned}

\right.

\] という標準化解を得ることができます。

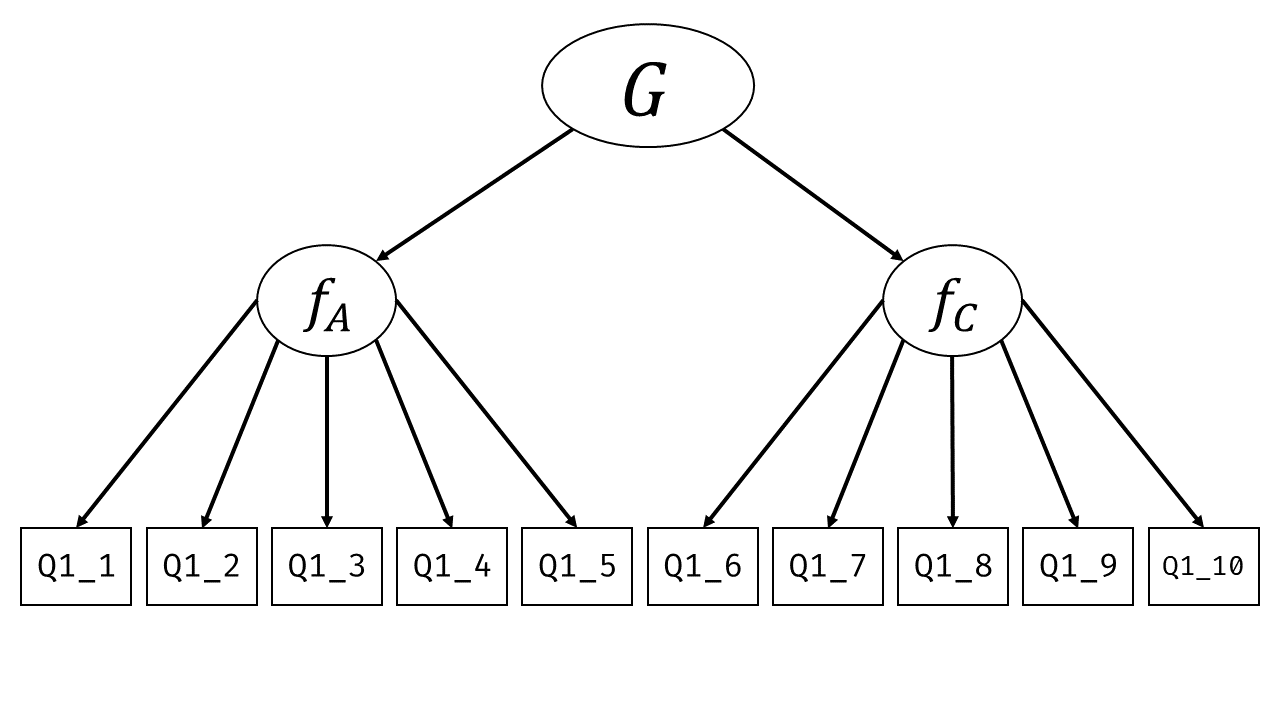

7.1.2 2因子モデル

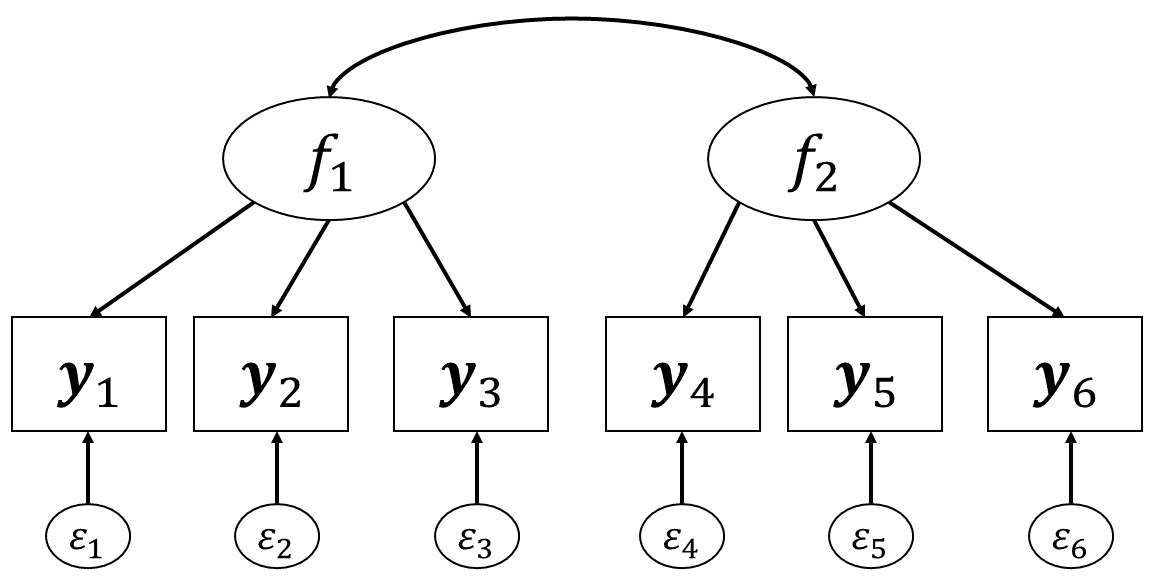

続いて 図 7.3 のような2因子6項目の因子分析モデルで同じように見てみましょう。 ここでは,因子1は最初の3項目にのみ,因子2は後ろの3項目にのみ影響を与えているという仮定を置いています。 また,2つの因子の間は両矢印でつながっています。これは因子間に相関関係\(r_{f1,f2}\)があることを表しています。 このように,(共)分散を表す時には両矢印を使います。 言い換えると,ここでは因子間の共分散(=相関)が0でなくても良いという仮定(斜交回転)を置いているのです。

このモデルでは,因子負荷行列\(\symbf{B}^\top\)は \[ \begin{aligned} \symbf{B}^\top = \begin{bmatrix} b_{11} & 0\\ b_{21} & 0\\ b_{31} & 0\\ 0 & b_{42} \\ 0 & b_{52}\\ 0 & b_{62} \end{bmatrix} \end{aligned} \tag{7.7}\] となります。 ちなみにSEMで多因子モデルを扱う場合の多くは,このように1項目が1因子からのみ影響を受けていると考えると思います3。

すると,6つの観測変数のモデル上の相関行列\(\symbf{\Sigma}\)は \[ \begin{aligned} \begin{split} \symbf{\Sigma} &= \symbf{B}^\top\symbf{\Phi} \symbf{B} + \symbf{\Psi} \\ &= \begin{bmatrix} b_{11} & 0\\ b_{21} & 0\\ b_{31} & 0\\ 0 & b_{42}\\ 0 & b_{52}\\ 0 & b_{62} \end{bmatrix}\begin{bmatrix} 1 & r_{f1,f2} \\ r_{f1,f2} & 1 \end{bmatrix}\begin{bmatrix} b_{11} & b_{21} & b_{31} & 0 & 0 & 0\\ 0 & 0 & 0 & b_{42} & b_{52} & b_{62} \\ \end{bmatrix} + \symbf{\Psi} \\ &= \begin{bmatrix} b_{11}^2 & b_{11}b_{21} & b_{11}b_{31} & r_{f1,f2}b_{11}b_{42} & r_{f1,f2}b_{11}b_{52} & r_{f1,f2}b_{11}b_{62} \\ b_{21}b_{11} & b_{21}^2 & b_{21}b_{31} & r_{f1,f2}b_{21}b_{42} & r_{f1,f2}b_{21}b_{52} & r_{f1,f2}b_{21}b_{62} \\ b_{31}b_{11} & b_{31}b_{21} & b_{31}^2 & r_{f1,f2}b_{31}b_{42} & r_{f1,f2}b_{31}b_{52} & r_{f1,f2}b_{31}b_{62} \\ r_{f1,f2}b_{42}b_{11} & r_{f1,f2}b_{42}b_{21} & r_{f1,f2}b_{42}b_{31} & b_{42}^2 & b_{42}b_{52} & b_{42}b_{62} \\ r_{f1,f2}b_{52}b_{11} & r_{f1,f2}b_{52}b_{21} & r_{f1,f2}b_{52}b_{31} & b_{52}b_{42} & b_{52}^2 & b_{52}b_{62} \\ r_{f1,f2}b_{62}b_{11} & r_{f1,f2}b_{62}b_{21} & r_{f1,f2}b_{62}b_{31} & b_{62}b_{42} & b_{62}b_{52} & b_{62}^2 \end{bmatrix} \\&~~~+ \begin{bmatrix} \sigma_{\symbf{\varepsilon}_1}^2 & 0 & 0 & 0 & 0 & 0 \\ 0 & \sigma_{\symbf{\varepsilon}_2}^2 & 0 & 0 & 0 & 0 \\ 0 & 0 & \sigma_{\symbf{\varepsilon}_3}^2 & 0 & 0 & 0 \\ 0 & 0 & 0 & \sigma_{\symbf{\varepsilon}_4}^2 & 0 & 0 \\ 0 & 0 & 0 & 0 & \sigma_{\symbf{\varepsilon}_5}^2 & 0 \\ 0 & 0 & 0 & 0 & 0 & \sigma_{\symbf{\varepsilon}_6}^2 \end{bmatrix} \\ &=\begin{bmatrix} b_{11}^2 + \sigma_{\symbf{\varepsilon}_1}^2 & b_{11}b_{21} & b_{11}b_{31} & r_{f1,f2}b_{11}b_{42} & r_{f1,f2}b_{11}b_{52} & r_{f1,f2}b_{11}b_{62} \\ b_{21}b_{11} & b_{21}^2 + \sigma_{\symbf{\varepsilon}_2}^2 & b_{21}b_{31} & r_{f1,f2}b_{21}b_{42} & r_{f1,f2}b_{21}b_{52} & r_{f1,f2}b_{21}b_{62} \\ b_{31}b_{11} & b_{31}b_{21} & b_{31}^2 + \sigma_{\symbf{\varepsilon}_3}^2 & r_{f1,f2}b_{31}b_{42} & r_{f1,f2}b_{31}b_{52} & r_{f1,f2}b_{31}b_{62} \\ r_{f1,f2}b_{42}b_{11} & r_{f1,f2}b_{42}b_{21} & r_{f1,f2}b_{42}b_{31} & b_{42}^2 + \sigma_{\symbf{\varepsilon}_4}^2 & b_{42}b_{52} & b_{42}b_{62} \\ r_{f1,f2}b_{52}b_{11} & r_{f1,f2}b_{52}b_{21} & r_{f1,f2}b_{52}b_{31} & b_{52}b_{42} & b_{52}^2 + \sigma_{\symbf{\varepsilon}_5}^2 & b_{52}b_{62} \\ r_{f1,f2}b_{62}b_{11} & r_{f1,f2}b_{62}b_{21} & r_{f1,f2}b_{62}b_{31} & b_{62}b_{42} & b_{62}b_{52} & b_{62}^2 + \sigma_{\symbf{\varepsilon}_6}^2 \end{bmatrix} \end{split} \end{aligned} \tag{7.8}\] となります。

例えばy_1とy_4の繋がりを 図 7.3 で見てみると,y_1 → f_1 → f_2 → y_4という経路になっており,この2変数の共分散はそれぞれの矢印に係る係数の積である\(r_{f1,f2}b_{42}b_{11}\)となっていることがわかります。 もし因子間に相関がなければ,y_1とy_4を結ぶ経路は存在せず,数式的には\(r_{f1,f2}=0\)となることからも,この2変数が完全に無相関であることを意味するようになります。

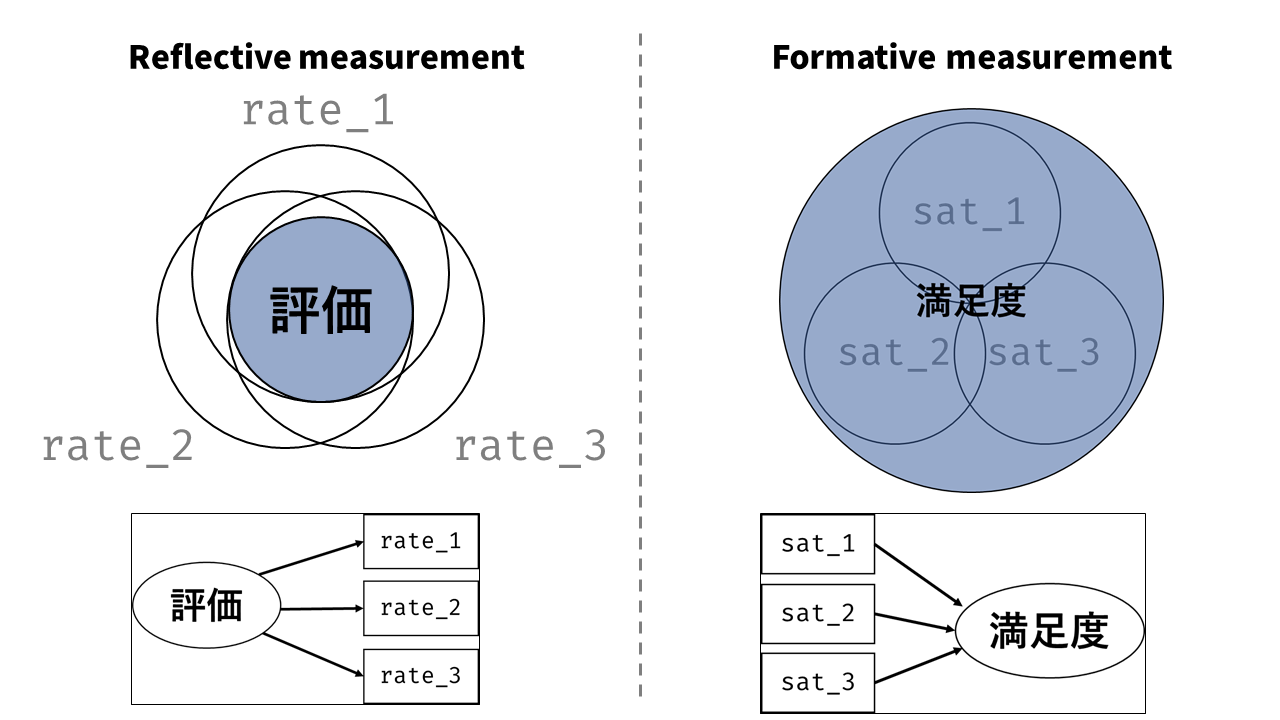

このモデルの重要なポイントは,分散共分散行列が\(\symbf{B}^\top\symbf{\Phi} \symbf{B} + \symbf{\Psi}\)という形で分解可能だという点は前回までの因子分析と全く同じだという点です。 SEMの枠組みでは,因子負荷行列\(\symbf{B}\)や因子間相関\(\symbf{\Phi}\)に関して要素の値を固定(通常は0に固定)するため,それに応じて観測変数間の共分散の形は変わりますが,違いといえばそれだけです4。 特定の因子が特定の項目にのみ負荷を持っているという仮定は,分析者が仮説などに基づいて行うものです。 そして得られた結果(\(\symbf{\Sigma}\)と\(\symbf{S}\)の乖離度)は,その仮説(に基づく共分散構造)がどの程度妥当そうかを表したものといえます。 そのような意味で,SEMにおける因子分析を検証的(確認的)因子分析(confirmatory factor analysis; CFA)と呼びます。 一方,前回まで行っていた因子分析は,因子構造を探し当てるのが目的だったため探索的因子分析(exploratory factor analysis; EFA)と呼んでいます。

上述のモデルでは,推定するパラメータは全部で13個(6個の因子負荷+6個の誤差分散+1個の因子間相関)あり,対する観測変数間の分散共分散の数が全部で21個(分散が6個+共分散が15個)あります。 ということで1因子3項目の場合のように解を一意に求めることは出来ないのですが,なるべく誤差が小さくなるように全てのパラメータをまとめて推定することは可能なわけです。

7.1.3 もう少しだけ複雑なモデル

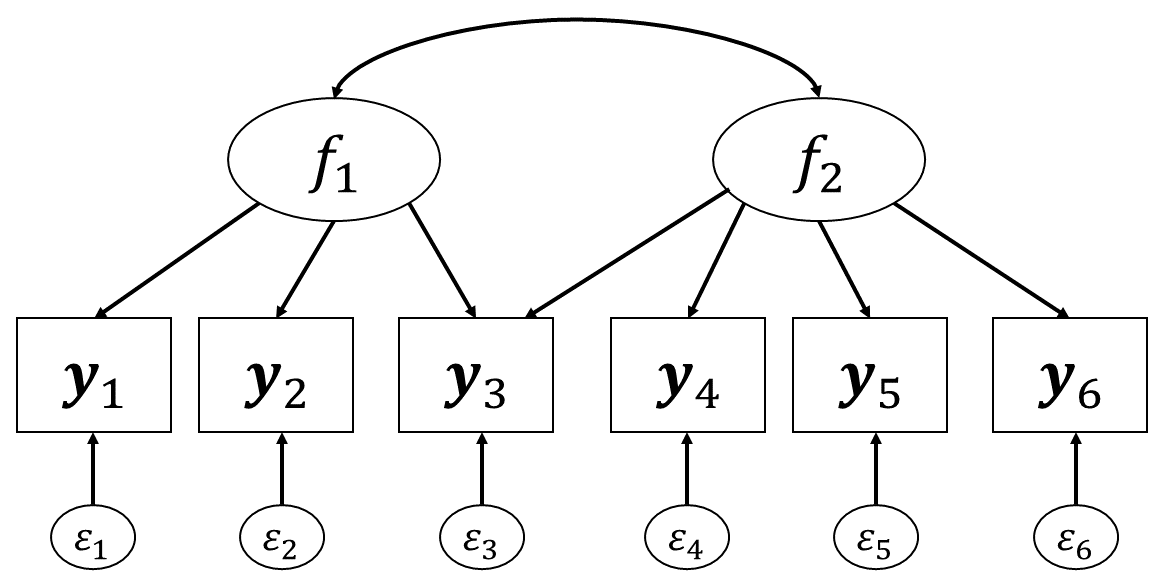

CFAでは,「ある項目は2つの因子の影響を受けている」というモデルを作ることも当然可能です。 図 7.4 は,項目3だけが2つの因子の影響を受けていると仮定しています。 この時,因子負荷行列は \[

\begin{aligned}

\symbf{B}^\top = \begin{bmatrix}

b_{11} & 0\\

b_{21} & 0\\

b_{31} & b_{32}\\

0 & b_{42} \\

0 & b_{52}\\

0 & b_{62}

\end{bmatrix}

\end{aligned}

\tag{7.9}\] となります。このとき共分散行列はどうなるでしょうか。 (7.8)式と同じ要領で\(\symbf{\Sigma}\)は計算できるのですが,すべて書くのは面倒ですね。 例えば項目1と3の共分散だけ抜き出してみると \[

\sigma_{y1, y3} = b_{31}b_{11} + r_{f1,f2}b_{32}b_{11}

\tag{7.10}\] という形になっています。 改めて 図 7.4 でy_1とy_3の経路を見てみると,

y_1→f_1→y_3(\(b_{31}b_{11}\))y_1→f_1→f_2→y_3(\(r_{f1,f2}b_{32}b_{11}\))

という2つの経路が存在しており,それに対応した係数の積の和がこの2変数の共分散を表すようになっています。 また,項目3の分散は \[ \sigma_{y3}^2 = b_{31}^2 + b_{32}^2 + 2r_{f1,f2}b_{31}b_{32} + \sigma_{\symbf{\varepsilon}_3}^2 \tag{7.11}\] となります。1因子モデルのときも分散は係数の二乗和になっていましたが,より正確に言えば

y_3→f_1→y_3(\(b_{31}^2\))y_3→f_2→y_3(\(b_{32}^2\))y_3→e_3→y_3(\(\sigma_{\symbf{\varepsilon}_3}^2\))y_3→f_1→f_2→y_3(\(r_{f1,f2}b_{31}b_{32}\))y_3→f_2→f_1→y_3(\(r_{f1,f2}b_{31}b_{32}\))

という要領で,その変数を出発してから戻るまでの経路の全パターンに関して同様の計算をしていたわけです。

SEMにおいて2つの観測変数の共分散がモデル上でどのように表現されるかの考え方は,Wright’s tracing rulesとして知られています(Wright, 1934)。 これは,以下の3つのシンプルなルールによって表されます(Loehlin & Beaujean, 2016)。

- ループの禁止 (No loops):同じ変数を通過して元の場所に戻ったり、同じ変数を二度経由してはならない。

- 逆流の禁止 (No going forward then backward):一度矢印の向きに従って進んだら(順方向),その経路内で矢印を遡る動き(逆方向)をしてはいけない。

- 双方向矢印の制限 (A maximum of one curved arrow per path):双方向の矢印(共分散・相関)は、1つの経路につき1回しか通れない。

特に潜在変数が絡む因子分析のようなモデルでは,上記のルールを満たしながら考えることができる観測変数間の経路を全て列挙し,その経路にかかる係数の積を計算していくわけです。

7.2 Rでやってみる(検証的因子分析)

それでは, 図 7.3 の2因子モデルを実際にSEMの枠組み(検証的因子分析)で推定してみましょう。 lavaanでは,lm()などと同じように第一引数にモデル式を与えます。 ただ複雑なモデルになると結構な長さになるので,以下のように事前にモデル式をオブジェクトに入れておくのがおすすめです。

モデル式はcharacter型で用意するため,ダブルクオート(" ")かシングルクオート(' ')で全体をくくります。 その中に,回帰式のようなものを書き連ねていきます。 lavaanの構文では,潜在変数を規定する場合にはイコールチルダ(=~)を使用します。 つまり,上のコードの4行目では「因子f_1はQ1_1とQ1_2とQ1_3に影響を与えているもの」であることを表しているわけです。 ちなみに観測変数に関してはデータフレームの列名で指定しますが,潜在変数はデータフレーム内に存在しないので,自分でわかりやすい名前をつけても構いません。 例えばQ1_1とQ1_2とQ1_3は”Agreeableness”を測定する項目だとわかっているので,1行目はf_A =~ Q1_1 + Q1_2 + Q1_3としても良いわけです。 lavaanでは,データフレームに存在しない変数は自動的に潜在変数であるとみなして分析を行ってくれます。

モデル式が用意できたら,あとは分析を実行するだけです。 検証的因子分析の場合にはcfa()という関数を利用しましょう5。

lavaan 0.6-20 ended normally after 38 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 13

Number of observations 2432

Model Test User Model:

Test statistic 62.061

Degrees of freedom 8

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|)

f_1 =~

Q1_1 1.000

Q1_2 1.548 0.106 14.538 0.000

Q1_3 1.348 0.082 16.362 0.000

f_2 =~

Q1_6 1.000

Q1_7 1.220 0.075 16.316 0.000

Q1_8 0.894 0.053 16.756 0.000

Covariances:

Estimate Std.Err z-value P(>|z|)

f_1 ~~

f_2 0.115 0.016 7.349 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_1 1.607 0.051 31.229 0.000

.Q1_2 0.492 0.054 9.151 0.000

.Q1_3 1.036 0.050 20.917 0.000

.Q1_6 0.950 0.043 22.233 0.000

.Q1_7 0.888 0.055 16.193 0.000

.Q1_8 1.205 0.044 27.532 0.000

f_1 0.368 0.040 9.180 0.000

f_2 0.567 0.047 11.995 0.000結果を上から見ていきましょう。

Estimatorのところで,最尤推定法(ML)によってパラメータを求めていることがわかります。 パラメータは反復計算で求めているのですが,Optimization methodはその計算アルゴリズムを示しています。基本的には触れなくてOKです。 Number of model parametersはモデルのパラメータ数です。6個の因子負荷+6個の誤差分散+1個の因子間相関で13個ということは先程説明した通りです。

モデルに対して\(\chi^2\)検定を行っています。 帰無仮説は「モデルの共分散行列とデータの共分散行列が同じ」ということで,\(p\)値が大きい(帰無仮説が棄却されない)ほど当てはまりが良いことを意味します。 つまり,できればこの検定は棄却されない(\(p>.05\))と嬉しいのですが,統計的仮説検定の仕組み上サンプルサイズが多いほど帰無仮説が棄却されやすかったりとなかなか使い勝手の良いものではないので,基本的には無視でも良いでしょう。

因子負荷です。 lavaanはデフォルトでは,パラメータの制約として「因子の分散が1」の代わりに「各因子の第1項目に対する因子負荷が1」という制約を置いています。 因子分析の資料の3ページで潜在変数のスケールの不定性を説明しましたが,lavaanのデフォルトでは因子ごとに最初の項目の\(b\)の値を一つ固定することによってその不定性を封じているわけです。 ですが一般的には「因子の分散が1」の方がよく用いられる制約なので,そのようにした場合の推定値も出力してみます。 その方法は2種類あり,1つ目の方法は「推定時に引数std.lv = TRUEを与える」というものです。

lavaan 0.6-20 ended normally after 27 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 13

Number of observations 2432

Model Test User Model:

Test statistic 62.061

Degrees of freedom 8

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|)

f_1 =~

Q1_1 0.607 0.033 18.359 0.000

Q1_2 0.939 0.034 27.729 0.000

Q1_3 0.818 0.034 24.120 0.000

f_2 =~

Q1_6 0.753 0.031 23.990 0.000

Q1_7 0.919 0.035 26.112 0.000

Q1_8 0.673 0.031 21.419 0.000

Covariances:

Estimate Std.Err z-value P(>|z|)

f_1 ~~

f_2 0.251 0.028 8.852 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_1 1.607 0.051 31.229 0.000

.Q1_2 0.492 0.054 9.151 0.000

.Q1_3 1.036 0.050 20.917 0.000

.Q1_6 0.950 0.043 22.233 0.000

.Q1_7 0.888 0.055 16.193 0.000

.Q1_8 1.205 0.044 27.532 0.000

f_1 1.000

f_2 1.000 std.lv = TRUEとすることで,潜在変数(latent variable)を標準化(standardized)することができます。 また,もう一つの方法は「summary()時に引数standardized = TRUEを与える」というものです。 この方法では因子の分散を1に調整した場合の推定値を事後的に変換して出力してくれます。

lavaan 0.6-20 ended normally after 38 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 13

Number of observations 2432

Model Test User Model:

Test statistic 62.061

Degrees of freedom 8

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_1 =~

Q1_1 1.000 0.607 0.432

Q1_2 1.548 0.106 14.538 0.000 0.939 0.801

Q1_3 1.348 0.082 16.362 0.000 0.818 0.626

f_2 =~

Q1_6 1.000 0.753 0.611

Q1_7 1.220 0.075 16.316 0.000 0.919 0.698

Q1_8 0.894 0.053 16.756 0.000 0.673 0.523

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_1 ~~

f_2 0.115 0.016 7.349 0.000 0.251 0.251

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.607 0.051 31.229 0.000 1.607 0.814

.Q1_2 0.492 0.054 9.151 0.000 0.492 0.358

.Q1_3 1.036 0.050 20.917 0.000 1.036 0.608

.Q1_6 0.950 0.043 22.233 0.000 0.950 0.626

.Q1_7 0.888 0.055 16.193 0.000 0.888 0.513

.Q1_8 1.205 0.044 27.532 0.000 1.205 0.727

f_1 0.368 0.040 9.180 0.000 1.000 1.000

f_2 0.567 0.047 11.995 0.000 1.000 1.000引数standardized = TRUEを与えると,係数の出力の右にStd.lvとStd.allという2つの列が追加されます。 Std.lv列は,推定時に引数std.lv = TRUEを与えた時と同じ「潜在変数のみ標準化された場合」の推定値です。 一方Std.all列はその名の通り「観測変数も含めて全て標準化された場合」の推定値,すなわち標準化解を出しています。

ただ実際の推定時には,std.lv = TRUEをいれると同時に,summary()時にstandardized = TRUEを入れるようにすると良いのではないかと思います。 というのもcfa(std.lv = TRUE)のみだと観測変数まで標準化した標準化解が出力されません。 一方summary(standardized = TRUE)のみだと各因子の第1項目の因子負荷が推定されなくなるため,仮説検定を行ってくれないためです。

ということで改めて因子負荷から見ていきます。

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_1 =~

Q1_1 0.607 0.033 18.359 0.000 0.607 0.432

Q1_2 0.939 0.034 27.729 0.000 0.939 0.801

Q1_3 0.818 0.034 24.120 0.000 0.818 0.626

f_2 =~

Q1_6 0.753 0.031 23.990 0.000 0.753 0.611

Q1_7 0.919 0.035 26.112 0.000 0.919 0.698

Q1_8 0.673 0.031 21.419 0.000 0.673 0.523左から「推定値」「標準誤差」「検定統計量\(z\)」「\(p\)値」「Std.lv」「Std.all」と並んでいます。 回帰分析のときと同じように「因子負荷が0」という帰無仮説に対して仮説検定を行っています。 検定の結果は標準化してもしなくても変わらないのでご安心ください。

共分散です。Std.lvとStd.allでは潜在変数の分散は1になっているため,ここに表示されている0.251は2因子の因子間相関を表しています。

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.607 0.051 31.229 0.000 1.607 0.814

.Q1_2 0.492 0.054 9.151 0.000 0.492 0.358

.Q1_3 1.036 0.050 20.917 0.000 1.036 0.608

.Q1_6 0.950 0.043 22.233 0.000 0.950 0.626

.Q1_7 0.888 0.055 16.193 0.000 0.888 0.513

.Q1_8 1.205 0.044 27.532 0.000 1.205 0.727

f_1 1.000 1.000 1.000

f_2 1.000 1.000 1.000各変数の分散です。Std.lvとStd.allでは一番下の2つ(f_1とf_2)の分散は1に固定されています。 変数名の左に.がついているものは,その観測変数にくっつく独自因子の分散(または誤差分散)を表しています。

独自因子の分散のなかでもStd.all列に表示された値は,探索的因子分析と同じように独自性の値として考えることが出来ます。 例えば項目Q1_1では,Std.allの値=独自因子の分散が0.814です。これに対して因子負荷は0.432でした。 実際に因子負荷の二乗と独自因子の分散の和は\(0.432^2+0.814\approx1\)となります。

実際にcfa()関数によって推定されたパラメータの値(Std.all)を,(7.8)式に代入して\(\symbf{\Sigma}\)を計算してみましょう(添字の項目番号はデータに合わせて変えています)。

\[ \begin{aligned} \symbf{\Sigma} &= \symbf{B}^\top\symbf{\Phi} \symbf{B} + \symbf{\Psi} \\ &=\begin{bmatrix} b_{11}^2 + \sigma_{\symbf{\varepsilon}_1}^2 & b_{11}b_{21} & b_{11}b_{31} & r_{f1,f2}b_{11}b_{62} & r_{f1,f2}b_{11}b_{72} & r_{f1,f2}b_{11}b_{82} \\ b_{21}b_{11} & b_{21}^2 + \sigma_{\symbf{\varepsilon}_2}^2 & b_{21}b_{31} & r_{f1,f2}b_{21}b_{62} & r_{f1,f2}b_{21}b_{72} & r_{f1,f2}b_{21}b_{82} \\ b_{31}b_{11} & b_{31}b_{21} & b_{31}^2 + \sigma_{\symbf{\varepsilon}_3}^2 & r_{f1,f2}b_{31}b_{62} & r_{f1,f2}b_{31}b_{72} & r_{f1,f2}b_{31}b_{82} \\ r_{f1,f2}b_{62}b_{11} & r_{f1,f2}b_{62}b_{21} & r_{f1,f2}b_{62}b_{31} & b_{62}^2 + \sigma_{\symbf{\varepsilon}_6}^2 & b_{62}b_{72} & b_{62}b_{82} \\ r_{f1,f2}b_{72}b_{11} & r_{f1,f2}b_{72}b_{21} & r_{f1,f2}b_{72}b_{31} & b_{72}b_{62} & b_{72}^2 + \sigma_{\symbf{\varepsilon}_7}^2 & b_{72}b_{82} \\ r_{f1,f2}b_{82}b_{11} & r_{f1,f2}b_{82}b_{21} & r_{f1,f2}b_{82}b_{31} & b_{82}b_{62} & b_{82}b_{72} & b_{82}^2 + \sigma_{\symbf{\varepsilon}_8}^2 \end{bmatrix} \\ &=\begin{bmatrix} 0.432^2 + 0.814 & 0.432\times0.801 & 0.432\times0.626 & 0.251\times0.432\times0.611 & 0.251\times0.432\times0.698 & 0.251\times0.432\times0.523 \\ 0.801\times0.432 & 0.801^2 + 0.358 & 0.801\times0.626 & 0.251\times0.801\times0.611 & 0.251\times0.801\times0.698 & 0.251\times0.801\times0.523 \\ 0.626\times0.432 & 0.626\times0.801 & 0.626^2 + 0.608 & 0.251\times0.626\times0.611 & 0.251\times0.626\times0.698 & 0.251\times0.626\times0.523 \\ 0.251\times0.611\times0.432 & 0.251\times0.611\times0.801 & 0.251\times0.611\times0.626 & 0.611^2 + 0.626 & 0.611\times0.698 & 0.611\times0.523 \\ 0.251\times0.698\times0.432 & 0.251\times0.698\times0.801 & 0.251\times0.698\times0.626 & 0.698\times0.611 & 0.698^2 + 0.513 & 0.698\times0.523 \\ 0.251\times0.523\times0.432 & 0.251\times0.523\times0.801 & 0.251\times0.523\times0.626 & 0.523\times0.611 & 0.523\times0.698 & 0.523^2 + 0.727 \end{bmatrix} \\ &\approx\begin{bmatrix} 1 & 0.346 & 0.270 & 0.066 & 0.076 & 0.057 \\ 0.346 & 1 & 0.501 & 0.123 & 0.140 & 0.105 \\ 0.270 & 0.501 & 1 & 0.096 & 0.110 & 0.082 \\ 0.066 & 0.123 & 0.096 & 1 & 0.426 & 0.320 \\ 0.076 & 0.140 & 0.110 & 0.426 & 1 & 0.365 \\ 0.057 & 0.105 & 0.082 & 0.320 & 0.365 & 1 \end{bmatrix} \end{aligned} \]

そして,cor()関数でデータの相関行列\(\symbf{S}\)を出力してみると以下のようになります。

ということで,モデルから計算された相関行列\(\symbf{\Sigma}\)と,実際のデータの相関行列\(\symbf{S}\)の差を取ると, \[ \symbf{\Sigma}-\symbf{S} = \begin{bmatrix} 0 & -0.007 & -0.004 & 0.077 & 0.087 & 0.033 \\ -0.007 & 0 & 0.004 & 0.025 & 0.016 & -0.080 \\ -0.004 & 0.004 & 0 & -0.014 & -0.032 & -0.044 \\ 0.077 & 0.025 & -0.014 & 0 & -0.009 & 0.007 \\ 0.087 & 0.016 & -0.032 & -0.009 & 0 & 0.006 \\ 0.033 & -0.080 & -0.044 & 0.007 & 0.006 & 0 \end{bmatrix} \tag{7.12}\] と,多くの要素が0に近い値になっていることがわかります。 これは,モデルによってデータの共分散構造がかなり良く再現されていることを意味します。 一方で,もしも\(\symbf{\Sigma}-\symbf{S}\)の値が大きくなってしまう場合には,そもそもモデルの構造自体がデータに合っていないために,頑張って「\(\symbf{\Sigma}\)と\(\symbf{S}\)ができるだけ近い値になるように」パラメータを推定しても,あまり良い結果が得られなかった可能性が高いのです。

ということでSEMでは,推定したパラメータをもとに復元したモデル上の共分散行列\(\symbf{\Sigma}\)と,データにおいて観測された実際の共分散行列\(\symbf{S}\)がきちんと近い値になっているかの確認が非常に重要になります(詳細は セクション 7.6 で)。

ちなみに因子得点は,predict()関数によって出すことが出来ます。

探索的因子分析のときと同様に,この因子得点の相関はモデル上の因子間相関(今回の場合0.251)とは異なります。利用する際は気をつけてください。

7.3 回帰分析の見方を変える

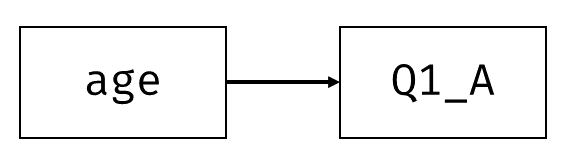

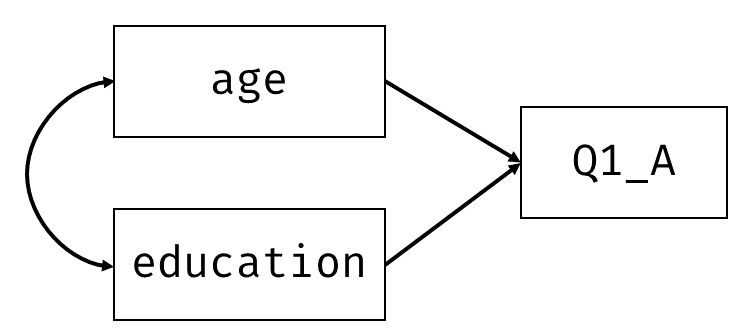

SEMでは回帰分析も共通の枠組みで取り扱うことが出来ます。つまり観測変数間の共分散構造をモデルのパラメータで表し,推定を行います。 最もシンプルな回帰モデルとして, 図 7.5 のように協調性の得点Q1_Aを年齢ageで回帰してみましょう。

このモデルの回帰式は \[ x_A = b_0 + b_1x_{\mathrm{age}} + \varepsilon_A \tag{7.13}\] となります。したがって,この2変数の共分散行列は \[ \symbf{\Sigma} = \begin{bmatrix} \sigma_{x_{A}}^2 & \sigma_{x_A, x_{\mathrm{age}}}\\ \sigma_{x_A, x_{\mathrm{age}}} & \sigma_{x_{\mathrm{age}}}^2 \end{bmatrix} = \begin{bmatrix} b_1^2 \sigma_{x_{\mathrm{age}}}^2+ \sigma_{\varepsilon_A}^2 & b_1\sigma_{x_{\mathrm{age}}}^2 \\ b_1\sigma_{x_{\mathrm{age}}}^2 & \sigma_{x_{\mathrm{age}}}^2 \end{bmatrix} \tag{7.14}\] と表せます。 回帰モデルなので,変数\(x_A\)は\(x_{\mathrm{age}}\)の値に応じて変化していると見ることも出来ます。 言い換えると,\(x_A\)の値はモデルの中で決まっているということです。 このように,モデル式の中で他の変数の関数によって表される変数のことを内生変数(endogenous variable)と呼びます。 一方,変数\(x_{\mathrm{age}}\)は他の変数の値によって変化することはありません。こうした変数を,内生変数に対して外生変数(exogenous variable)と呼びます。 グラフィカルモデル的には,他の変数からの一方向矢印が一つでも刺さっているものは全て内生変数と呼びます。 SEMではこの「内生変数」と「外生変数」の分類がちょくちょく出てくるので,覚えておいてください。

さて,先程の回帰モデルをSEMで見た場合,推定しないといけないパラメータは\(b_1\)と\(\sigma_{\varepsilon_A}^2\)の2つです(\(\sigma_{x_{\mathrm{age}}}^2\)はデータから直接求めたら良いので)。 そしてデータからは(cov()関数を使えば)2つの変数の分散および共分散 \[

\symbf{S} = \begin{bmatrix}

s_{x_{A}}^2 & s_{x_A, x_{\mathrm{age}}}\\

s_{x_A, x_{\mathrm{age}}} & s_{x_{\mathrm{age}}}^2

\end{bmatrix}= \begin{bmatrix}

20.667 & 8.906\\

8.906 & 120.303

\end{bmatrix}

\] の(上三角と下三角は同じ式なので)計3つが計算できるため,これでモデルのパラメータが推定できます。 一応連立方程式を立ててみると, \[

\left\{

\begin{aligned}

20.667 &= b_1^2 \sigma_{x_{\mathrm{age}}}^2+ \sigma_{\varepsilon_A}^2 \\

8.906 &= b_1\sigma_{x_{\mathrm{age}}}^2 \\

120.303 &= \sigma_{x_{\mathrm{age}}}^2

\end{aligned}

\right\} = \left\{\begin{aligned}

20.667 &= 120.303b_1^2+ \sigma_{\varepsilon_A}^2 \\

8.906 &= 120.303b_1

\end{aligned}\right\}

\] となります。このように,外生変数の分散が連立方程式に含まれる場合には,その外生変数のデータでの分散をそのまま入れてあげることが出来ます。 なお,共分散構造のみを扱うならば,切片\(b_0\)は推定の対象になっていないという点には気をつけてください。 切片もモデルの推定対象にしたい場合には,平均構造も含めたSEMを実行する必要があります6。

実際に計算してみると,\((b_1, \sigma_{\varepsilon_A}^2)=(0.074, 20.007)\)という値が得られます。これを\(\symbf{\Sigma}\)にあてはめてみると, \[ \symbf{\Sigma} = \begin{bmatrix} 0.074^2 \times 120.303 + 20.007 & \\ 0.074 \times 120.303 & 120.303 \end{bmatrix} \approx \begin{bmatrix} 20.667 & \\ 8.906 & 120.303 \end{bmatrix} \] ということで,データの共分散行列\(\symbf{S}\)に一致する値が得られました。

7.3.1 もう少し複雑なモデル(パス解析)

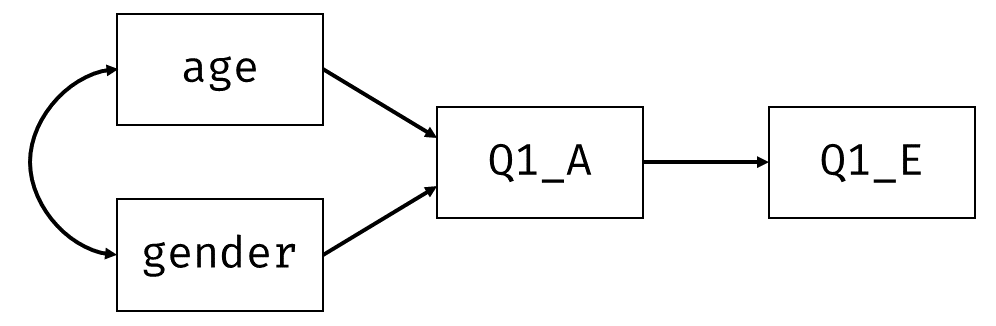

モデルが複雑になってもやることは同じです。回帰式を順に展開していき,全ての変数の分散共分散を「外生変数の分散とパラメータ」で表してあげます。 例えば 図 7.6 は重回帰分析に単回帰分析をくっつけたようなモデルです。 ちなみにこのように,単一の回帰式で表せないような,回帰分析をくっつけたモデルは,SEMの中でも特にパス解析(path analysis)と呼ばれることがあります。

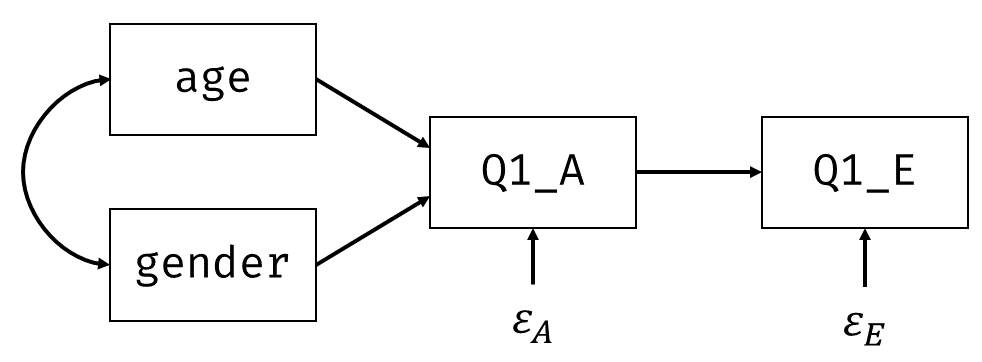

回帰式はそれぞれ \[ \left\{\begin{aligned} x_A &= b_{0A} + b_{\mathrm{gender}}x_{\mathrm{gender}} + b_{\mathrm{age}}x_{\mathrm{age}} + \varepsilon_A \\ x_E &= b_{0E} + b_{A}x_{A} + \varepsilon_E \end{aligned}\right. \tag{7.15}\] となりますが,さらに下の式の\(x_{A}\)を展開することで \[ \left\{\begin{aligned} x_A &= b_{\mathrm{gender}}x_{\mathrm{gender}} + b_{\mathrm{age}}x_{\mathrm{age}} + b_{0A} + \varepsilon_A \\ x_E &= b_{A}\left(b_{0A} + b_{\mathrm{gender}}x_{\mathrm{gender}} + b_{\mathrm{age}}x_{\mathrm{age}} + \varepsilon_A\right) + b_{0E} + \varepsilon_E \\ &= b_{A}b_{0A} + b_{A}b_{\mathrm{gender}}x_{\mathrm{gender}} + b_{A}b_{\mathrm{age}}x_{\mathrm{age}} + b_{A}\varepsilon_A + b_{0E} + \varepsilon_E \end{aligned}\right. \tag{7.16}\] となります。 なお,検証的因子分析での独自因子と同じように,パス解析でも内生変数に誤差項を明示することがあります( 図 7.7 )7。 こうすることによって,各変数の分散および共分散を考えるのが多少楽になります(後述)。

4つの変数のモデル上の共分散行列\(\symbf{\Sigma}\)の各成分は,頑張って展開すると \[ \left\{ \begin{aligned} \sigma_{x_{\mathrm{age}}}^2 &= \sigma_{x_{\mathrm{age}}}^2 \\ \sigma_{x_{\mathrm{gender}}}^2 &= \sigma_{x_{\mathrm{gender}}}^2 \\ \sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} &= \sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} \\ \sigma_{x_{A}}^2 &= b_{\mathrm{gender}}^2\sigma_{x_{\mathrm{gender}}}^2 + b_{\mathrm{age}}^2\sigma_{x_{\mathrm{age}}}^2 + 2b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} + \sigma_{\varepsilon_{A}}^2 \\ \sigma_{x_{E}}^2 &= b_{A}^2b_{\mathrm{gender}}^2\sigma_{x_{\mathrm{gender}}}^2 + b_{A}^2b_{\mathrm{age}}^2\sigma_{x_{\mathrm{age}}}^2 + 2b_{A}^2b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}}+b_A^2\sigma_{\varepsilon_{A}}^2+ \sigma_{\varepsilon_{E}}^2 \\ \sigma_{x_{A}, x_{\mathrm{age}}} &= b_{\mathrm{gender}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} + b_{\mathrm{age}}\sigma_{x_{\mathrm{age}}}^2 \\ \sigma_{x_{E}, x_{\mathrm{age}}} &= b_{A}b_{\mathrm{gender}}\sigma_{x_{\mathrm{age}},x_{\mathrm{gender}}} + b_{A}b_{\mathrm{age}}\sigma_{x_{\mathrm{age}}}^2 \\ \sigma_{x_{A}, x_{\mathrm{gender}}} &= b_{\mathrm{gender}}\sigma_{x_{\mathrm{gender}}}^2 + b_{\mathrm{age}}\sigma_{x_{\mathrm{age}},x_{\mathrm{gender}}} \\ \sigma_{x_{E}, x_{\mathrm{gender}}} &= b_{A}b_{\mathrm{gender}}\sigma_{x_{\mathrm{gender}}}^2 + b_{A}b_{\mathrm{age}}\sigma_{x_{\mathrm{age}},x_{\mathrm{gender}}}\\ \sigma_{x_{E}, x_{A}} &= b_{A}b_{\mathrm{gender}}^2\sigma_{x_{\mathrm{gender}}}^2 + b_{A}b_{\mathrm{age}}^2\sigma_{x_{\mathrm{age}}}^2 + 2b_{A}b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} + b_{A}\sigma_{\varepsilon_{A}}^2 \end{aligned} \right. \tag{7.17}\] となります。 これを 図 7.7 に照らし合わせると,例えば\(\sigma_{x_{A}}^2\)は

Q1_A→gender→Q1_A(\(b_{\mathrm{gender}}^2\sigma_{x_{\mathrm{gender}}}^2\))Q1_A→age→Q1_A(\(b_{\mathrm{age}}^2\sigma_{x_{\mathrm{age}}}^2\))Q1_A→gender→age→Q1_A(\(b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}}\))Q1_A→age→gender→Q1_A(\(b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}}\))Q1_A→e_A→Q1_A(\(\sigma_{\varepsilon_{A}}^2\))

の和になっています。検証的因子分析のときと同じように,自分自身を出発してから最低1つの外生変数を通過して戻るまでの全経路の係数の和になっているわけです。同様に,共分散\(\sigma_{x_{E}, x_{A}}\)では

Q1_E→Q1_A→gender→Q1_A(\(b_{A}b_{\mathrm{gender}}^2\sigma_{x_{\mathrm{gender}}}^2\))Q1_E→Q1_A→age→Q1_A(\(b_{A}b_{\mathrm{age}}^2\sigma_{x_{\mathrm{age}}}^2\))Q1_E→Q1_A→gender→age→Q1_A(\(b_{A}b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}}\))Q1_E→Q1_A→age→gender→Q1_A(\(b_{A}b_{\mathrm{gender}}b_{\mathrm{age}}\sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}}\))Q1_E→Q1_A→e_A→Q1_A(\(b_{A}\sigma_{\varepsilon_{A}}^2\))

という感じで,Q1_EからQ1_Aへの全経路での係数の和の形になっていると見ることができます8。

というわけで,モデル上の共分散行列\(\symbf{\Sigma}\)を求めることが出来ました。あとはこれに対応するデータ上の分散(4つ)と共分散(6つ)を用いて,5つのパラメータ\(\left(b_A, b_{\mathrm{age}},b_{\mathrm{gender}},\sigma_{\varepsilon_{A}}^2,\sigma_{\varepsilon_{E}}^2\right)\)を推定するだけです。

実際に計算してみると, \[ \left\{ \begin{aligned} \sigma_{x_{\mathrm{age}}}^2 &= 120.254 \\ \sigma_{x_{\mathrm{gender}}}^2 &= 0.221 \\ \sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} &= 0.204 \\ b_A &= 0.550 \\ b_{\mathrm{age}} &= 0.071 \\ b_{\mathrm{gender}} &= 1.891 \\ \sigma_{\varepsilon_{A}}^2 &= 19.210 \\ \sigma_{\varepsilon_{E}}^2 &= 22.154 \end{aligned} \right. \] という解が得られます(上3つはデータから直接求めた値)。これを(7.17)式に当てはめてみると, \[ \begin{aligned} \symbf{\Sigma} &= \begin{bmatrix} \sigma_{x_{\mathrm{age}}}^2 & & & \\ \sigma_{x_{\mathrm{gender}}, x_{\mathrm{age}}} & \sigma_{x_{\mathrm{gender}}}^2 & & \\ \sigma_{x_{A}, x_{\mathrm{age}}} & \sigma_{x_{A}, x_{\mathrm{gender}}} & \sigma_{x_{A}}^2 & \\ \sigma_{x_{E}, x_{\mathrm{age}}} & \sigma_{x_{E}, x_{\mathrm{gender}}} & \sigma_{x_{E}, x_{A}} & \sigma_{x_{E}}^2 \end{bmatrix} = \begin{bmatrix} 120.254 & & & \\ 0.204 & 0.221 & & \\ 8.902 & 0.432 & 20.685 & \\ 4.892 & 0.238 & 11.354 & 28.395 \end{bmatrix} \end{aligned} \] となります。また,データ上の共分散行列の値は \[ \symbf{S} = \begin{bmatrix} 120.254 & & & \\ 0.204 & 0.221 & & \\ 8.906 & 0.433 & 20.667 & \\ 4.198 & 0.260 & 11.359 & 28.407 \end{bmatrix} \] となり,だいぶ近い値が得られました。

7.4 Rでやってみる(回帰分析・パス解析)

それでは,lavaanを使って回帰分析をやってみましょう。 sem()関数を使うと,回帰分析を含むパス解析に適した設定で自動的に推定を行ってくれます。

モデル構文では,lm()やglm()のときと同じように,両辺をチルダ(~)でつなげることで観測変数どうしの回帰を表します。 ということで,単回帰分析であれば以下のように1文だけのモデル構文を書けばよいわけです。

lavaan 0.6-20 ended normally after 1 iteration

Estimator ML

Optimization method NLMINB

Number of model parameters 2

Number of observations 2432

Model Test User Model:

Test statistic 0.000

Degrees of freedom 0

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Regressions:

Estimate Std.Err z-value P(>|z|)

Q1_A ~

age 0.074 0.008 8.952 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_A 19.999 0.574 34.871 0.000基本的な結果の見方は因子分析の時と同じです。 出力のRegressions:の部分が回帰係数を,Variances:の部分が誤差分散を表しています。 先程説明したように,SEMでは共分散構造のみを扱うならば,切片\(b_0\)は推定の対象にならないため,切片項\(b_0\)の推定値は出力されていません。 これを出すためには,モデル式に少し手を加える必要があります。 これもlm()やglm()の時と同じなのですが,回帰式に"+ 1"を加えると,切片項を明示的に推定するように指示することが出来ます。

lavaan 0.6-20 ended normally after 1 iteration

Estimator ML

Optimization method NLMINB

Number of model parameters 3

Number of observations 2432

Model Test User Model:

Test statistic 0.000

Degrees of freedom 0

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Regressions:

Estimate Std.Err z-value P(>|z|)

Q1_A ~

age 0.074 0.008 8.952 0.000

Intercepts:

Estimate Std.Err z-value P(>|z|)

.Q1_A 21.122 0.253 83.433 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_A 19.999 0.574 34.871 0.000出力を見ると,新たにIntercepts:という欄ができています。これが切片を表している部分です。 一応,ここまでの結果を,lm()で普通に回帰分析を行った場合と比較してみましょう。

Call:

lm(formula = model, data = dat)

Residuals:

Min 1Q Median 3Q Max

-18.565 -2.602 0.621 3.361 8.064

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 21.121738 0.253261 83.399 <2e-16 ***

age 0.074029 0.008273 8.949 <2e-16 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Residual standard error: 4.474 on 2430 degrees of freedom

Multiple R-squared: 0.0319, Adjusted R-squared: 0.0315

F-statistic: 80.08 on 1 and 2430 DF, p-value: < 2.2e-16lm()では最小二乗法で解を求めている一方,lavaanはデフォルトでは最尤法で解を求めています。 推定法の違いはありますが,回帰係数および切片はほぼ一致する値が得られました。

続いてパス解析もやってみましょう。 基本的には一つ一つの回帰式を順番に書いていけば良いだけです。簡単ですね。

lavaan 0.6-20 ended normally after 1 iteration

Estimator ML

Optimization method NLMINB

Number of model parameters 5

Number of observations 2432

Model Test User Model:

Test statistic 0.709

Degrees of freedom 2

P-value (Chi-square) 0.702

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Regressions:

Estimate Std.Err z-value P(>|z|)

Q1_A ~

gender 1.891 0.189 9.996 0.000

age 0.071 0.008 8.733 0.000

Q1_E ~

Q1_A 0.550 0.021 26.173 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_A 19.210 0.551 34.871 0.000

.Q1_E 22.154 0.635 34.871 0.0007.5 回帰分析と因子分析を組み合わせる

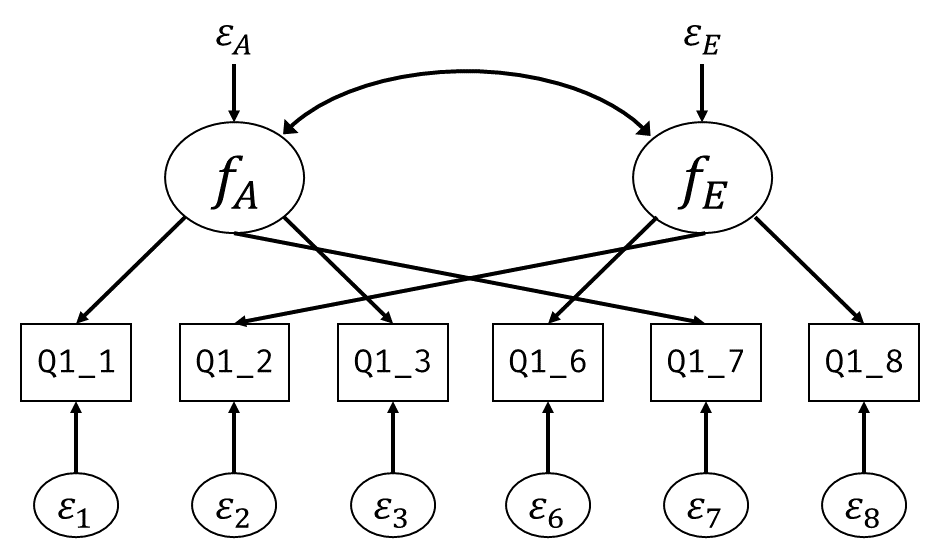

図 7.6 に基づくパス解析では,因子Aと因子Eに関する変数として和得点(Q1_AとQ1_E)を使用しました。 ですが和得点には独自因子(構成概念からすると誤差)の影響が残っているため,可能であれば因子得点を用いた方が「純粋」な構成概念得点であると考えられます。 あるいは(構成概念)妥当性の考え方の根底にあった「観測得点はあくまでも構成概念の顕在化」という考えに従えば,仮説モデルでは構成概念そのもの同士の関係(法則定立ネットワーク)を見るべきだと言えるでしょう。

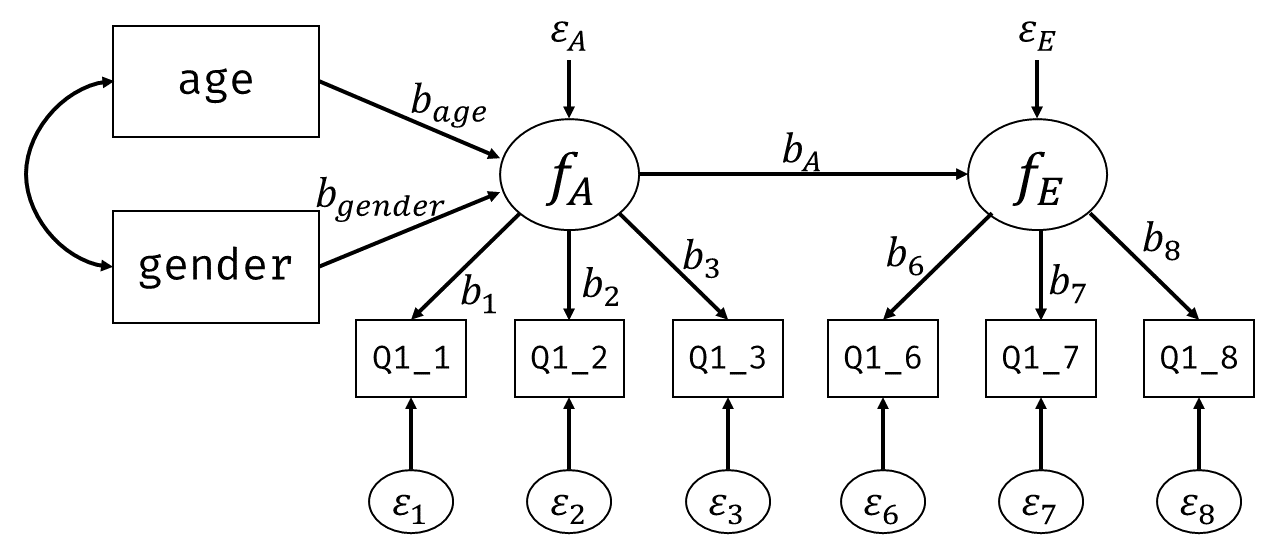

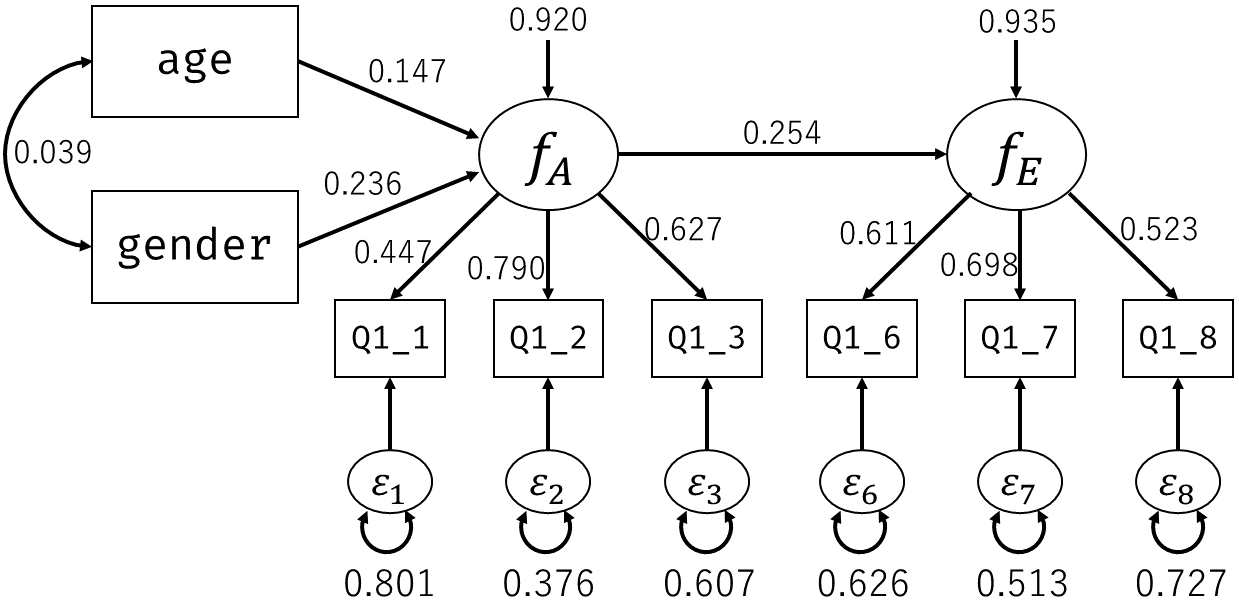

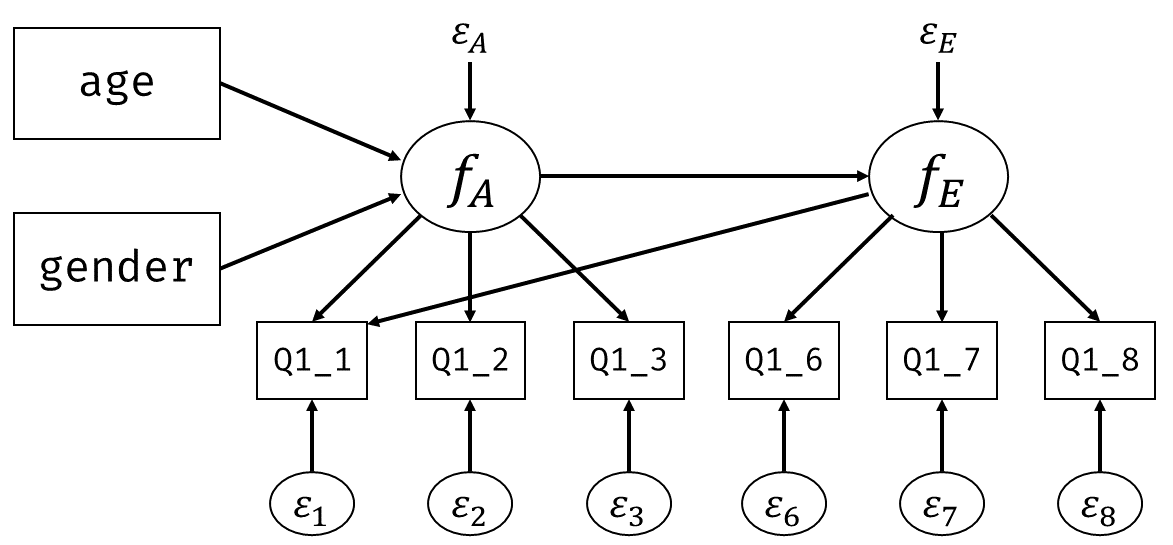

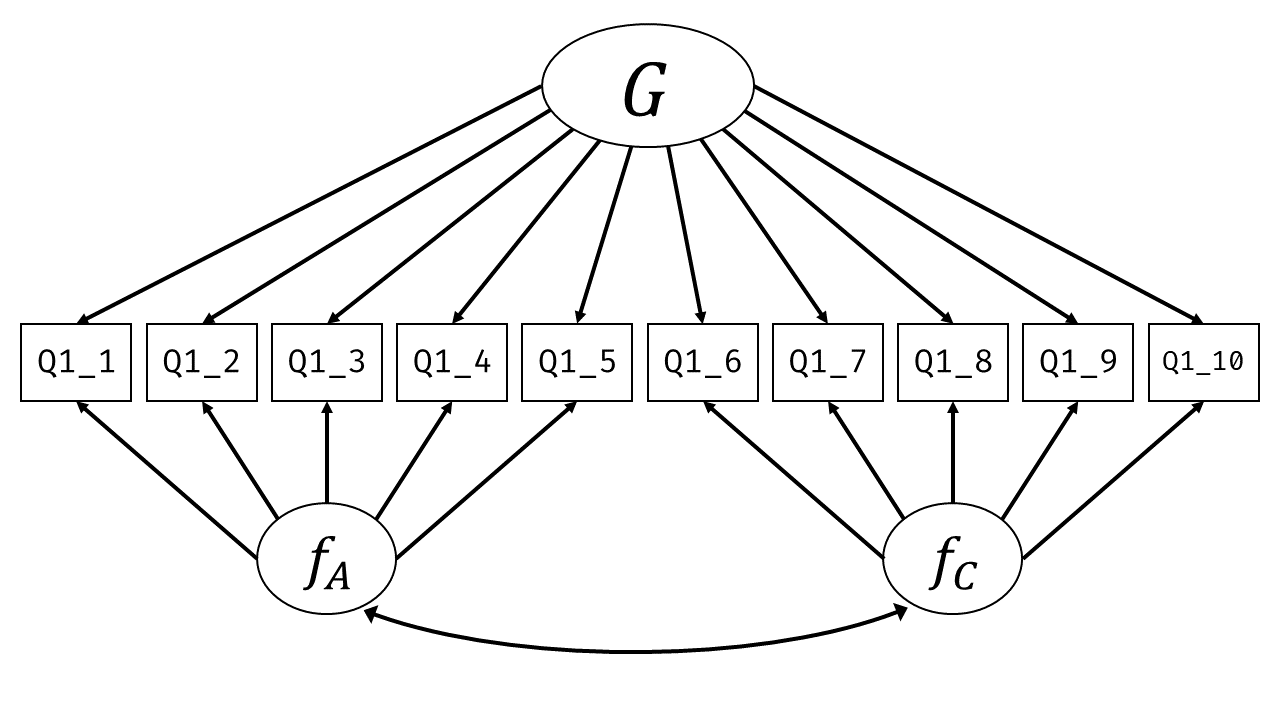

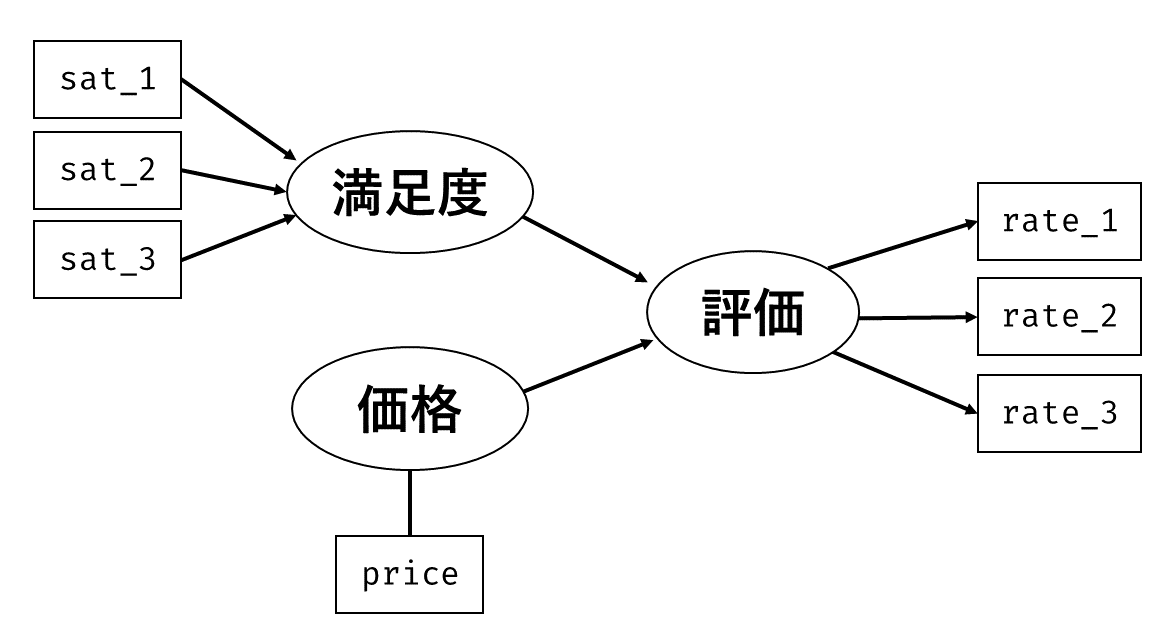

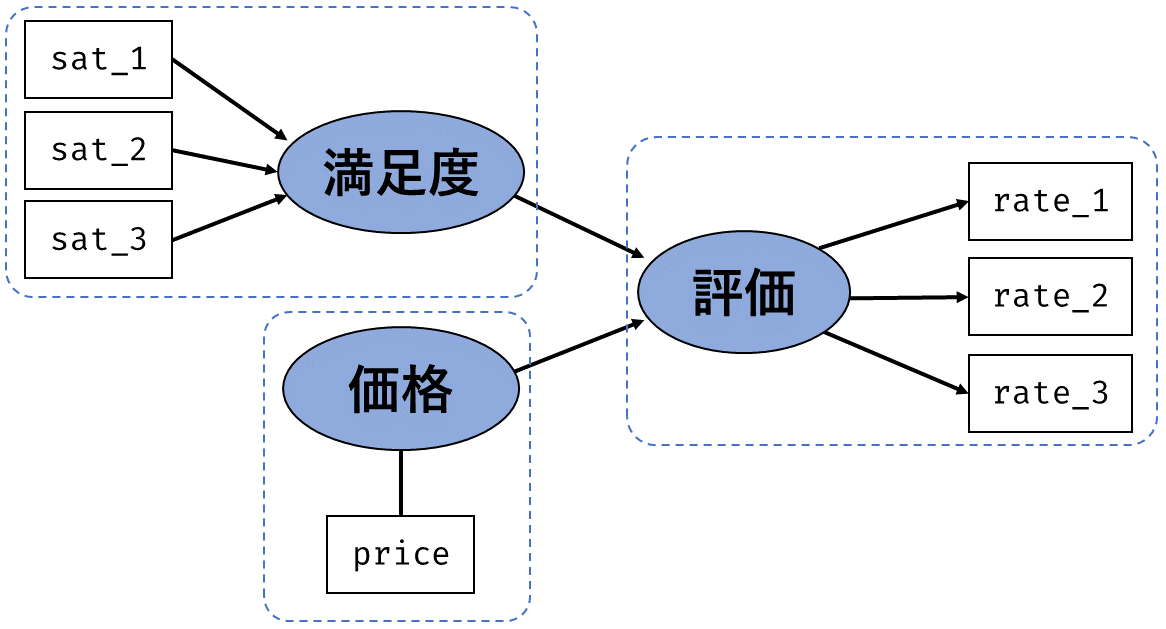

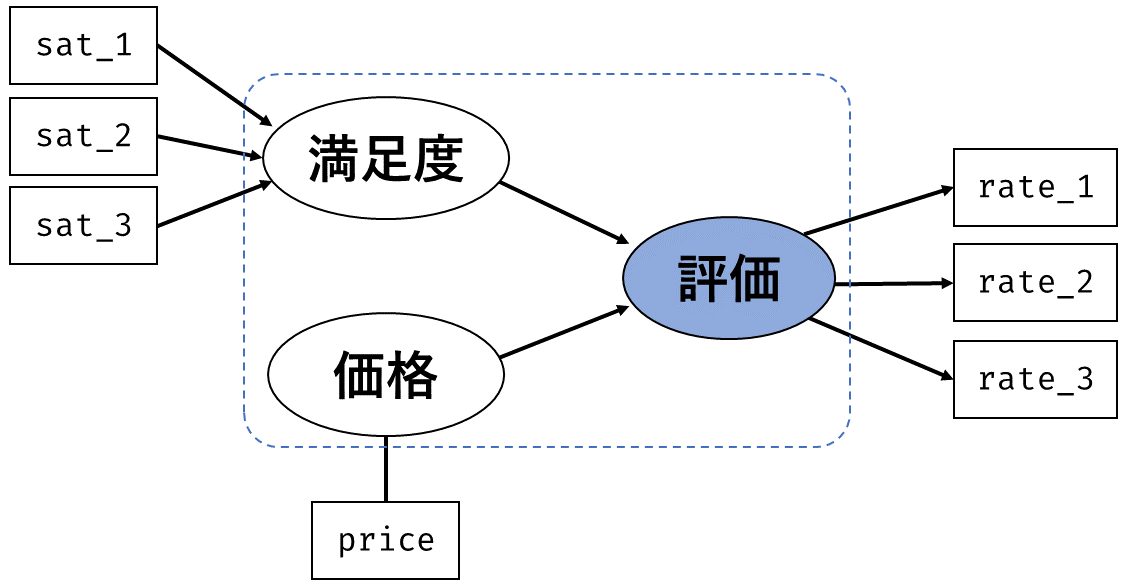

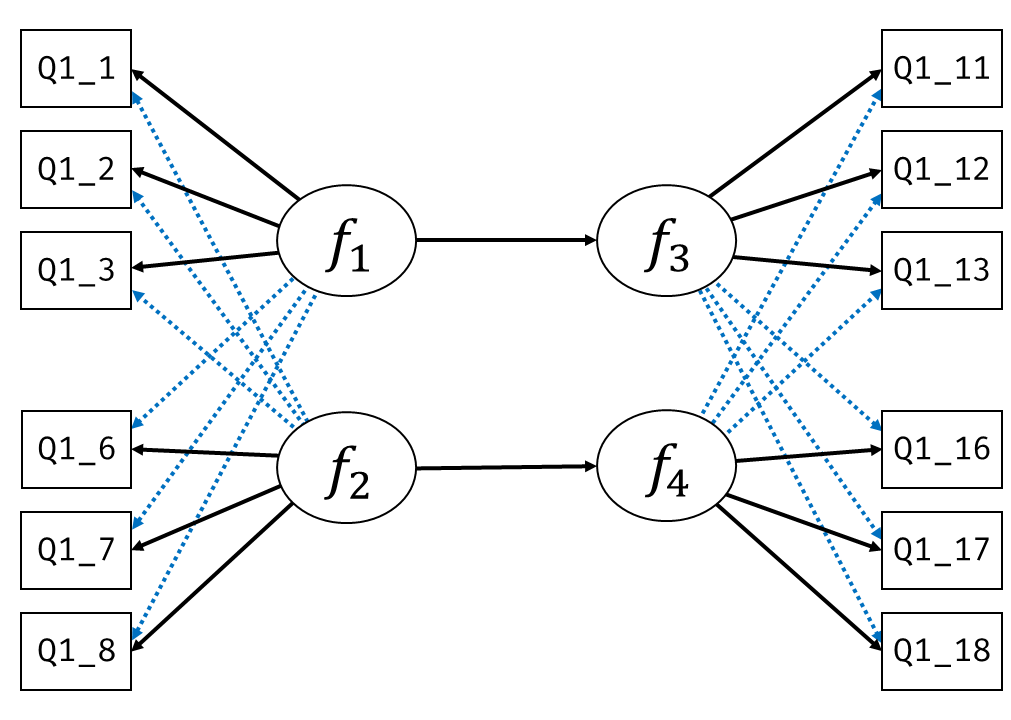

いま,手元には構成概念(因子)を構成する各項目の回答そのものがあります。 そこで, 図 7.3 の因子分析と 図 7.6 の回帰分析を組み合わせて, 図 7.8 のようなモデルを考えてみましょう。

モデルが複雑になってもやることは同じです。 全ての(標準化された)観測変数間の相関行列 \[ \symbf{\Sigma} = \begin{bmatrix} 1 & & & & & & & \\ r_{\mathrm{gender},\mathrm{age}} & 1 & & & & & \\ r_{y1,\mathrm{age}} & r_{y1,\mathrm{gender}} & 1 & & & & \\ r_{y2,\mathrm{age}} & r_{y2,\mathrm{gender}} & r_{y2, y1} & 1 & & \\ r_{y3,\mathrm{age}} & r_{y3,\mathrm{gender}} & r_{y3, y1} & r_{y3,y2} & 1 & \\ r_{y6,\mathrm{age}} & r_{y6,\mathrm{gender}} & r_{y6, y1} & r_{y6,y2} & r_{y6,y3} & 1 & & \\ r_{y7,\mathrm{age}} & r_{y7,\mathrm{gender}} & r_{y7, y1} & r_{y7,y2} & r_{y7,y3} & r_{y7,y6} & 1 & \\ r_{y8,\mathrm{age}} & r_{y8,\mathrm{gender}} & r_{y8, y1} & r_{y8,y2} & r_{y8,y3} & r_{y8,y6} & r_{y8,y7} & 1 \\ \end{bmatrix} \] と,データ上の相関行列 \[ \symbf{S} = \begin{bmatrix} 1 & & & & & & & \\ 0.039 & 1 & & & & & \\ 0.156 & 0.157 & 1 & & & & \\ 0.113 & 0.184 & 0.353 & 1 & & \\ 0.064 & 0.137 & 0.274 & 0.497 & 1 & \\ 0.095 & 0.008 & -0.011 & 0.098 & 0.110 & 1 & & \\ 0.018 & 0.060 & -0.011 & 0.124 & 0.142 & 0.435 & 1 & \\ 0.065 & 0.048 & 0.024 & 0.185 & 0.126 & 0.313 & 0.359 & 1 \\ \end{bmatrix} \] がなるべく近くなるように各種パラメータを推定してあげます。

ここでいくつかの変数間のモデル上の相関係数を具体的に見てみましょう。 同じ因子に属するQ1_1とQ1_2の相関は,(検証的)因子分析のときには2項目の因子負荷の積\((b_{11}b_{21})\)という簡単な形で表すことができていました。 今回のモデルではどうでしょうか。 因子得点は内生変数として扱われており,\(f_A=b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}+\varepsilon_{A}\)という回帰式になっています。 これまでと同じようにQ1_1とQ1_2をそれぞれ外生変数(ageとgender)の関数になるまで展開してあげるならば, \[

\begin{split}

y_1 &= f_Ab_{1} + \varepsilon_{1}\\

&= (b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}+\varepsilon_{A})b_{1} + \varepsilon_{1}\\

y_2 &= f_Ab_{2} + \varepsilon_{2}\\

&= (b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}+\varepsilon_{A})b_{2} + \varepsilon_{2}

\end{split}

\tag{7.18}\] となり,これを頑張って展開して相関を求める必要がありそうです。 しかしよく考えてみると,因子分析モデルでは潜在変数の分散を1に固定する,という制約がありました。 つまり\(f_A=(b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}+\varepsilon_{A})\)の部分は,これをすべて合わせて分散1になるように調整されるということです。 したがってこの2項目の相関を求めると,結局 セクション 6.4.1 の議論 に帰着して9 \[

\begin{split}

r_{y1,y2} &= r_{(f_Ab_{1}+ \varepsilon_{1}), (f_Ab_{2}+ \varepsilon_{2})} \\

&= r_{(f_Ab_{1}),(f_Ab_{2})} \\

&= b_{1}b_{2}\left(\sigma_{f_A}\right) \\

&= b_{1}b_{2}

\end{split}

\tag{7.19}\] となるのです。 また,誤差分散\(\sigma_{\varepsilon_{A}}^2\)の値は1から回帰係数の二乗和をひいた値になっています。 このあたりの議論は,矢印の向きこそ反対ですが因子分析の時に見た「観測変数の分散は因子負荷の二乗和と独自因子の分散の和になっている」というのと同じですね。

続いて最も距離の遠いageとQ1_8の相関を見てみます。 Q1_8を外生変数(ageとgender)の関数に戻してあげると, \[

\begin{split}

y_8 &= f_Eb_{8} + \varepsilon_{8}\\

&= (b_{A}f_{A}+\varepsilon_{E})b_{8} + \varepsilon_{8}\\

&= \left(b_{A}\left[b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}+\varepsilon_{A}\right]+\varepsilon_{E}\right)b_{8} + \varepsilon_{8} \\

&= b_{A}b_{8}\left(b_{\mathrm{age}}x_{\mathrm{age}}+b_{\mathrm{gender}}x_{\mathrm{gender}}\right) + \overbrace{b_Ab_8\varepsilon_{A} + b_8\varepsilon_{E} + \varepsilon_{8}}^{\mathrm{error}}

\end{split}

\tag{7.20}\] となります。後ろの\(\varepsilon\)に関する項(\(\mathrm{error}\))は,観測変数ageとの相関はゼロなはずなので無視して分散を求めると, \[

\begin{split}

r_{\mathrm{age}, y8} &= b_Ab_8b_{\mathrm{age}}\sigma_{\mathrm{age}}^2 + b_Ab_8b_{\mathrm{gender}}\sigma_{\mathrm{age},\mathrm{gender}} \\

&= b_Ab_8b_{\mathrm{age}} + b_Ab_8b_{\mathrm{gender}}\sigma_{\mathrm{age},\mathrm{gender}}

\end{split}

\tag{7.21}\] となります。ここでもやはり

Q1_8→f_E→f_A→age(\(b_Ab_8b_{\mathrm{age}}\))Q1_8→f_E→f_A→gender→age(\(b_Ab_8b_{\mathrm{gender}}\sigma_{\mathrm{age},\mathrm{gender}}\))

という要領で,2変数間の全経路の係数の積の和の形になっていることがわかります。

モデルが複雑になっても,内部でやっていることは今までと同じであることを確認したので,実際にRで推定を行ってみましょう。

6行目(age ~~ gender)は,ageとgenderの共分散を明示的に推定するように指示しています(任意)。 書かなくても勝手にデータから計算した値を使ってくれるので,この行の有無でパラメータの推定値が変わることはないのですが,この行を書くことによって,結果の出力にデータの共分散の値を表示してくれるようになります。

lavaan 0.6-20 ended normally after 36 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 18

Number of observations 2432

Model Test User Model:

Test statistic 129.227

Degrees of freedom 18

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.602 0.031 19.255 0.000 0.628 0.447

Q1_2 0.888 0.030 29.426 0.000 0.926 0.790

Q1_3 0.786 0.030 25.796 0.000 0.819 0.627

f_E =~

Q1_6 0.728 0.031 23.767 0.000 0.753 0.611

Q1_7 0.888 0.035 25.607 0.000 0.918 0.698

Q1_8 0.651 0.031 21.262 0.000 0.673 0.523

Regressions:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A ~

age 0.014 0.002 6.275 0.000 0.013 0.147

gender 0.522 0.053 9.894 0.000 0.501 0.236

f_E ~

f_A 0.252 0.030 8.402 0.000 0.254 0.254

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

age ~~

gender 0.204 0.105 1.945 0.052 0.204 0.039

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.581 0.051 31.144 0.000 1.581 0.801

.Q1_2 0.517 0.046 11.273 0.000 0.517 0.376

.Q1_3 1.034 0.046 22.666 0.000 1.034 0.607

.Q1_6 0.950 0.043 22.240 0.000 0.950 0.626

.Q1_7 0.889 0.055 16.228 0.000 0.889 0.513

.Q1_8 1.205 0.044 27.533 0.000 1.205 0.727

age 120.254 3.449 34.871 0.000 120.254 1.000

gender 0.221 0.006 34.871 0.000 0.221 1.000

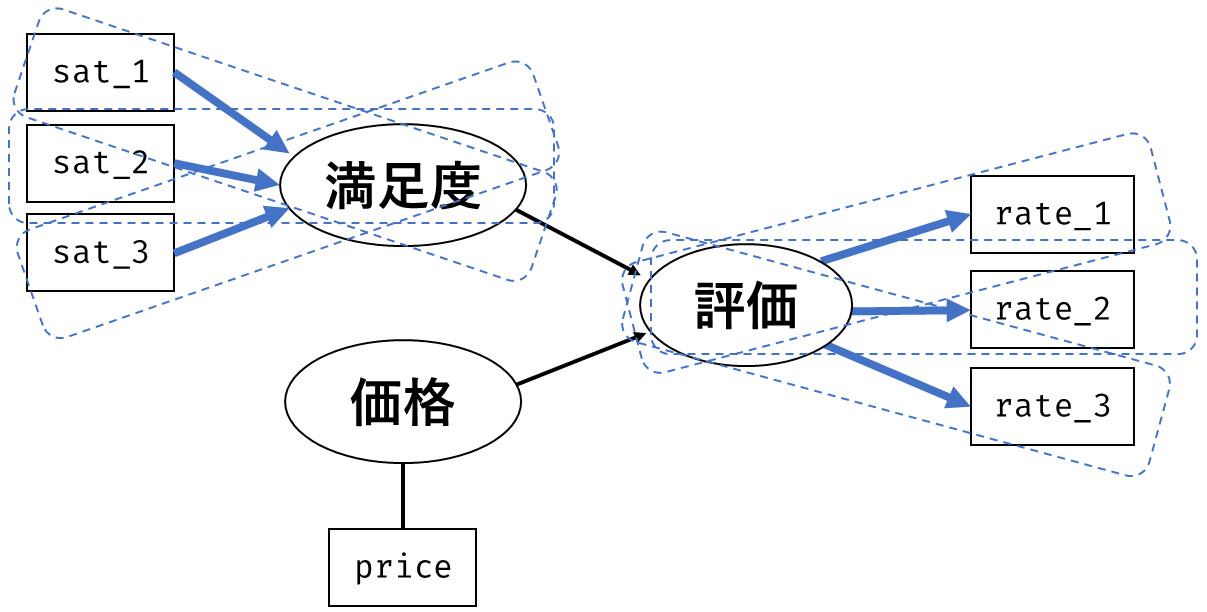

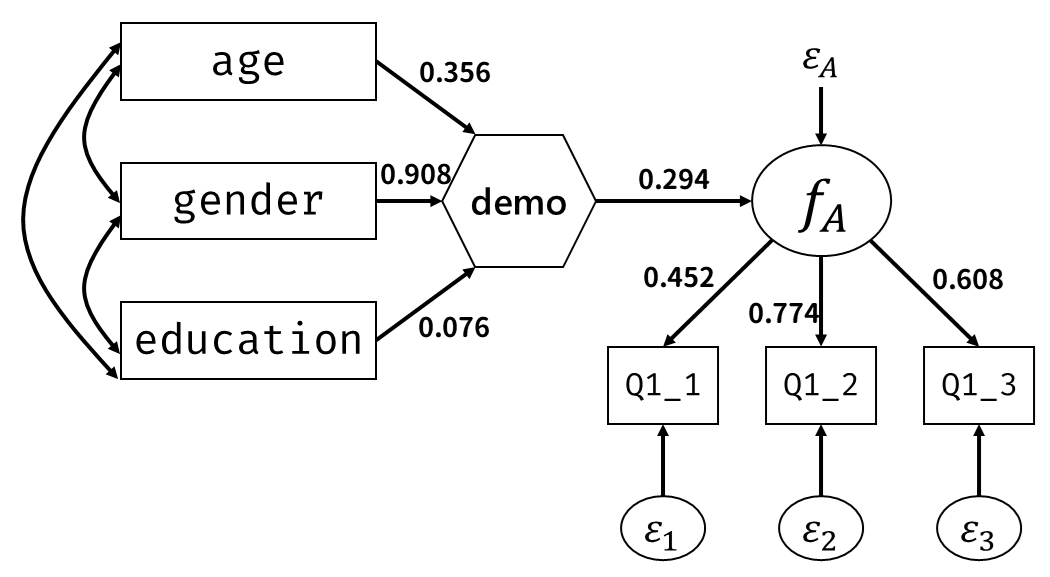

.f_A 1.000 0.920 0.920

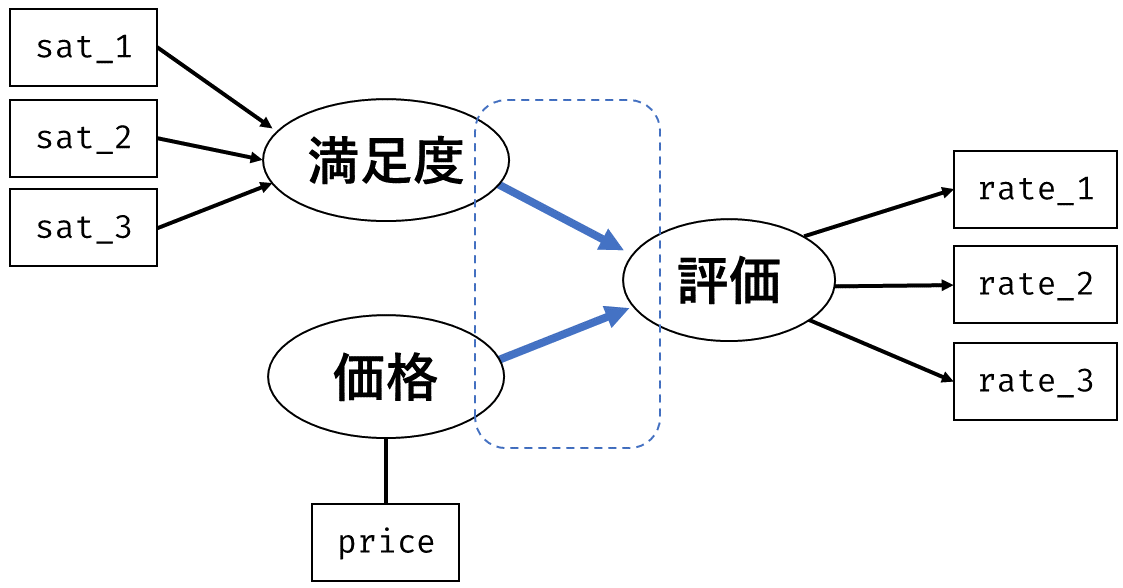

.f_E 1.000 0.935 0.935結果の見方も同じなので省略します。一応全ての標準化解を 図 7.8 に書き加えると, 図 7.9 のようになるわけです。 実際に論文などで報告する際には,全ての値を載せるとごちゃごちゃしてしまう可能性があります。 そこで,以下のような省略を行い簡潔化することがあります。 このあたりは自由というか,どういう基準で簡略化したかがハッキリわかればOKです。

- 因子分析の部分は書かない(因子だけ残す)

- 係数が一定以下のところには矢印をひかない

- 統計的に有意ではない係数のところは矢印をひかない

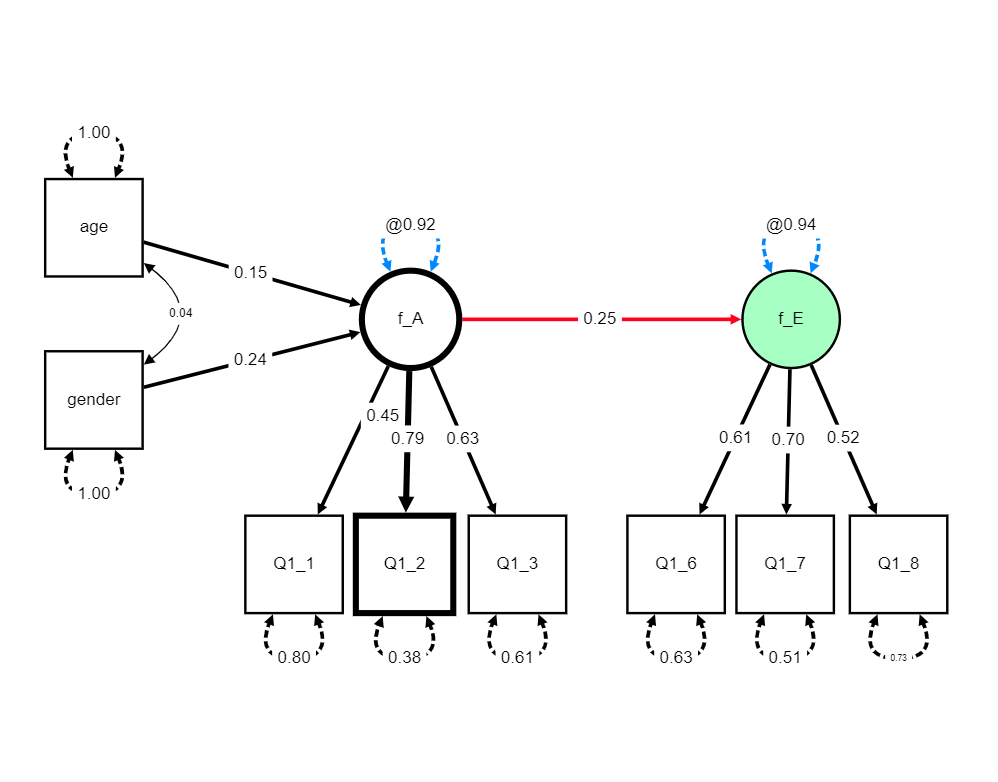

lavaanの関数(cfa()やsem())によって得られた結果のオブジェクトから,自動的にパス図を作ってくれるものとして,lavaanPlotパッケージというものが用意されています。 こういったものを利用して,自分で書いたモデルのコードが正しいものだったかをきちんと確認しておくと良いでしょう。 lavaanPlotパッケージは, 図 7.10 のように比較的そのまま論文にも載せられそうなレベルのきれいな図を書いてくれます。 ただ,見た目の点では変数名を変えたり,微妙に矢印の位置を調整したりする必要が出てくることが多いと思うので,最終的にはPowerPointやIllustratorなどを使って自分で図を作ったほうが良さそうです。

lavaanguiパッケージ

2024年9月に新しくCRANにリリースされたlavaanguiパッケージは,その名の通りGUIで操作可能な形でlavaanを利用できるパッケージです。 基本的な機能は2種類で,まず1つ目はGUIでモデル式を自動作成できる機能です。 使い方は簡単で,lavaangui()を実行するとウェブブラウザ上にGUIの画面が表示されます10。 後はマルや四角や矢印を適宜置いていくだけです。 この講義資料の上ではそこまで表示できないので,ぜひ手元で試してみてください。

2つ目の機能は,cfa()やsem()関数で推定した結果を図示する機能です。 lavaanguiパッケージの強みは,表示された図をグリグリ動かせる点です。 つまり,各変数の位置をうまく調整することで,そのまま論文に載せられるレベルの図が作れるかもしれません。

実際に弄ってみると分かりますが,各要素の色やフォントサイズなどは一つ一つ自由に変更可能です。 また,いろいろと弄った後のものをFile > Download modelで保存可能なので,あとで編集を再開するといったことも可能です。

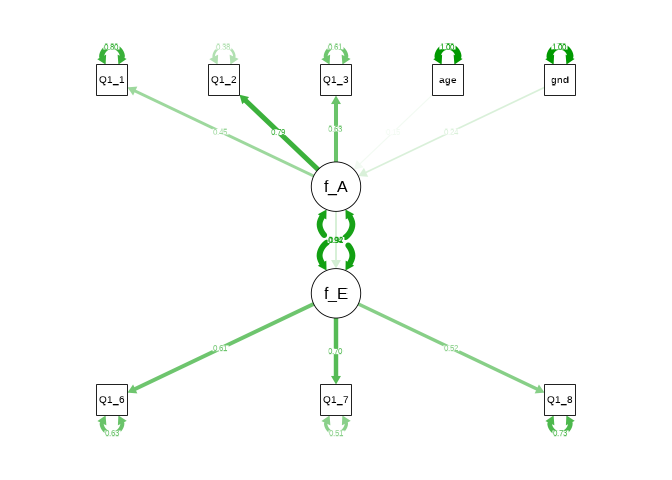

semPlotパッケージもあるよ

結果のオブジェクトから自動的にパス図を作成してくれるものとしては,semPlotパッケージにあるsemPaths()という関数もあります。 lavaanPlotと比べても,残念ながらそのまま論文に載せられるほど高性能ではないのですが,自分の書いたモデル式に間違いが無いかを確認したり,係数が一定以下のところを除外したときの図をさっと確認するのには使えると思います。

(lavaanPlotは比較的新しいパッケージでまだ挙動の変更の可能性があるので,なんかうまくいかない場合のプランBとして補足的に紹介しておきます。)

7.5.1 (おまけ)SEMモデルを一つの式で表す

ここまでに見てきたように,SEMは回帰分析と因子分析を内包する上位の概念です。 回帰分析も因子分析も,「被説明変数を説明変数の線形和で表現する」という点は変わらないので,これらがくっついたモデル( 図 7.8 )であっても,これまでと同じように線形代数を使えば一つの式で表すことができます(Adachi, 2020)。

まず,因子分析の部分(潜在変数から観測変数に矢印が引かれている部分)だけ見てみると,これは単純な2因子モデルなので, \[ \symbf{y}_p = \symbf{f}_p\symbf{B}^{(1)} + \symbf{\varepsilon}_p^{(1)} \tag{7.22}\] と表すことができます。上付きの添字\((1)\)は,因子分析パートと回帰分析パートの\(\symbf{B}\)や\(\symbf{\varepsilon}\)を区別するために便宜的につけているものです。 それぞれを展開すると, \[ \begin{split} \begin{bmatrix} y_{p1} & y_{p2} & y_{p3} & y_{p6} & y_{p7} & y_{p8} \end{bmatrix} = & \begin{bmatrix} f_{p\mathrm{A}} & f_{p\mathrm{E}} \end{bmatrix} \begin{bmatrix} b_{11} & b_{21} & b_{31} & 0 & 0 & 0 \\ 0 & 0 & 0 & b_{62} & b_{72} & b_{82} \end{bmatrix} \\ & + \begin{bmatrix} \varepsilon_{p1} & \varepsilon_{p2} & \varepsilon_{p3} & \varepsilon_{p6} & \varepsilon_{p7} & \varepsilon_{p8} \end{bmatrix} \end{split} \tag{7.23}\] となります。 同様に,回帰分析の部分は, \[ f_{p\mathrm{E}} = f_{p\mathrm{A}}b_{\mathrm{A}} + \symbf{\varepsilon}_p^{(2)} \tag{7.24}\] となります。 ここで,因子分析の表現に合わせるため,式の左辺にすべての潜在変数が登場するように少し式を書き換えます。具体的には \[ \left\{ \begin{alignedat}{2} f_{p\mathrm{A}} &= & & f_{p\mathrm{A}} \\ f_{p\mathrm{E}} &= f_{p\mathrm{A}}b_{\mathrm{A}} & + & \varepsilon_{p\mathrm{A}} \end{alignedat} \right. \tag{7.25}\] という連立方程式を用意し,これを行列によって \[ \begin{aligned} \begin{bmatrix} f_{p\mathrm{A}} & f_{p\mathrm{E}} \end{bmatrix} &= \begin{bmatrix} f_{p\mathrm{A}} & f_{p\mathrm{E}} \end{bmatrix} \begin{bmatrix} 0 & b_{\mathrm{A}} \\ 0 & 0 \end{bmatrix} + \begin{bmatrix} f_{p\mathrm{A}} & \varepsilon_{p\mathrm{A}} \end{bmatrix} \\ \longrightarrow \symbf{f}_p &= \symbf{f}_p\symbf{B}^{(2)} + \symbf{\varepsilon}_p^{(2)} \end{aligned} \tag{7.26}\] と表現します。

これで準備は完了です。あとは(7.23)式と(7.26)式をうまく組み合わせると, \[ \begin{aligned} \begin{bmatrix} \symbf{f}_p & \symbf{y}_p \end{bmatrix} &= \begin{bmatrix} \symbf{f}_p & \symbf{y}_p \end{bmatrix} \begin{bmatrix} \symbf{B}^{(1)} & \symbf{B}^{(2)} \\ \symbf{0} & \symbf{0} \end{bmatrix} + \begin{bmatrix} \symbf{\varepsilon}_p^{(1)} & \symbf{\varepsilon}_p^{(2)} \end{bmatrix} \\ \longrightarrow \symbf{v}_p &= \symbf{v}_p\symbf{B} + \symbf{\varepsilon}_p \end{aligned} \tag{7.27}\] となります。 回帰係数行列の\(\symbf{0}\)は,今回のモデルでは\(y\)から\(f\)への回帰や\(y\)同士の回帰は一つも無いため,ゼロ行列を置いています。 もしも\(y\)同士の回帰などがあれば,それに応じて係数を入れる必要があります。 とにかく,これによってすべての(観測・潜在)変数同士の回帰分析のモデルを統一的に表すことができました。

ちなみに展開すると横長になりすぎてかなり見にくいですが,一応 \[ \begin{aligned} \begin{split} & \begin{bmatrix} f_{p\mathrm{A}} & f_{p\mathrm{E}} & y_{p1} & y_{p2} & y_{p3} & y_{p6} & y_{p7} & y_{p8} \end{bmatrix} = \\ & \begin{bmatrix} f_{p\mathrm{A}} & f_{p\mathrm{E}} & y_{p1} & y_{p2} & y_{p3} & y_{p6} & y_{p7} & y_{p8} \end{bmatrix} \begin{bmatrix} 0 & b_{\mathrm{A}} & b_{11} & b_{21} & b_{31} & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & b_{62} & b_{72} & b_{82} \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 & 0 & 0 & 0 \end{bmatrix} \\ & + \begin{bmatrix} f_{p\mathrm{A}} & \varepsilon_{p\mathrm{A}} & \varepsilon_{p1} & \varepsilon_{p2} & \varepsilon_{p3} & \varepsilon_{p6} & \varepsilon_{p7} & \varepsilon_{p8} \end{bmatrix} \end{split} \end{aligned} \tag{7.28}\] という形をしています。

あとは(7.27)式を,左辺が\(\symbf{y}\)のみになるように変形していくだけです。 \((T+I)\)単位行列\(\symbf{I}_{(T+I)}\)を用いると \[ \symbf{v}_p\symbf{I}_{(T+I)} = \symbf{v}_p\symbf{B} + \symbf{\varepsilon}_p \tag{7.29}\] と表せるので,\(\symbf{v}_p\symbf{B}\)を移項させてから両辺に逆行列をかけると \[ \symbf{v}_p = \symbf{\varepsilon}_p(\symbf{I}_{(T+I)}-\symbf{B})^{-1} \tag{7.30}\] と変形させることができます。 ここで, \[ \begin{aligned} \symbf{v}_p = \begin{bmatrix} \symbf{f}_p & \symbf{y}_p \end{bmatrix} \end{aligned} \tag{7.31}\] であることを踏まえると,\(\symbf{v}_p\)のうち\(\symbf{f}_p\)に当たる部分が0になったものが\(\symbf{y}_p\)なので,\((T\times T)\)のゼロ行列\(\symbf{0}_{(T)}\)と,\((I\times I)\)の単位行列\(\symbf{I}_{(I)}\)を縦に並べた行列\(\symbf{H}\)を使って, \[ \begin{aligned} \begin{split} \symbf{y}_p &= \begin{bmatrix} \symbf{f}_p & \symbf{y}_p \end{bmatrix}\begin{bmatrix} \symbf{0}_{(T)} \\ \symbf{I}_{(I)} \end{bmatrix} \\ &= \symbf{v}_p\symbf{H} \end{split} \end{aligned} \tag{7.32}\] と表せます。 あとは,これに(7.30)式を代入することで, \[ \symbf{y}_p = \symbf{\varepsilon}_p(\symbf{I}_{(T+I)}-\symbf{B})^{-1}\symbf{H} \tag{7.33}\] という形で,どんなSEMモデルであっても,すべての観測変数をすべてのパラメータの関数で表す一般化が完成しました。

7.6 モデルの適合度

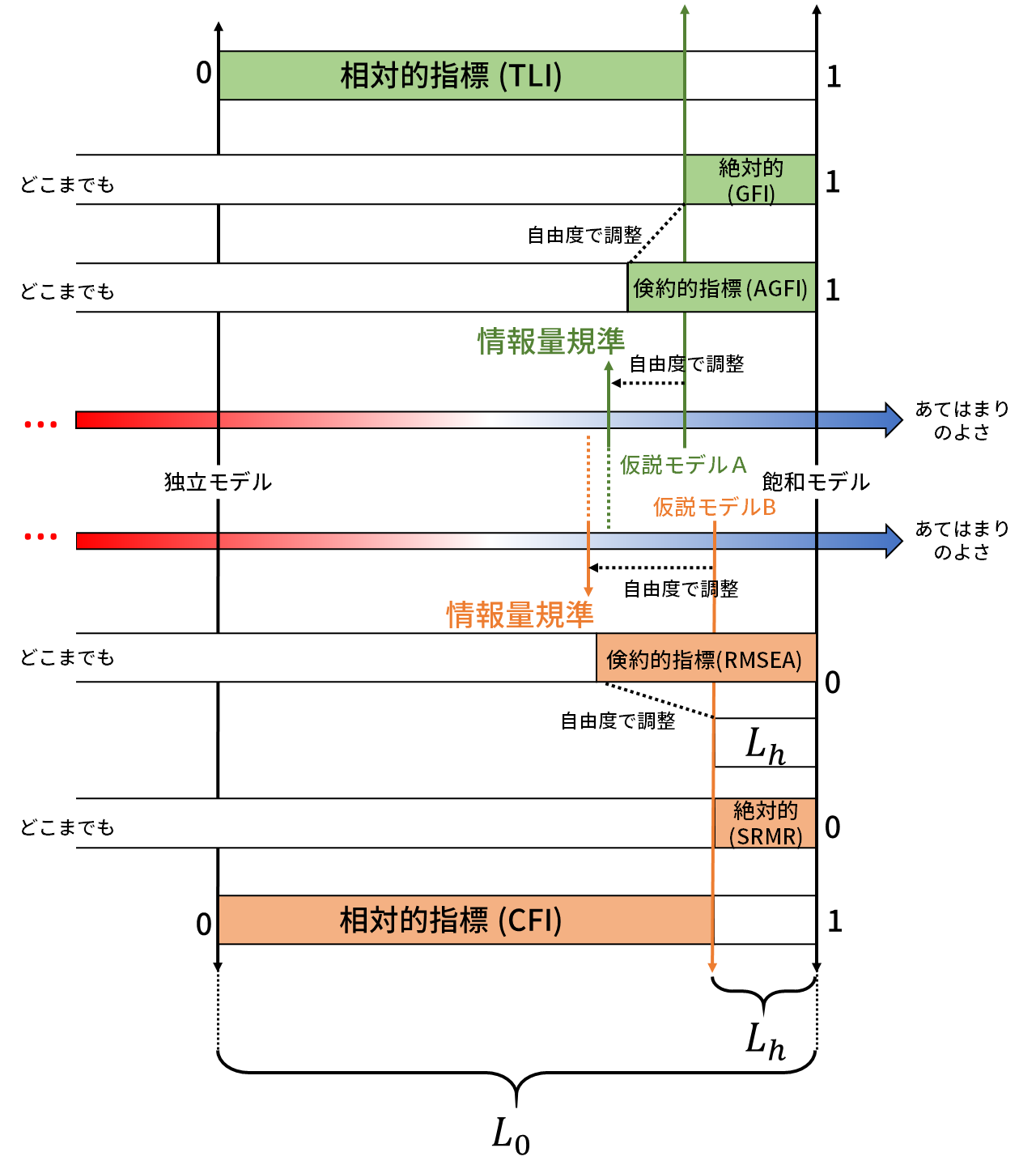

ここまで,いくつかの簡単なモデルでSEMの基本的な仕組みを紹介しました。 SEMの目的はなるべく少ないモデルパラメータによってデータの共分散行列に近い値を再現することです。 データ(の共分散行列\(\symbf{S}\))に対するモデル(の共分散行列\(\symbf{\Sigma}\))の当てはまりの程度を表す指標を(モデルの)適合度と呼び,その指標には様々な種類があります。 以下でいくつかの代表的な指標を紹介します。 これらは,どれか一つ・一種類の指標を使えばOKというものではありません。 様々な視点からの評価を行い,総合的にモデルの適合度を判定するようにしましょう。 適合度指標に関する議論は,星野 他 (2005) あたりが詳しいです。

7.6.1 相対的指標

相対的指標では,「最悪のモデル」と比べてどの程度当てはまりが改善したかを考えます。 ここでの「最悪のモデル」とは,全ての変数が完全に無相関だと仮定したモデルです。 例えば 図 7.6 のパス解析で考えると,このモデルには計4個の観測変数が登場するので,「最悪のモデル」は 図 7.11 のような状態です。

何もないということは,モデル上の相関行列\(\symbf{\Sigma}_0\)は \[ \symbf{\Sigma}_0 = \begin{bmatrix} \sigma_{x_{\mathrm{age}}}^2 & & & \\ 0 & \sigma_{x_{\mathrm{gender}}}^2 & & \\ 0 & 0 & \sigma_{x_{A}}^2 & \\ 0 & 0 & 0 & \sigma_{x_{E}}^2 \end{bmatrix} \tag{7.34}\]

ということです。もちろんこれ以上当てはまりの悪いモデルは考えられません。 ということで,相対的指標ではこの独立モデル(ヌルモデル)と比べて,設定したモデルではどの程度当てはまりが改善したかを確認します11。 ここで用いる「当てはまり」の指標は,最尤推定の場合は尤度を元に設定します。 分析者が設定した仮説モデルに関する当てはまりの指標\(L_{h}\)は \[ L_{h} = (P-1)\left\{\mathrm{tr}(\symbf{\Sigma}^{-1}\symbf{S}) - \log\vert\symbf{\Sigma}^{-1}\symbf{S}\vert - I\right\} \tag{7.35}\] となります。この式は,最尤推定量におけるモデルの尤度(波括弧の中身)を\(P-1\)倍したものなのですが,細かい式の意味や導出はともかく,この値が「データにおける観測された共分散行列\(\symbf{S}\)」と「仮説モデルの共分散行列\(\symbf{\Sigma}\)」の比(\(\symbf{\Sigma}^{-1}\symbf{S}\))に基づく値だということだけ理解しておいてください。 つまりこの値は\(\symbf{\Sigma}\)と\(\symbf{S}\)の値が近くなるほど小さな値を取る,いわば乖離度のようなものを表しています12。 そして同様に,独立モデルでの当てはまりの指標\(L_{0}\)を \[ L_{0} = (P-1)\left\{\mathrm{tr}(\symbf{\Sigma}_0^{-1}\symbf{S}) - \log\vert\symbf{\Sigma}_0^{-1}\symbf{S}\vert - I\right\} \tag{7.36}\] とします。 相対的指標では,この\(L_{h}\)と\(L_{0}\)を比較していきます。

相対的指標でよく用いられている指標の一つは,TLI (Tucker-Lewis index: Tucker & Lewis, 1973) でしょう。 \[ \mathrm{TLI} = \frac{\frac{L_{0}}{df_{0}}-\frac{L_{h}}{df_{h}}}{\frac{L_{0}}{df_{0}}-1} \tag{7.37}\] \(df_{h}\)と\(df_{0}\)はそれぞれ仮説モデルと独立モデルでの自由度です。自由度はデータの分散共分散の総数(\(\frac{I(I+1)}{2}\))からパラメータ数を引いた数になります。 例えば 図 7.6 のモデルでは,4つの観測変数から計算できる分散(\(4\)個)と共分散(\({}_4\mathrm{C}_2=6\)個)の総数10個を8つのモデルパラメータで表現しました。そのため自由度は\(df_{h}=2\)となります。 本来データの分散共分散は10個あったのに,8個だけでそれを再現したという意味では,自由度は「何個のパラメータを削減しているか」という見方もできそうです。

あらためてTLIの式を見てみます。 \(\frac{L_{0}}{df_{0}}\)は独立モデルでの乖離度です。削減したパラメータ1個につきどの程度のズレが発生したかを表しています13。 これに対して,\(\frac{L_{h}}{df_{h}}\)は仮説モデルでの乖離度です。 あってもなくても良いパラメータは削減しても大きなズレは発生しないですが,重要なパラメータを削減すると大きなズレが発生します。 ズレの大きさをパラメータ数で割ることで,「(ヌルモデルから)追加したパラメータ数の割に当てはまりが改善したか」を評価しているわけですね。

似たような指標に CFI (Comparative fit index: Bentler, 1990)があり,これもよく用いられています。 \[ \mathrm{CFI} = 1-\frac{\max(L_{h}-df_{h},0)}{\max(L_{h}-df_h,L_0-df_0,0)} \tag{7.38}\] CFIでは乖離度\(L_h\)から自由度\(df_h\)を引いています。 が,あとは大体同じです。分母の方の\(\max\)関数では,普通は最も乖離度の大きい\(L_0-df_0\)が選ばれるはずです。 そうなると \[ \mathrm{CFI}= 1- \frac{L_{h}-df_{h}}{L_0-df_0} \tag{7.39}\] となり,仮説モデルにおける当てはまりの改善度を表していることがよくわかります。

TLIやCFIは1に近いほど良い指標です。一般的には0.9くらいはほしいだの0.95あると嬉しいだの言われています。 しかし\(L_h\)は\(\symbf{\Sigma}\)と\(\symbf{S}\)のズレの大きさに規定されている以上,基本的にはパラメータ数を増やすほど値が改善していくという点には注意が必要です。

7.6.2 絶対的指標

データの相関行列\(\symbf{S}\)とモデルの相関行列\(\symbf{\Sigma}\)の要素レベルでのズレを \[ \symbf{E} = \symbf{\Sigma} - \symbf{S} \tag{7.40}\] と表すと,適合度の指標として\(\symbf{E}\)の部分がどれだけ小さいかという発想が自然に出てきます。 例えば 図 7.6 のパス解析では, \[ \begin{aligned} \symbf{E} &= \symbf{\Sigma} - \symbf{S} \\ &= \begin{bmatrix} 120.254 & & & \\ 0.204 & 0.221 & & \\ 8.902 & 0.432 & 20.685 & \\ 4.892 & 0.238 & 11.354 & 28.395 \end{bmatrix} - \begin{bmatrix} 120.254 & & & \\ 0.204 & 0.221 & & \\ 8.906 & 0.433 & 20.667 & \\ 4.198 & 0.260 & 11.359 & 28.407 \end{bmatrix} \\ &= \begin{bmatrix} 0 & & & \\ 0 & 0 & & \\ -0.004 & -0.001 & 0.018 & \\ 0.694 & -0.022 & -0.005 & -0.012 \end{bmatrix} \end{aligned} \] という関係になっています。 ここから適合度を単純に考えると,例えば\(\symbf{E}\)の成分の平均のようなものを計算すると良さそうです。 この指標を RMR (root mean-squared residual) と呼び,式としては \[ \mathrm{RMR} = \sqrt{\frac{2}{I(I-1)}\sum_{i=1}^{I}\sum_{j=1}^{I}(\sigma_{ij}-s_{ij})^2} \tag{7.41}\] と表されます。ここで\(\sigma_{ij}, s_{ij}\)はそれぞれ\(\symbf{\Sigma}, \symbf{S}\)の\((i,j)\)成分の値を意味しています。 しかし,RMRは変数のスケールの影響を受けてしまいます。 例えば全ての変数の値を10倍(=分散は100倍)にしたとしたら,\(\symbf{S}\)と\(\symbf{\Sigma}\)の各要素の値は単純に100倍されてしまうため,\(\symbf{E}\)の平均であるRMRも100倍になってしまいます。

これでは基準を決められないので,RMRを標準化することで生まれたのが SRMR (standardized RMR: Hu & Bentler, 1999)です。 標準化の仕方は,「共分散から相関係数を導出する時」と同様にすることで, \[ \mathrm{SRMR} = \sqrt{\frac{2}{I(I-1)}\sum_{i=1}^{I}\sum_{j=1}^{I}\left(\frac{\sigma_{ij}-s_{ij}}{s_{ii}s_{jj}}\right)^2} \tag{7.42}\] と定式化されます。

SRMRの他にもよく使われる指標としては,GFI (Goodness of fit index: Bentler, 1983)があります。これも基本的な考え方は同じで,\(\symbf{S}\)と\(\symbf{\Sigma}\)の各要素の値が近いほど良くなります。 \[ \begin{aligned} \mathrm{GFI} &= 1-\frac{tr\left[\left(\symbf{S}-\symbf{\Sigma}\right)^2\right]}{tr[\symbf{S}^2]} \\ &= 1-\frac{\sum_{i=1}^{I}\sum_{j=1}^{i}(s_{ij}-\sigma_{ij})^2}{\sum_{i=1}^{I}\sum_{j=1}^{i}s_{ij}^2} \end{aligned} \tag{7.43}\]

SRMRやGFIは,回帰分析の決定係数や因子分析の分散説明率のようなもので,パラメータの数が多いほど値は改善していきます。 因子分析の分散説明率では「最低限これくらいは欲しい」といった考え方を紹介しました。 その観点ではこれらの指標は役に立ちます。 例えばSRMRでは0.08や0.05以下くらいだと良いと言われていたり,GFIや後述するAGFIは0.95以上だと良いと言われていたりします(Hancock et al., 2019; 豊田,2014)。 ですがSEMの目的は「なるべく少ないパラメータで」達成したいところです。 そう考えると,これらの指標だけを用いていると少し問題があるわけです。

ちなみに,GFIには自由度で調整したAGFI(Adjusted GFI)というものがあります。 \[ \mathrm{AGFI} = 1-\frac{I(I+1)}{2}\frac{1}{df}(1-\mathrm{GFI}) \tag{7.44}\] これは,自由度調整済み決定係数のような感じで,推定するパラメータ数が多くなるほど相関行列の乖離度\((1-\mathrm{GFI})\)を過大評価するような調整がされているわけです。

7.6.3 倹約的指標

データへの当てはまりは良いほど嬉しいのですが,「なるべく少ないパラメータで」を満たすために,先ほど紹介したAGFIのように推定するパラメータ数を考慮した適合度指標を考えます。 このクラスで多分最もよく用いられているのが RMSEA (Root Mean Square error of approximation: Steiger & Lind, 1980)です。 \[ \mathrm{RMSEA} = \sqrt{\max\left(\frac{L_h}{df_h} - \frac{1}{P-1},0\right)} \tag{7.45}\] TLIのところでも登場した\(\frac{L_{h}}{df_{h}}\)は「削減したパラメータ1個あたりの乖離度の大きさ」の指標です。 したがって,乖離度\(L_h\)が同じであれば,パラメータ数が少ない=自由度が大きいほど良い値になります。 RMSEAに関しては,0.05を下回っていると良いとか,90%信頼区間が0.1を含まないと良いなどと言われています。

倹約的指標には,他にもPGFI (parsimonious GFI: Mulaik et al., 1989)といったものもあります。 \[ \mathrm{PGFI} = \frac{df_h}{\frac{I(I-1)}{2}}\mathrm{GFI} \tag{7.46}\] ただ,PGFIはシンプルなモデルでは変動が大きすぎることがあります。 例えば 図 7.6 のモデルでは,10個の分散共分散を8個のパラメータで説明していましたが,この場合\(PGFI=\frac{2}{10}GFI\)となり,GFIの5分の1になってしまいます。 独立モデルだったとしても各変数の分散パラメータは必ず存在しているため,\(PGFI=\frac{6}{10}GFI\)となります。 ということで,PGFIと同様の補正がかかる倹約的指標では,どの程度の値なら十分かを明確に決めづらいためあまり使われることはない印象があります。

7.6.4 モデル比較の指標

適合度指標とは少し異なりますが,パラメータ数の割に当てはまりの良いモデルを選ぶための指標として情報量規準というものがあります。 代表的な情報量規準には \[ \begin{aligned} \mathrm{AIC} &= L_h - 2df_h \\ \mathrm{BIC} &= L_h - \log(P)df_h \end{aligned} \tag{7.47}\] などがあります (Akaike, 1969/1998–1969; Schwarz, 1978)。式からわかるように,パラメータ数が多くなるほど第2項の値が小さくなり,結果的に情報量規準の値が大きくなってしまいます。

情報量規準には絶対的な基準はありません。単体のモデルに対する値を見て一喜一憂するものではなく,複数のモデルにおける値を比較してより小さい方を選ぶためのものです。

一般的に,乖離度\(L_h\)はサンプルサイズが大きくなるほど大きな値になりやすいものです。 AICではパラメータを1つ追加した際のペナルティがサンプルサイズによらず2のため,サンプルサイズが大きくなるほど「パラメータを追加したことによる当てはまりの改善」のほうが「パラメータを追加したことによるペナルティ」よりも大きくなりやすく,結果的にパラメータ数の多いモデルを選びやすくなる,という性質があったりします。 また2つのモデルでの値の差がわずかな場合には,標本誤差によって大小関係が変わりうるため,単一の情報量規準だけを用いてモデルを選択するのは危険なときがあるかもしれません。 少しだけ注意しましょう。

7.6.5 確認してみよう

それでは,これまでに紹介したものを含めた様々な適合度指標をlavaanで出してみましょう。 fitmeasures()関数を使うと簡単に出すことが出来ます14。

npar fmin chisq

18.000 0.027 129.227

df pvalue baseline.chisq

18.000 0.000 2331.678

baseline.df baseline.pvalue cfi

28.000 0.000 0.952

tli nnfi rfi

0.925 0.925 0.914

nfi pnfi ifi

0.945 0.607 0.952

rni logl unrestricted.logl

0.952 -34146.289 -34081.676

aic bic ntotal

68328.579 68432.915 2432.000

bic2 rmsea rmsea.ci.lower

68375.725 0.050 0.042

rmsea.ci.upper rmsea.ci.level rmsea.pvalue

0.059 0.900 0.450

rmsea.close.h0 rmsea.notclose.pvalue rmsea.notclose.h0

0.050 0.000 0.080

rmr rmr_nomean srmr

0.308 0.308 0.036

srmr_bentler srmr_bentler_nomean crmr

0.036 0.036 0.041

crmr_nomean srmr_mplus srmr_mplus_nomean

0.041 0.036 0.036

cn_05 cn_01 gfi

544.308 656.021 0.987

agfi pgfi mfi

0.974 0.494 0.977

ecvi

0.068 これまでに紹介したもの以外にも色々出ていますが,とりあえず先ほど紹介したものに関する指標だけ説明すると

fitmeasures()関数で表示される適合度指標の一部

| 指標名 | 解説 |

|---|---|

chisq |

\(\chi^2\)統計量(\(L_h\)) |

df |

自由度(\(df_h\)) |

pvalue |

\(\chi^2\)検定の\(p\)値 |

baseline.*** |

独立モデルでの値(\(L_0,df_0\)) |

cfi |

CFI |

aic |

AIC |

bic |

BIC |

rmsea |

RMSEA |

rmsea.ci.lower |

RMSEAの90%信頼区間の下限 |

rmsea.ci.upper |

RMSEAの90%信頼区間の上限 |

rmsea.pvalue |

「RMSEAが0.05以下」という帰無仮説に対する\(p\)値 |

srmr |

SRMR |

gfi |

GFI |

agfi |

AGFI |

pgfi |

PGFI |

といった感じです。

では実際に複数のモデルを比較して,各適合度指標の挙動を確認してみましょう。 ここでは,「正しい」モデルとして 図 7.3 の「本来の2因子モデル」を例として,これに「余計な矢印が入った2因子モデル」(「正しくない」モデル)と比較してみましょう。 まずは2つのモデルそれぞれについてパラメータ推定を行います。

続いて2つのモデルの適合度を比較していきましょう。 とはいえ,一つ一つfitmeasures()して出力を見比べるのは大変なので,複数のモデルの適合度を並べてくれるsemTools::compareFit()という関数を使ってみます。

semTools::compareFit(): 複数のモデルの適合度を比較する

################### Nested Model Comparison #########################

Chi-Squared Difference Test

Df AIC BIC Chisq Chisq diff RMSEA Df diff Pr(>Chisq)

result2 7 46682 46764 57.197

result1 8 46685 46761 62.062 4.8642 0.039861 1 0.02742 *

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

####################### Model Fit Indices ###########################

chisq df pvalue rmsea cfi tli srmr aic

result2 57.197† 7 .000 .054 .976† .949 .033† 46682.454†

result1 62.061 8 .000 .053† .974 .952† .035 46685.319

bic

result2 46763.605

result1 46760.673†

################## Differences in Fit Indices #######################

df rmsea cfi tli srmr aic bic

result1 - result2 1 -0.002 -0.002 0.003 0.002 2.864 -2.932最初のNested Model Comparisonというところは,ネストされたモデル間での比較です。 今回の例の場合,result1のモデルは,result2のモデルでf_1 =~ Q1_6の値が0になった場合という意味で,result2の特殊なケースといえます。 このように,あるモデルが別のモデルに内包されているとき,そのモデルは「ネスト」の関係にあると呼んだりします。

ネストされたたモデル間の比較では,尤度比検定を行うことができます。 ネストされたモデルでは,パラメータ数の減少に伴い少なからずデータに対する当てはまりが悪化(尤度が減少)しているはずですが,もしも尤度比検定が有意にならない場合,その当てはまりの悪化が「減らしたパラメータ数的に許容できる」という感じになり,それならばより節約的なモデルを選ぼう,という流れになります。 今回の場合,Pr(>Chisq)が0.05より小さいため検定は有意になっています。 result2を基準に見るとresult1のモデルはf_1 =~ Q1_6のパスを0にしたことによって当てはまりが有意に悪化している,ということです。 したがって,尤度比検定的にはresult2を選ぶべし,となります。 しかしこれも例によって統計的仮説検定あるあるの「サンプルサイズが大きいと有意になりやすい」があるので,これだけを信じすぎないほうが良いと思います。

その下のModel Fit Indicesでは各種適合度指標を並べてくれています。ダガー(†)の付いているものは,その適合度指標においてベストなモデル,という意味です。 また一番下のDifferences in Fit Indicesは読んで字のごとく適合度指標の差分です。 僅かな差ですが,RMSEAやTLIの値はf_1 =~ Q1_6のパスが無い(本来正しい)モデルの方が良い値です。 一方で絶対的指標であるCFIやSRMRはresult2のほうが良い値になっています。

情報量規準を見ると,AICはモデル2,BICはモデル1のほうが大きな値になっています。 先程説明したように,AICのほうがサンプルサイズが大きくなるほど複雑な(パラメータ数の多い)モデルを好む傾向があり,今回の比較でもその傾向が表れたということです。

このように,適合度指標の定義によってモデル比較の結果も一貫しないことが大半なので,結果を報告する際には複数の指標を提示し,総合的に判断する必要があるわけです。

compareFit()関数は,デフォルトでは上に表示されているいくつかの指標のみを表示する様になっています。 このSectionで紹介した他の適合度指標についても比較してほしい場合には,引数を設定する必要があります。

################### Nested Model Comparison #########################

Chi-Squared Difference Test

Df AIC BIC Chisq Chisq diff RMSEA Df diff Pr(>Chisq)

result2 7 46682 46764 57.197

result1 8 46685 46761 62.062 4.8642 0.039861 1 0.02742 *

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

####################### Model Fit Indices ###########################

gfi agfi rmsea.pvalue

result2 .992† .977 .271†

result1 .992 .978† .333

################## Differences in Fit Indices #######################

gfi agfi

result1 - result2 -0.001 0.001引数fit.measuresに指定できるのは,fitmeasures()関数で表示されるものの名前です。 そして実はfitmeasures()関数自体も同じ引数fit.measuresを受け付けるので,同様に一部の指標のみを表示したい場合には設定してあげると良いでしょう。

図 7.12 に,各種適合度指標の関係を表してみました。無理やり1つの図にまとめたので多少変なところがあるかもしれませんが…

- 相対的指標は「独立モデルを0,飽和モデルを1」としたときの仮説モデルの位置づけを表しています。

- 絶対的指標は「飽和モデル=データ」からのズレを表す指標です。理論上はたぶん下限は決まっていませんが,基本的に0から1の範囲内に収まるはずです。

- 倹約的指標はものによります。自由度で調整した値です。

- 情報量規準は独立モデル・飽和モデルと何の関係もありません。尤度を自由度で調整しただけです。図の例では,モデルBのほうが絶対的な当てはまりは良いのですが,自由度による調整の結果情報量規準の値はモデルAのほうが良い,という状態を表しています。

7.7 モデルの修正

(ここからはプラクティカルな話題です。)

SEMでは,まずドメイン知識に基づいた仮説を立てて,その仮説をモデルを落とし込んでいく(パス図に線を引く)ことになります。 そして,実際のデータと仮説モデルとで共分散行列がどの程度ずれているかを評価し,ズレが小さければ「問題ないモデル」と判断します。 ズレの大きさを評価する適合度指標には,大きく分けると「絶対的なズレの大きさを評価するもの(SRMRやGFIなど)」と「パラメータ数(自由度)を考慮して評価するもの(AGFIやRMSEA)」の2種類がありました。

もしも仮説モデルにおいて適合度指標の値が悪ければ,モデルを修正してデータとの整合性 and/or モデルの倹約度を高める必要があります。 データとの整合性を高めるためには,矢印を追加してあげれば良いです。 矢印を追加するということは推定するパラメータが増えるため,回帰分析の説明変数や因子分析の因子数を増やした時と同じように,パラメータを増やした分だけデータとモデルのズレは小さくできるはずです。 一方,モデルの倹約度を高めるためには矢印を消去する必要もあります。ある矢印が,あってもなくてもデータとモデルのズレに大きな影響を与えないのであれば,そのような矢印はなくなったほうがRMSEAなどは向上するはずです。

ということで,この節ではモデルを修正してデータとの整合性を高めるための方法について説明します。 手当たり次第にひとつひとつ矢印を足したり引いたりしたモデルを試しまくるのはさすがに効率が悪いので,もう少しスマートに修正案にアタリをつけたいと思います。 以降では, 図 7.8 のSEMモデルを題材にモデルの修正を試してみます。

lavaan 0.6-20 ended normally after 36 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 18

Number of observations 2432

Model Test User Model:

Test statistic 129.227

Degrees of freedom 18

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.602 0.031 19.255 0.000 0.628 0.447

Q1_2 0.888 0.030 29.426 0.000 0.926 0.790

Q1_3 0.786 0.030 25.796 0.000 0.819 0.627

f_E =~

Q1_6 0.728 0.031 23.767 0.000 0.753 0.611

Q1_7 0.888 0.035 25.607 0.000 0.918 0.698

Q1_8 0.651 0.031 21.262 0.000 0.673 0.523

Regressions:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A ~

age 0.014 0.002 6.275 0.000 0.013 0.147

gender 0.522 0.053 9.894 0.000 0.501 0.236

f_E ~

f_A 0.252 0.030 8.402 0.000 0.254 0.254

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

age ~~

gender 0.204 0.105 1.945 0.052 0.204 0.039

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.581 0.051 31.144 0.000 1.581 0.801

.Q1_2 0.517 0.046 11.273 0.000 0.517 0.376

.Q1_3 1.034 0.046 22.666 0.000 1.034 0.607

.Q1_6 0.950 0.043 22.240 0.000 0.950 0.626

.Q1_7 0.889 0.055 16.228 0.000 0.889 0.513

.Q1_8 1.205 0.044 27.533 0.000 1.205 0.727

age 120.254 3.449 34.871 0.000 120.254 1.000

gender 0.221 0.006 34.871 0.000 0.221 1.000

.f_A 1.000 0.920 0.920

.f_E 1.000 0.935 0.935 npar fmin chisq

18.000 0.027 129.227

df pvalue baseline.chisq

18.000 0.000 2331.678

baseline.df baseline.pvalue cfi

28.000 0.000 0.952

tli nnfi rfi

0.925 0.925 0.914

nfi pnfi ifi

0.945 0.607 0.952

rni logl unrestricted.logl

0.952 -34146.289 -34081.676

aic bic ntotal

68328.579 68432.915 2432.000

bic2 rmsea rmsea.ci.lower

68375.725 0.050 0.042

rmsea.ci.upper rmsea.ci.level rmsea.pvalue

0.059 0.900 0.450

rmsea.close.h0 rmsea.notclose.pvalue rmsea.notclose.h0

0.050 0.000 0.080

rmr rmr_nomean srmr

0.308 0.308 0.036

srmr_bentler srmr_bentler_nomean crmr

0.036 0.036 0.041

crmr_nomean srmr_mplus srmr_mplus_nomean

0.041 0.036 0.036

cn_05 cn_01 gfi

544.308 656.021 0.987

agfi pgfi mfi

0.974 0.494 0.977

ecvi

0.068 7.7.1 不要なパスを消す

普通に考えると年齢ageと性別genderは無相関だと考えるのが自然ですね。 先程の分析の結果を見ても,共分散age ~~ genderの検定結果は有意にはなっていません。 summary(sem())で出力される検定では,帰無仮説に「そのパラメータの母数が0に等しい」を設定したWald検定の結果を出しています。 Wald検定の中身はともかく,とりあえずこのP(>|z|)列を見れば,そのパラメータを削除してよいかにアタリをつけられそうかが分かります。

ということで,検定結果が有意ではなかったage ~~ genderの共分散をゼロに固定して再度推定してみましょう。

lavaanの記法では,このように右辺の変数名の前に0*を付けると,そのパラメータの値を0に固定することが出来ます15。

lavaan 0.6-20 ended normally after 30 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 17

Number of observations 2432

Model Test User Model:

Test statistic 133.020

Degrees of freedom 19

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.602 0.031 19.216 0.000 0.627 0.446

Q1_2 0.888 0.030 29.335 0.000 0.925 0.789

Q1_3 0.786 0.031 25.715 0.000 0.818 0.627

f_E =~

Q1_6 0.728 0.031 23.763 0.000 0.753 0.611

Q1_7 0.888 0.035 25.602 0.000 0.918 0.698

Q1_8 0.651 0.031 21.259 0.000 0.673 0.523

Regressions:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A ~

age 0.014 0.002 6.280 0.000 0.013 0.147

gender 0.522 0.053 9.901 0.000 0.502 0.236

f_E ~

f_A 0.252 0.030 8.387 0.000 0.254 0.254

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

age ~~

gender 0.000 0.000 0.000

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.581 0.051 31.136 0.000 1.581 0.801

.Q1_2 0.517 0.046 11.237 0.000 0.517 0.377

.Q1_3 1.034 0.046 22.625 0.000 1.034 0.607

.Q1_6 0.950 0.043 22.238 0.000 0.950 0.626

.Q1_7 0.889 0.055 16.225 0.000 0.889 0.513

.Q1_8 1.205 0.044 27.532 0.000 1.205 0.727

age 120.254 3.449 34.871 0.000 120.254 1.000

gender 0.221 0.006 34.871 0.000 0.221 1.000

.f_A 1.000 0.923 0.923

.f_E 1.000 0.936 0.936結果を見ると,確かに共分散age ~~ genderの値が推定されず,0に固定されています。 それでは,パス削除前(result1)と削除後(result2)の適合度を比較してみましょう。

################### Nested Model Comparison #########################

Chi-Squared Difference Test

Df AIC BIC Chisq Chisq diff RMSEA Df diff Pr(>Chisq)

result1 18 68329 68433 129.23

result2 19 68330 68429 133.02 3.7929 0.033888 1 0.05147 .

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

####################### Model Fit Indices ###########################

chisq df pvalue rmsea cfi tli srmr aic

result1 129.227† 18 .000 .050 .952† .925 .036† 68328.579†

result2 133.020 19 .000 .050† .951 .927† .037 68330.371

bic

result1 68432.915

result2 68428.911†

################## Differences in Fit Indices #######################

df rmsea cfi tli srmr aic bic

result2 - result1 1 -0.001 -0.001 0.002 0.001 1.793 -4.004いま比較している2つのモデルのうちresult2のモデルは,result1のモデルでage ~~ genderの値が0になった場合という意味で,result1の特殊なケースといえます。 ということで尤度比検定の結果が出力されています。 今回の場合,Pr(>Chisq)が0.05より大きいため検定は(ギリギリ)有意になっていません。 したがって,尤度比検定的にはパラメータを1つ削除しても当てはまりは有意には悪化していない,そのためより節約的なresult2を選ぼう,ということになるわけです。

続いて各種適合度指標を見ると,僅かな差ですが,RMSEAやTLIの値は改善しているようです。 一方で絶対的指標であるSRMRは悪化しているようですね。

このように,単一のパスを削除する場合には,cfa()やsem()の結果の検定のところを見るのが第一歩です。 ですが,統計的仮説検定の枠組みの中にあるため,サンプルサイズの影響を受けてしまう点は注意が必要です。 例えば先程の分析を,サンプルサイズを100人にして行うと,さっきは有意だったf_A ~ ageの回帰係数も有意ではなくなってしまいます。 検定の結果だけを鵜呑みにするのではなく,例えば実際の推定値の大きさを踏まえて決定するなどの対応が必要でしょう。

lavaan 0.6-20 ended normally after 35 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 18

Number of observations 100

Model Test User Model:

Test statistic 29.972

Degrees of freedom 18

P-value (Chi-square) 0.038

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.535 0.151 3.540 0.000 0.576 0.394

Q1_2 0.926 0.147 6.301 0.000 0.996 0.857

Q1_3 0.674 0.141 4.781 0.000 0.725 0.537

f_E =~

Q1_6 0.764 0.126 6.085 0.000 0.840 0.679

Q1_7 0.829 0.135 6.163 0.000 0.911 0.690

Q1_8 0.822 0.132 6.222 0.000 0.904 0.698

Regressions:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A ~

age 0.011 0.010 1.050 0.294 0.010 0.115

gender 0.720 0.254 2.830 0.005 0.669 0.330

f_E ~

f_A 0.424 0.148 2.874 0.004 0.415 0.415

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

age ~~

gender 1.028 0.580 1.772 0.076 1.028 0.180

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.801 0.273 6.606 0.000 1.801 0.844

.Q1_2 0.360 0.234 1.535 0.125 0.360 0.266

.Q1_3 1.296 0.225 5.769 0.000 1.296 0.711

.Q1_6 0.823 0.172 4.788 0.000 0.823 0.539

.Q1_7 0.915 0.197 4.647 0.000 0.915 0.524

.Q1_8 0.860 0.190 4.533 0.000 0.860 0.513

age 133.886 18.934 7.071 0.000 133.886 1.000

gender 0.244 0.034 7.071 0.000 0.244 1.000

.f_A 1.000 0.864 0.864

.f_E 1.000 0.828 0.8287.7.2 新しいパスを増やす

続いて,新しいパスを追加することを考えたいと思います。 パスを追加する場合,基本的に絶対的な適合度は上昇するため,先程の尤度比検定の考え方とは反対に「パラメータを1個追加する価値があるだけの適合度の改善が見られる」ようなパラメータは追加してあげればよいわけです。 modificationIndices()という関数は,現状モデル内でパラメータが自由推定になっていない全てのパス16について,「そこにパスを追加するとどれだけ適合度が改善するか」をまとめて表してくれます。

lhs op rhs mi epc sepc.lv sepc.all sepc.nox

24 f_E =~ Q1_1 33.281 -0.196 -0.203 -0.144 -0.144

32 Q1_1 ~~ age 25.661 1.519 1.519 0.110 0.110

37 Q1_2 ~~ Q1_8 23.532 0.114 0.114 0.145 0.145

45 Q1_6 ~~ Q1_7 19.848 0.527 0.527 0.574 0.574

23 f_A =~ Q1_8 19.845 0.134 0.139 0.108 0.108

47 Q1_6 ~~ age 13.741 0.902 0.902 0.084 0.084

30 Q1_1 ~~ Q1_7 9.220 -0.092 -0.092 -0.078 -0.078

33 Q1_1 ~~ gender 9.153 0.040 0.040 0.068 0.068

26 f_E =~ Q1_3 7.717 0.087 0.089 0.069 0.069

43 Q1_3 ~~ age 6.496 -0.690 -0.690 -0.062 -0.062

50 Q1_7 ~~ age 6.371 -0.645 -0.645 -0.062 -0.062

41 Q1_3 ~~ Q1_7 5.463 0.062 0.062 0.065 0.065

[ reached 'max' / getOption("max.print") -- omitted 32 rows ]引数sort = TRUEを与えると,改善度(出力の一番左,mi列)の大きい順に並べてくれます。 したがって今回の場合,一つだけパスを追加するならばf_E =~ Q1_1というパスを追加すると適合度が最も改善する,ということです。 出力ではmi列に続いて,

epc- そのパスを自由推定にした際のパラメータの変化量の予測値。パスが引かれていない場合は「0からの変化量」なので推定値そのものの予測値を意味する。

sepc.lv-

潜在変数

lvを標準化した際のEPC (standardized EPC)。 sepc.all- 全ての変数を標準化した際(標準化解)のEPC。

sepc.nox- 観測変数の外生変数以外を全て標準化した際のEPC。

が表示されています。きっと多くの場合ではmiが大きいところはsepc.allが大きくなっていることでしょう。 ということで,パスを追加する際にはmiが大きいほうから試してみると良いでしょう。 さっそくf_E =~ Q1_1を追加して推定してみます。

lavaan 0.6-20 ended normally after 31 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 18

Number of observations 2432

Model Test User Model:

Test statistic 98.800

Degrees of freedom 18

P-value (Chi-square) 0.000

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.678 0.034 19.682 0.000 0.707 0.503

Q1_2 0.867 0.029 29.957 0.000 0.904 0.772

Q1_3 0.792 0.030 26.483 0.000 0.826 0.633

f_E =~

Q1_6 0.720 0.030 23.860 0.000 0.752 0.610

Q1_7 0.879 0.034 25.758 0.000 0.918 0.698

Q1_8 0.647 0.030 21.333 0.000 0.675 0.524

Q1_1 -0.201 0.034 -5.875 0.000 -0.210 -0.149

Regressions:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A ~

age 0.014 0.002 6.466 0.000 0.014 0.152

gender 0.529 0.053 9.982 0.000 0.507 0.238

f_E ~

f_A 0.287 0.031 9.131 0.000 0.287 0.287

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

age ~~

gender 0.000 0.000 0.000

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.514 0.052 29.360 0.000 1.514 0.767

.Q1_2 0.555 0.042 13.069 0.000 0.555 0.404

.Q1_3 1.021 0.044 23.011 0.000 1.021 0.600

.Q1_6 0.952 0.042 22.594 0.000 0.952 0.628

.Q1_7 0.889 0.054 16.558 0.000 0.889 0.513

.Q1_8 1.202 0.044 27.589 0.000 1.202 0.725

age 120.254 3.449 34.871 0.000 120.254 1.000

gender 0.221 0.006 34.871 0.000 0.221 1.000

.f_A 1.000 0.920 0.920

.f_E 1.000 0.918 0.918パス追加前(result2)と追加後(result3)の適合度を比較してみましょう。

################### Nested Model Comparison #########################

Chi-Squared Difference Test

Df AIC BIC Chisq Chisq diff RMSEA Df diff Pr(>Chisq)

result3 18 68298 68402 98.80

result2 19 68330 68429 133.02 34.22 0.11688 1 4.921e-09 ***

---

Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

####################### Model Fit Indices ###########################

chisq df pvalue rmsea cfi tli srmr aic

result3 98.800† 18 .000 .043† .965† .945† .029† 68298.151†

result2 133.020 19 .000 .050 .951 .927 .037 68330.371

bic

result3 68402.488†

result2 68428.911

################## Differences in Fit Indices #######################

df rmsea cfi tli srmr aic bic

result2 - result3 1 0.007 -0.014 -0.018 0.008 32.22 26.424尤度比検定の結果は有意になっています。今回はresult2のほうが節約的なモデルなので,パス追加前(result2)の方が当てはまりが有意に悪い,ということになりました。 ほかの適合度指標を見ても,どうやら確かに追加したあとの方が改善しているようです。

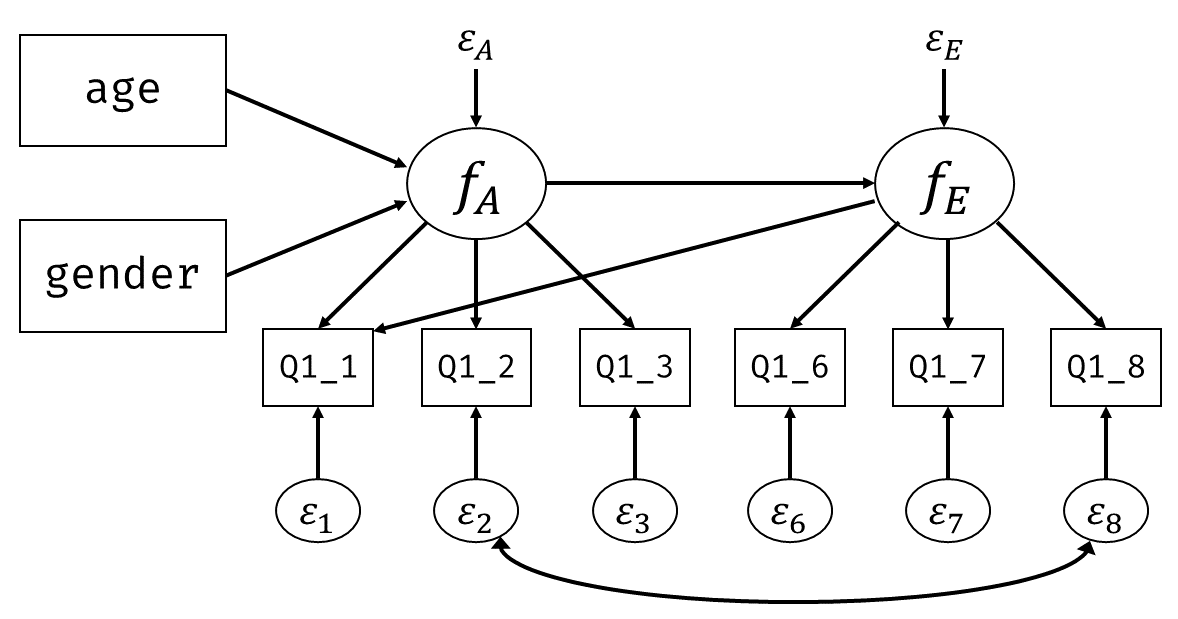

7.7.3 実際のところ

ここまで,モデルを修正するための候補を統計的な視点から紹介しました。 しかしSEMで重要なのは,因子分析と同じようにその結果をきちんと解釈できるか(解釈可能性)です。 実際にモデルを修正するかどうかは,そのパスが持つ意味をよく考えて行う必要があります。 先程の修正では,f_E =~ Q1_1を追加したことによって 図 7.13 のような状態になりました。 つまり完全な単純構造ではないと考えたほうがデータ的には当てはまりが良い,ということです。 ですが修正指標(mi)も,尤度に基づく指標です。つまりサンプルサイズが大きいほど当てはまりは大幅に改善するように見えてしまいます。 したがって,本質的には無意味なパスが手元のデータにおいては偶然それなりの改善を示しただけの可能性もあります。 同様に,モデルが複雑になるほど自由度も大きくなり共分散構造の乖離度も大きくなりやすいと考えられます。 「f_E =~ Q1_1を追加すると良い」ということが,本当に「Q1_1が因子Eを反映した項目である」ことを示しているのかは,実質的な意味に基づいてよく考える必要があるでしょう。

ということで,モデルの修正の際には,パスを追加・削除することが自分の仮説と照らし合わせて受け入れられるかをよく考えるようにしましょう。

実践場面でよく見られる―が適切に用いられていないことも多い(吉田 他,2020)―修正としては, 図 7.14 のように独自因子の間の相関を追加するパターンがあります。 例えば時系列モデルにおいて,異なる時期に聞かれた同一の項目間においたり,あるいはDIFのように特定の属性などが影響していると言えそうな場合には妥当なパスの追加だと思われます。 このような場合にも,パスを追加する場合にはなぜそのパスを追加するべき(しても問題ない)と考えたかをきちんと説明するようにしましょう。 裏を返せば,そのパスが意味するところが説明できないような場所には,いくら適合度が改善するにしてもパスを追加しないほうが良いだろう,ということです。

また,モデルの修正は割と終わりなき戦いです。 というのも,modificationIndices()で出力されるmiは必ず正の値を取ります。 絶対的な適合度指標と同じように,パスを追加すればするほど当てはまりは良くなるということです。 モデルの修正を行う場合には,

- まず仮説で立てたモデルを基準として

- もしそのままでは当てはまりが良くない(適合度指標が許容範囲を超えている)という場合にのみ

- もともとの仮説で受け入れられるパスの追加・削除を少しずつ行い

- 適合度指標が許容範囲になったらその時点でストップ

くらいに考えておくのが良いのではないかと思います。多くの場合は仮説で立てたモデルが(本当に考え抜いて構築されたのならば)理論的には最も整合的なはずなので,そこからあまり変えないようにできればそれに越したことは無いわけです。 適合度指標の許容範囲についてはゼロイチで判断できるものではないですが,自分が納得できる&査読者などを納得させられるくらいの値であれば良いでしょう。

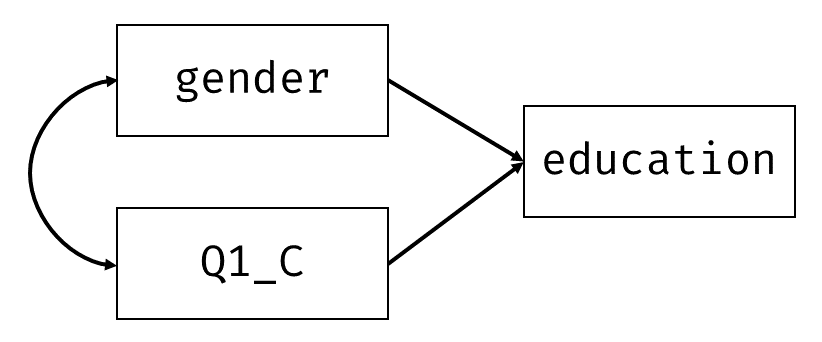

7.8 カテゴリカル変数のSEM

資料の前半で見てきたように,SEMは因子分析や回帰分析を内包する分析手法です。 したがって,カテゴリカル変数を扱う場合も因子分析や回帰分析と同じように考えればOKです。

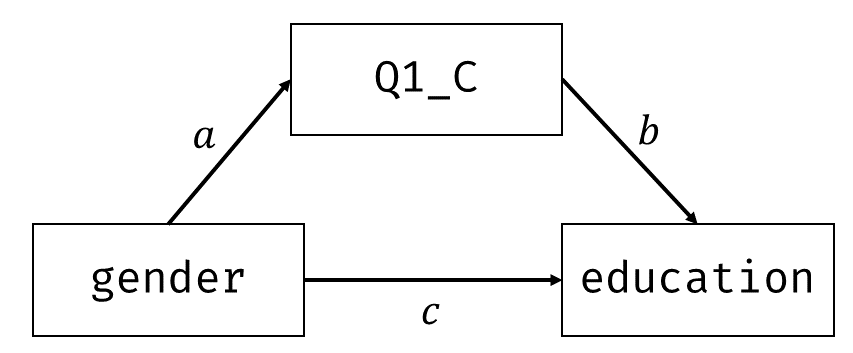

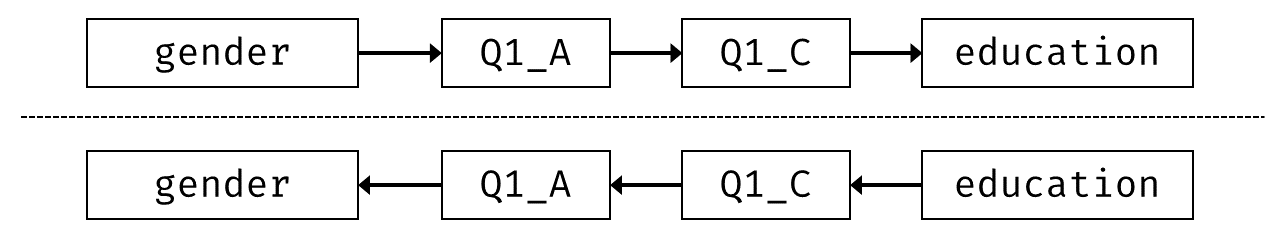

7.8.1 内生変数がカテゴリカルな回帰分析・パス解析

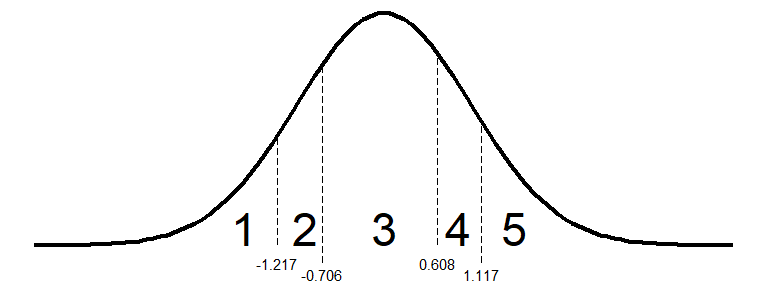

内生変数,つまり結果変数がカテゴリカルな場合,ポリコリック相関のように,本来連続的なものが閾値で切り分けられてカテゴリになっている,と考えると良さそうです。 ここでは, 図 7.15 のように,性別と勤勉性(Q1_C)がカテゴリカルな内生変数である「学歴」に与える影響を考える回帰分析モデルを実行してみましょう17。

lavaanには,内生観測変数がカテゴリカルであることを示す引数orderedが用意されています。

lavaan 0.6-20 ended normally after 3 iterations

Estimator DWLS

Optimization method NLMINB

Number of model parameters 6

Used Total

Number of observations 2232 2432

Model Test User Model:

Standard Scaled

Test Statistic 0.000 0.000

Degrees of freedom 0 0

Parameter Estimates:

Parameterization Delta

Standard errors Robust.sem

Information Expected

Information saturated (h1) model Unstructured

Regressions:

Estimate Std.Err z-value P(>|z|)

education ~

gender 0.007 0.047 0.150 0.881

Q1_C 0.006 0.005 1.233 0.217

Thresholds:

Estimate Std.Err z-value P(>|z|)

education|t1 -1.217 0.123 -9.858 0.000

education|t2 -0.706 0.123 -5.757 0.000

education|t3 0.608 0.124 4.914 0.000

education|t4 1.117 0.125 8.961 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.education 1.000 結果を見ると,Variances:のところにあるeducationに,潜在変数であることを示す.がついて.educationになっており,その値が1に固定されています。 また,表示はされていないのですが,.educationの平均値は自動的に0に固定されてパラメータ推定が行われます18。 すなわちカテゴリカルな内生変数を扱う場合には,その変数(ここではeducation)の背後にある連続的なものが平均0,分散1に標準化された値として考慮されている,ということです。

そのもとで,Thresholds:のところには各カテゴリの閾値が表示されています。図4.8に当てはめると 図 7.16 のような状態だということです。

7.8.2 (おまけ)外生変数がカテゴリカルな回帰分析・パス解析

「外生変数がカテゴリカル」ということは,回帰分析の説明変数がカテゴリカルな場合と同じように考えたらOKです。 すなわち,その変数が二値カテゴリカルであればそのまま使用してよく,多値カテゴリカルであればダミー変数に置き換えることで対応可能です。 例えば多値カテゴリカル変数であるeducationを説明変数とする, 図 7.17 の回帰分析モデルを考えます。

educationは順序カテゴリカル変数ですが,いったん順序を無視してダミー変数へ変換してみます(順序性を考慮したダミー変数化はあとで説明)。 ダミー変数をデータフレームに追加する簡単な方法として,contr.treatment()関数を利用する方法があります19。

contr.treatment()関数では第一カテゴリを基準カテゴリとしたダミー変数を作成してくれます。

2 3 4 5

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

3 0 1 0 0

<NA> NA NA NA NA

2 1 0 0 0

<NA> NA NA NA NA

1 0 0 0 0

<NA> NA NA NA NA

<NA> NA NA NA NA

1 0 0 0 0

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

<NA> NA NA NA NA

5 0 0 0 1

2 1 0 0 0

1 0 0 0 0

3 0 1 0 0

5 0 0 0 1

[ reached 'max' / getOption("max.print") -- omitted 2407 rows ]contr.treatment()で作成したダミー行列のdat$education行目を取る,ということは,

education == 1の人なら0 0 0 0の行education == 2の人なら1 0 0 0の行education == 3の人なら0 1 0 0の行education == 4の人なら0 0 1 0の行education == 5の人なら0 0 0 1の行education == NAの人ならNA NA NA NAの行

が返ってくるわけです。これをもとのdatの存在しない列名に代入してあげればOKですね。

こうして作成したダミー変数を入れたモデルを作成して実行しましょう。

lavaan 0.6-20 ended normally after 1 iteration

Estimator ML

Optimization method NLMINB

Number of model parameters 7

Used Total

Number of observations 2232 2432

Model Test User Model:

Test statistic 0.000

Degrees of freedom 0

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Regressions:

Estimate Std.Err z-value P(>|z|)

Q1_A ~

age 0.068 0.009 7.470 0.000

edu_2 -0.207 0.417 -0.497 0.619

edu_3 1.097 0.336 3.263 0.001

edu_4 -0.132 0.393 -0.337 0.736

edu_5 0.413 0.394 1.046 0.295

Intercepts:

Estimate Std.Err z-value P(>|z|)

.Q1_A 20.897 0.382 54.641 0.000

Variances:

Estimate Std.Err z-value P(>|z|)

.Q1_A 18.842 0.564 33.407 0.000Number of observationsのところにTotalという値が追加されています。 当然ですが欠測値がある場合にはそのままだと分析が出来ないため,デフォルトでは「分析に使用する変数に欠測が一つもない人」だけを使って分析をしているのです。 今回の場合,education == NAの人は全てのダミー変数がNAになっているので,「educationに回答している人のデータのみ」を使用した結果となっている点には注意が必要かもしれません。

順序カテゴリの順序性を保ったままダミー化する場合は,下の表のようにダミーの効果を加算していく,という方法が考えられます。 カテゴリ2ではedu_2の効果のみ,カテゴリ3ではedu_2 + edu_3の効果,…というようになります。 そして例えばedu_3の係数は,education == 2の人とeducation == 3の人の切片の差を表すことになるわけです。

| education | edu_2 | edu_3 | edu_4 | edu_5 |

|---|---|---|---|---|

| 1 | 0 | 0 | 0 | 0 |

| 2 | 1 | 0 | 0 | 0 |

| 3 | 1 | 1 | 0 | 0 |

| 4 | 1 | 1 | 1 | 0 |

| 5 | 1 | 1 | 1 | 1 |

7.8.3 カテゴリカルな確認的因子分析

確認的因子分析の場合,モデル上は因子得点から観測変数に矢印が引かれているため,これらは全て内生変数として扱われます。したがって引数orderedを使えばOKです。 ということで,前回行った 図 7.3 の単純構造2因子モデルで試してみましょう。

全ての変数を名指しでordered=paste0("Q1_",c(1,2,3,6,7,8))という感じで指定しても良いのですが,もし全ての内生変数である観測変数がカテゴリの場合20,ordered = TRUEとすることで全てカテゴリカルになります。

# まずは普通にモデル式を作成

model <- "

f_1 =~ Q1_1 + Q1_2 + Q1_3

f_2 =~ Q1_6 + Q1_7 + Q1_8

"

# 引数orderedを指定する

result <- cfa(model, data = dat, std.lv = TRUE, ordered = TRUE)

summary(result, standardized = TRUE)lavaan 0.6-20 ended normally after 14 iterations

Estimator DWLS

Optimization method NLMINB

Number of model parameters 37

Number of observations 2432

Model Test User Model:

Standard Scaled

Test Statistic 72.885 100.302

Degrees of freedom 8 8

P-value (Chi-square) 0.000 0.000

Scaling correction factor 0.733

Shift parameter 0.815

simple second-order correction

Parameter Estimates:

Parameterization Delta

Standard errors Robust.sem

Information Expected

Information saturated (h1) model Unstructured

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_1 =~

Q1_1 0.472 0.020 24.163 0.000 0.472 0.472

Q1_2 0.854 0.021 41.558 0.000 0.854 0.854

Q1_3 0.681 0.019 36.343 0.000 0.681 0.681

f_2 =~

Q1_6 0.649 0.020 32.847 0.000 0.649 0.649

Q1_7 0.729 0.019 37.962 0.000 0.729 0.729

Q1_8 0.561 0.018 30.590 0.000 0.561 0.561

Covariances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_1 ~~

f_2 0.271 0.027 10.191 0.000 0.271 0.271

Thresholds:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

Q1_1|t1 -1.887 0.051 -36.934 0.000 -1.887 -1.887

Q1_1|t2 -1.234 0.034 -36.437 0.000 -1.234 -1.234

Q1_1|t3 -0.743 0.028 -26.414 0.000 -0.743 -0.743

Q1_1|t4 -0.326 0.026 -12.588 0.000 -0.326 -0.326

Q1_1|t5 0.434 0.026 16.487 0.000 0.434 0.434

Q1_2|t1 -2.144 0.064 -33.743 0.000 -2.144 -2.144

Q1_2|t2 -1.534 0.040 -38.430 0.000 -1.534 -1.534

Q1_2|t3 -1.179 0.033 -35.716 0.000 -1.179 -1.179

Q1_2|t4 -0.478 0.027 -18.047 0.000 -0.478 -0.478

Q1_2|t5 0.481 0.027 18.127 0.000 0.481 0.481

Q1_3|t1 -1.829 0.049 -37.433 0.000 -1.829 -1.829

Q1_3|t2 -1.303 0.035 -37.181 0.000 -1.303 -1.303

Q1_3|t3 -0.963 0.030 -31.885 0.000 -0.963 -0.963

Q1_3|t4 -0.328 0.026 -12.668 0.000 -0.328 -0.328

[ reached 'max' / getOption("max.print") -- omitted 16 rows ]

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 0.777 0.777 0.777

.Q1_2 0.270 0.270 0.270

.Q1_3 0.536 0.536 0.536

.Q1_6 0.578 0.578 0.578

.Q1_7 0.469 0.469 0.469

.Q1_8 0.686 0.686 0.686

f_1 1.000 1.000 1.000

f_2 1.000 1.000 1.000orderedを指定せずにやった結果と比べると,因子負荷の値(Std.all列)が少し大きくなっていることがわかります。 このあたりは探索的因子分析のときと同じですね。

7.9 多母集団同時分析

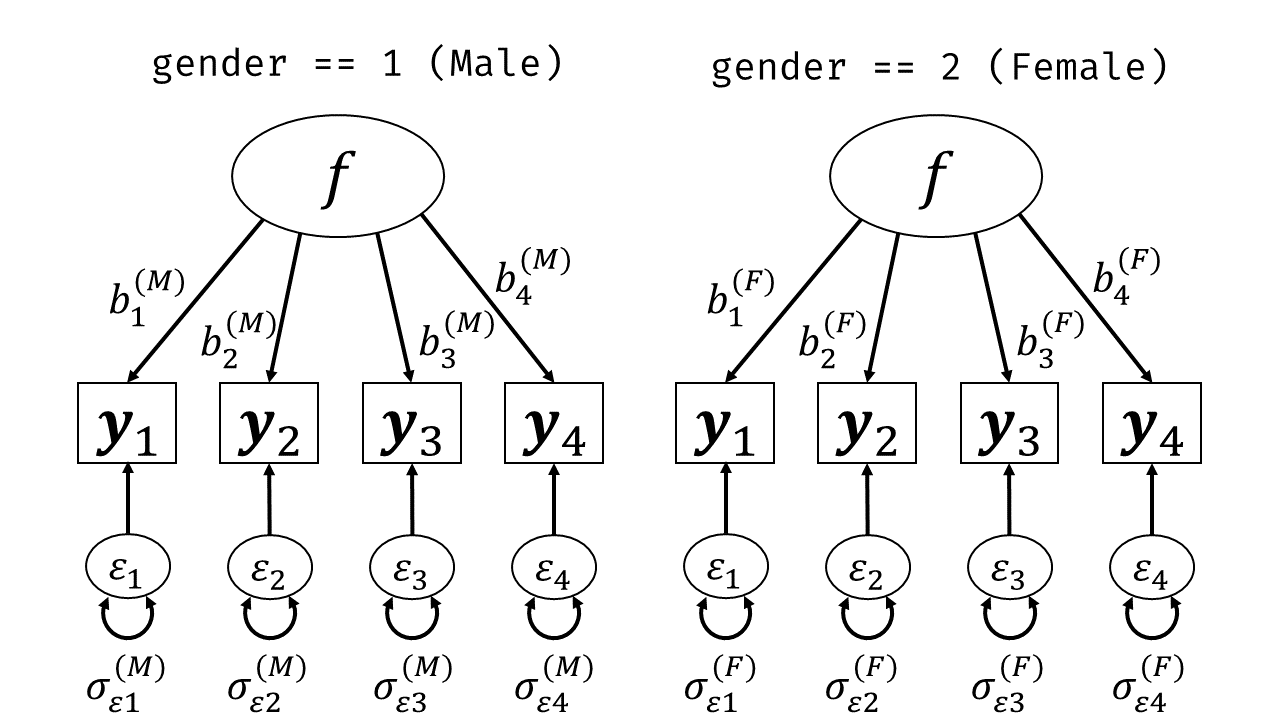

分析結果の一般化可能性を高めるためには「異なる属性間で一貫して同じ結果が得られるか」を検討するのが一つの手段となります。 あるいは異なる属性・集団の間での差異に関心がある場合にも,グループごとに分析を行い結果の一貫性を検討することが多々あります。 例えば因子分析によって得られる因子得点に関して,男性と女性で平均点に差があるか・どちらのほうが平均点が高いかを検討したいとしましょう。 SEMでは多母集団同時分析という枠組みによってこうした分析を行うことができます。

7.9.1 多母集団同時分析の基本的な考え方

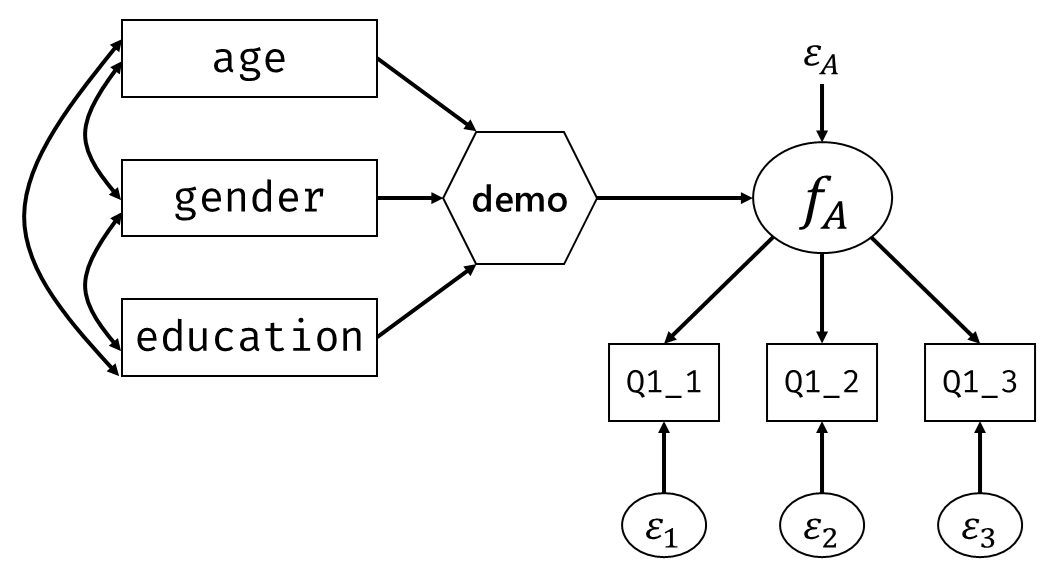

基本的な考え方はシンプルです。 図 7.18 のように,まずデータをグループごとに分けておいて,同じモデルをグループごとに適用し,対応するパラメータの推定値が同じかどうかを評価していきます。 なおここでは,上付き添字はグループごとに異なる係数を表すと思ってください。 つまり\(b_1^{(M)}\)と\(b_1^{(F)}\)は同じ因子から同じ項目への因子負荷ですが,異なるパラメータとして別々に推定される,ということです。

lavaanでは,引数groupに,グループを表す変数の名前を指示してあげればすぐに分析が可能です。

lavaan 0.6-20 ended normally after 43 iterations

Estimator ML

Optimization method NLMINB

Number of model parameters 24

Number of observations per group:

1 802

2 1630

Model Test User Model:

Test statistic 34.458

Degrees of freedom 4

P-value (Chi-square) 0.000

Test statistic for each group:

1 7.472

2 26.986

Parameter Estimates:

Standard errors Standard

Information Expected

Information saturated (h1) model Structured

Group 1 [1]:

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.549 0.058 9.544 0.000 0.549 0.385

Q1_2 0.857 0.051 16.813 0.000 0.857 0.682

Q1_3 0.965 0.054 17.784 0.000 0.965 0.731

Q1_4 0.761 0.059 13.003 0.000 0.761 0.515

Intercepts:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 4.278 0.050 85.060 0.000 4.278 3.004

.Q1_2 4.494 0.044 101.352 0.000 4.494 3.579

.Q1_3 4.347 0.047 93.246 0.000 4.347 3.293

.Q1_4 4.434 0.052 84.932 0.000 4.434 2.999

Variances:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

.Q1_1 1.728 0.093 18.624 0.000 1.728 0.852

.Q1_2 0.842 0.070 11.949 0.000 0.842 0.534

.Q1_3 0.811 0.082 9.916 0.000 0.811 0.465

.Q1_4 1.607 0.094 17.037 0.000 1.607 0.735

f_A 1.000 1.000 1.000

Group 2 [2]:

Latent Variables:

Estimate Std.Err z-value P(>|z|) Std.lv Std.all

f_A =~

Q1_1 0.575 0.039 14.834 0.000 0.575 0.420

Q1_2 0.811 0.032 25.073 0.000 0.811 0.738

Q1_3 0.852 0.037 23.087 0.000 0.852 0.665